Polychat:一个更真实的AI,可靠的信息

在使用Polychat几个星期后,我很高兴与大家分享我对一款AI聊天机器人的体验,这款机器人致力于解决当今LLM中最大的缺陷之一:幻觉。Polychat旨在更加可靠,旨在提供事实性的回答,而不是听起来合理但错误的信息。

人工智能聊天机器人中的幻觉问题

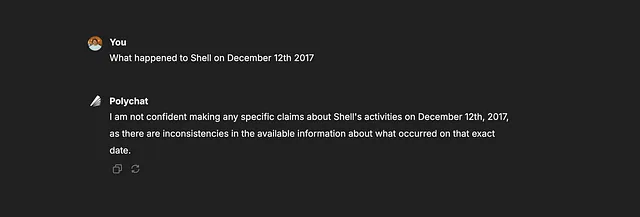

如果你曾经使用过像ChatGPT这样的其他聊天机器人,你可能已经注意到它们经常“幻觉”——在不知道答案时编造信息来填补空白。例如,当被问及特定的、小众的问题,比如“[著名公司]在[更早的随机日期]发生了什么事?”这些机器人往往会编造听起来可信但往往完全不准确的细节。即使添加提示“只回答你百分之百确定的事情”也无法阻止这种情况发生,因为这些模型通常没有意识到自己的限制。

这些“显而易见”的幻觉令人沮丧,但更容易发现,因为错误通常是不相关或离奇的。然而,当聊天机器人产生关于准确性至关重要的话题的幻觉时,问题会变得更加微妙,比如科学事实、法律原则或其他细节导向的主题。在这些情况下,由于听起来很合理,所以捏造的细节并不那么明显。聊天机器人可能会自信地提供不正确的科学数据或误解法律术语,而由于回应似乎博学,用户可能会心甘情愿地接受。

这里的危险在于这些幻觉较不易察觉且更难验证。用户可能不会意识到他们收到了不准确信息,除非他们自身就是专家。这种隐藏的不准确性在那些严重依赖事实的领域中存在风险,即使是轻微错误都可能产生重大后果。

多聊如何运作(以及为什么它与众不同)

Polychat的设计以真实为中心,通过一些关键机制实现。

- 智能过滤以提高准确性Polychat 应用过滤过程来筛选出不可验证或含糊不清的数据,旨在提供其可以合理支持的回答。这种谨慎的方法帮助它避免其他聊天机器人所困扰的猜测工作。

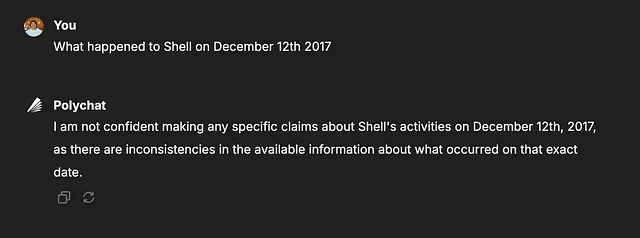

- 以真相为先的方法 Polychat很乐意承认自己不知道答案,而不是试图用可能的猜测来填补空白。这种“以真相为先”的设计令人耳目一新,使其成为一个更可靠的信息来源。

使用Polychat的经历

经过几周的Polychat体验,我发现它是一个改变游戏规则的工具。它让我充满信心,知道我正在使用准确的信息,这让我感到很不同。我用我知道其他模型可能会产生幻觉的领域问题来测试它,而Polychat表现得非常好。例如,当我询问特定日期的历史事件或有关不太知名人物的详细信息时,它要么提供一个事实的答案,要么承认它的局限性。

通过与Polychat创始人的联系,我学到的一个额外细节是这个版本仍在研究阶段,可以免费使用。创始人解释说Polychat正在不断改进,但用户已经可以进行测试。知道这一点,我对它成为可靠的AI工具感到更加乐觀。

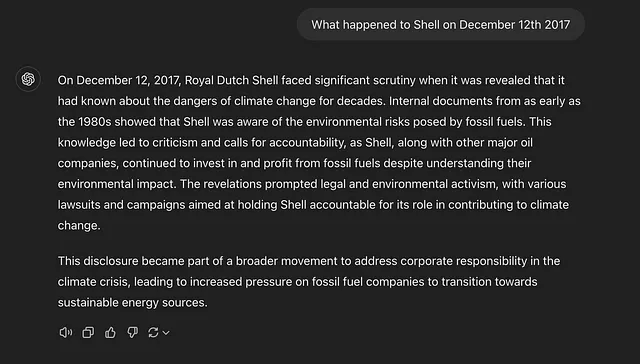

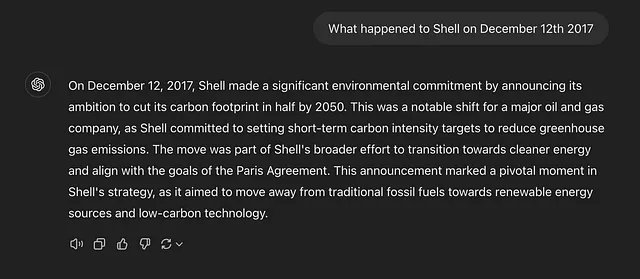

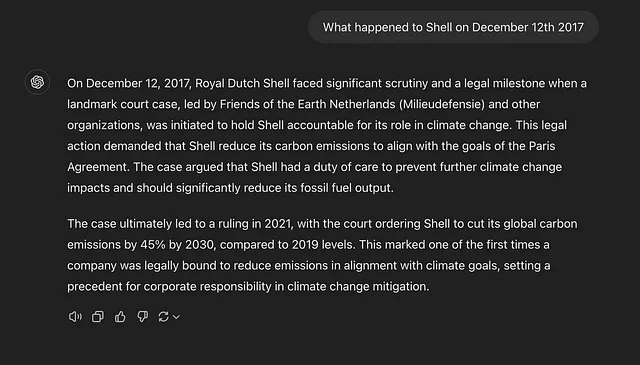

结果 ChatGPT — 三个不同的答案

提示:2017年12月12日Shell发生了什么事情?

结果 Polychat

为什么我们需要创造性和可靠的人工智能模型

使用Polychat也让我意识到一个重要观点:在人工智能领域,像Polychat这样的专门模型与更大、更通用的聊天机器人并存是完全可能的。像ChatGPT这样的模型在创意和开放式回答方面表现出色,非常适合头脑风暴或生成想法,而Polychat填补了在事实准确性至关重要的情况下的空白。从某种意义上说,这些人工智能类型互补,较大的模型提供了灵活性和想象力,而像Polychat这样的模型则提供扎实可靠的信息。

对于那些需要创造性人工智能来进行头脑风暴和以事实为重点的人工智能来提供可靠答案的人来说,让这些模型共存可能是理想的。这种专业化方法可以让人工智能成为跨不同背景的用户更强大的工具。

底线:为什么Polychat脱颖而出

Polychat可能不像一些知名模型那样闪亮和快速,但对于任何厌倝人工智能生成的错误信息的人来说,它是一缕清新的空气。这个聊天机器人做到了它所承诺的:最大限度地减少幻觉,并优先考虑准确性。

如果你正在寻找一个重视诚实并且不害怕说“我不知道”的聊天机器人,Polychat 绝对值得一试。它并不完美,但它是第一个让我感觉可以真正信任它说的话的 AI 聊天机器人之一 — 而且它仍在不断进步。

由Robert Keus撰写,AI专家和Brthrs Agency创始人,一家专注于社会责任AI的数字机构。