苹果智能:正确的人工智能方式?

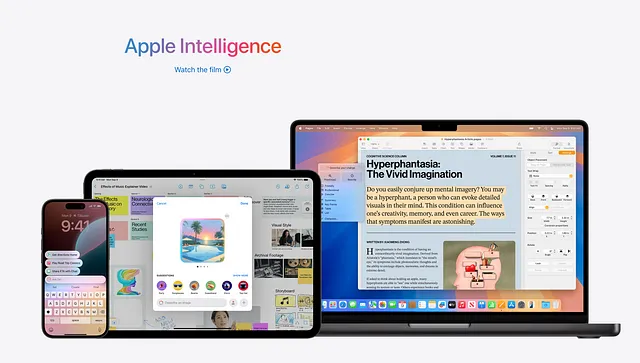

自从今年6月的WWDC以来,大家对苹果的人工智能功能异常兴奋:苹果智能。虽然其他公司像微软或谷歌也在研发类似工具,但苹果专注于让大多数人工智能功能甚至LLMs本地运行在设备上,无需互联网连接。等待了将近半年后,苹果智能终于问世,热度愈发上升。但这是否真的值得呢?你是否真的应该为了人工智能功能而升级到最新的iPhone?让我们来看看。

苹果智能可以做什么?

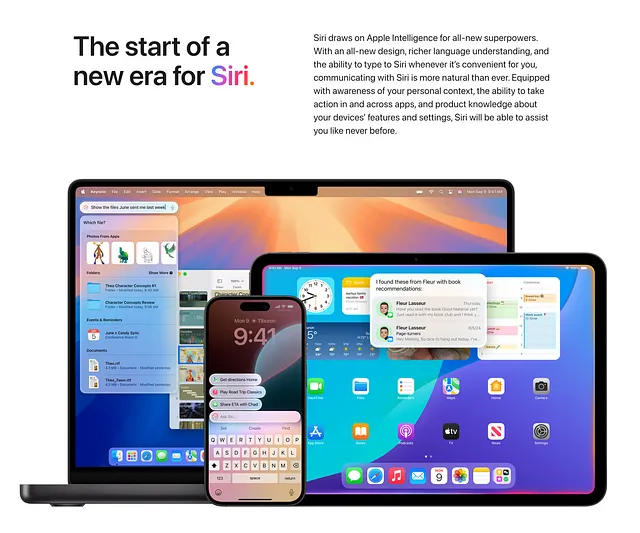

新的Siri

苹果智能带来的最重要的操作系统更新是引入了全新的Siri。这个Siri现在由设备上的LLM驱动,比之前依赖预定义命令的方法大大提高了对自然语言的理解能力。在我的个人体验中,新的Siri终于在理解命令方面超越了谷歌助手和Alexa。例如,当我想向我的日历添加一个新事件时,我只需要告诉Siri有一个新事件或新提醒,几乎可以肯定Siri能够正确理解并为我创建事件。整体来说非常酷。

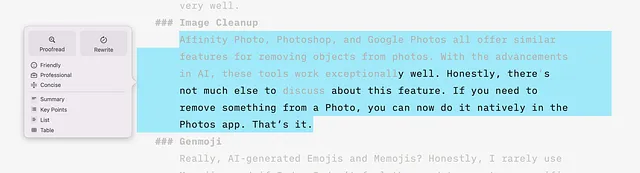

写作工具

我写了相当多的东西,无论是在Medium上写作,为学校写作,还是其他地方。虽然我不太喜欢让人工智能生成所有的内容,但我经常使用ChatGPT来查找和纠正拼写和语法错误。这对我特别有帮助,因为我不是母语使用者,总是会犯错。

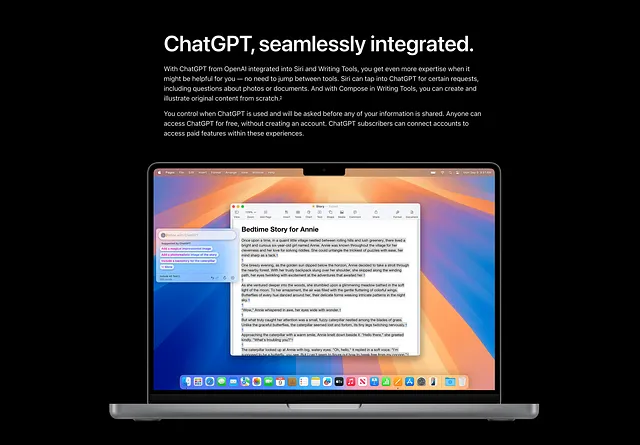

然而,我发现写作工具非常有用。我可以选择系统中任何文本,并请求LLM审校或修改。这不是为了让一切为我做好,而是为了帮助我识别和纠正错误,最终提高我的写作水平。

其他功能,比如总结我的写作,创建表格或项目符号列表,以及改变语气,由于这个原因,我对这些并不感兴趣。

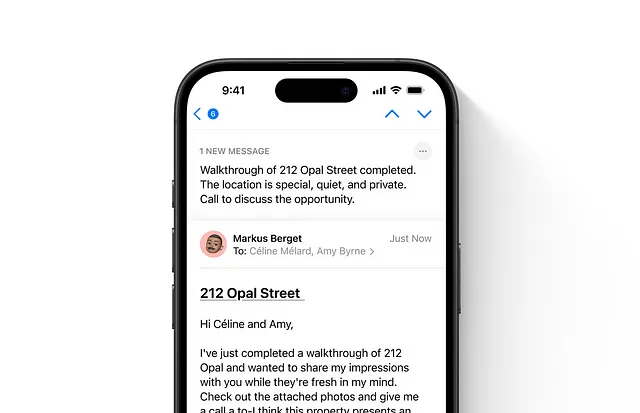

人工智能摘要

苹果智能提供了一个功能,用于总结诸如电子邮件、通知、消息和网站等内容。虽然听起来很有前途,但我以前遇到过这类总结存在问题。它们通常提供过于简洁的总结,省略了关键信息。苹果的实施并没有完全解决这个问题,但它明显比例如Notion的人工智能总结或谷歌的人工智能搜索要好。值得注意的是,电子邮件和通知的摘要尤其有助于帮助我确定哪些值得我关注,哪些可以暂时忽略。然而,由于我不使用Safari作为我的浏览器,我发现网站摘要不太有趣,尽管它们效果非常好。

图像清理

Affinity Photo、Photoshop和Google相册都提供类似的功能,可以移除照片中的物体。随着人工智能技术的发展,这些工具表现得非常出色。说实话,关于这个功能没有什么其他值得讨论的。如果你需要从照片中移除某些物体,现在可以在相册应用程序中直接进行操作。就是这样。

跟磨吉

真的,由AI生成的表情符号和Memojis吗?老实说,我很少使用Memojis,如果我使用,我也不觉得有必要为当前情况专门创建一个。Genmoji不是一个坏功能,但不适合我。

限制

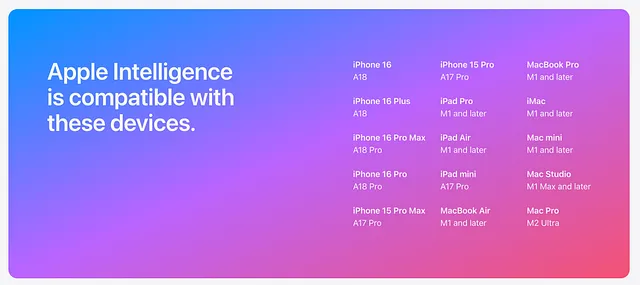

正如你可能已经注意到的那样,我对苹果智能及其功能并不完全信服。然而,这并非我要解决的主要问题。只是有一些苹果特定的事情让我感到真正恼火。其中之一就是硬件要求。

作为一个对计算机科学有着很好理解的人,我完全理解人工智能,特别是LLMs,需要特定的硬件能力才能有效运行。因此,苹果将苹果智能限制在iPhone 15 Pro及更新型号以及所有M系列芯片上的决定是有道理的。然而,像ChatGPT集成这样的其他功能,据说“将在今年晚些时候推出”,也仅限于这些新的高端设备,这让人感到沮丧。苹果想要利用最新的iPhone,但为什么我不能在iPhone 13上调用OpenAI的API呢?

更为重要的问题是Apple Intelligence的有限可用性和混乱的推出。截至目前,它只提供英文(美国)版本,甚至不提供英文(英国)版本,也没有其他语言版本。此外,它需要系统和Siri语言设置设定为美国英语。就我个人而言,我无论如何都已经将我的设备配置成这样了,但由于我住在德国,我经常会遇到德语内容。 —— 真是个惊喜…… Apple Intelligence拒绝总结或更广义地说,使用非英语内容。虽然这是有道理的,因为LLM主要在设备上本地运行,可能对英文进行了精细调整,但在使用它时,这种限制仍然是一个重要障碍。

人工智能正确地完成

我已经提过了,但我真的很喜欢Apple Intelligence总体上。它有它的限制和问题,但我会把它描述为正确的人工智能。

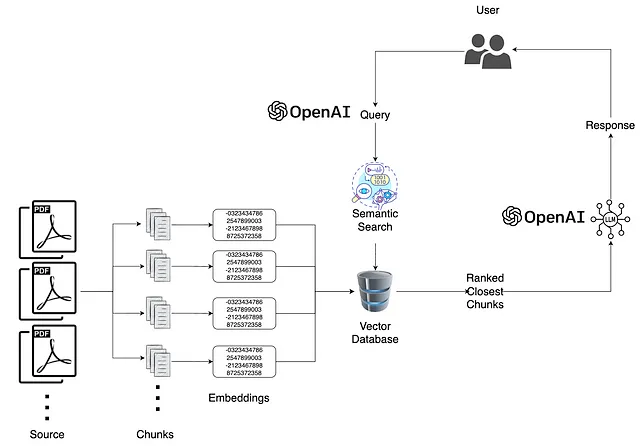

自ChatGPT于2022年11月推出以来,我们共同为OpenAI提供了大量关于我们自己的数据 —— 用于汇总或撰写的文本,访问我们的编码项目,以及各种形式的个人信息。看到像Apple这样的公司采用与传统基于云的AI范式不同的方法令人耳目一新。就我个人而言,我认为我们不应该为了以任何方式使用AI而牺牲我们的隐私和安全。在本地运行LLMs提供了一个有趣的解决方案来实现这一目标。而且我还没有谈到Apple的私有云计算。