目前的自然语言处理:从早期的步骤到今天的人工智能革命

作为一名人工智能爱好者和《钢铁侠》中J.A.R.V.I.S.的粉丝,我一直被机器能够像人类一样轻松理解和沟通的想法所吸引。想象一下一个能够进行深入对话、细致理解并像现实生活中的真正伴侣一样协助的助手——就像J.A.R.V.I.S.对托尼·斯塔克一样。这一愿景令人着迷,引发了我对J.A.R.V.I.S.背后真实科学的好奇心,这种好奇心随着时间的推移不断增长。经过漫长的道路,经过多年的期待,我决定全力以赴探索这段旅程。

与科幻电影中看到的看似神奇的人工智能互动不同,20世纪60年代早期的自然语言处理(NLP)是非常不同的:当时的系统几乎不能解析几个关键词,更不用说理解上下文或语气了。然而,研究人员有着宏伟的梦想,旨在弥合人类和机器之间的沟通隔阂。最初的步骤涉及严格的基于规则的系统——想象一下《星际迷航》早期的计算机,它们能够处理命令,但在掌握“自然”语言之前还有很长的路要走。多年来,语言学理论、符号人工智能和数据驱动方法的突破使我们更接近创造真正对话系统。

今天,我们生活在一个自然语言处理技术几乎支配所有事物的时代。NLP技术已经融入到日常互动中,从谷歌的上下文搜索结果到个性化推荐,再到像Siri和Alexa这样的智能语音助手。就好像电影《钢铁侠》或《她》中的技术最终成为现实,ChatGPT和其他大型语言模型实现了非常逼真的交互。

在这个博客中,我们将通过几十年的进展旅程,从20世纪60年代的突破性实验,一直到2020年代的变革性进步。我们将探讨早期语言模型是如何导致基于规则的系统,统计方法和机器学习是如何革命性地改变了这一领域,最后,深度学习和转换器模型如何塑造了当今的自然语言处理格局。到最后,您将看到我们离那些受到科幻启发的对话式人工智能梦想有多近,这要感谢那些将NLP转变为我们这个时代最具变革性技术之一的创新。

NLP 的诞生:从规则到基础理解

自然语言处理的旅程始于一个时代,在那个时代,计算机更像是复杂的计算器,而不是我们今天所知的强大系统。在1960年代,研究人员刚开始探索机器如何理解语言。这个概念,直到那时,一直被限制为科幻小说。NLP的早期实验是雄心勃勃的,但有限,通常需要计算机遵循严格的、手工编码的规则来理解语言。这些系统缺乏灵活性,只能处理特定的短语或命令。

随后,上世纪70年代和80年代看到了符号和基于规则的系统的发展,这些系统继续进行渐进式改进。研究人员在很大程度上从语言学理论中借鉴,并手动构建基于语法的规则来教会计算机如何形成基本的句子结构并识别文本中的模式。像SHRDLU这样的程序,是上世纪70年代初期的一款自然语言理解计算机程序,能够在有限的环境中理解简单的指令,比如一个“方块世界”,用户可以让计算机移动虚拟物体。SHRDLU具有开创性,因为它展示了机器如何遵循指令并展示出一定程度的理解能力-即使仅限于一个狭窄定义的世界。

NLP的早期岁月充满了试错,研究人员通过基于规则的逻辑试验和不断突破机器理解能力的极限。但随着更多的研究人员进入这一领域,人们意识到单纯的严格规则并不足以理解语言的复杂性。这些基础性年份为NLP铺平了一种更加灵活且数据驱动的方法,研究人员将目光投向打破手工编码语言规则的限制。这种转变为之后几十年即将到来的统计模型和机器学习突破奠定了基础,将NLP推向更贴近现实世界语言理解的阶段。

20世纪NLP的演变:从启发式到数据驱动模型

随着20世纪的展开,自然语言处理从基于规则的、手工编码系统过渡到更动态的方法,逐渐接近真正的语言理解。这一进化经历了三个关键阶段:60年代到70年代的基于规则的系统,80年代引入统计模型,以及90年代机器学习和概率方法的兴起。

1960年代至70年代:基于规则的时代 在早期,自然语言处理是建立在手工制作的符号规则之上的,旨在捕捉语言模式。在这个时期,重点是利用语法规则和句法结构来解析文本,从而创建了像ELIZA和SHRDLU这样的程序。然而,这些系统严重受制于它们对严格、手工编码规则的依赖。它们只能理解狭窄领域内的基本指令,并且无法理解语言或背景的细微差别。尽管在当时是开创性的,基于规则的自然语言处理在处理人类语言的多样性和模糊性上遇到了困难。

上世纪80年代:统计和概率方法的崛起到了上世纪80年代,人们渐渐认识到符号系统无法捕捉自然语言的复杂性。研究人员开始探索统计方法,这种转变主要受到数字化文本数据日益增加的影响。马尔可夫模型和贝叶斯推断等技术使计算机能够根据概率而不是预先编程的规则来识别单词序列。这种统计方法使系统能够建模语言模式,并通过从真实例子中学习来改善性能。

在这一时期值得注意的成功案例是IBM的统计机器翻译项目,该项目利用大量的双语文本来自动学习语言翻译。该项目表明,统计方法可以胜过死板的基于规则的方法,特别是在处理更复杂的语言任务,如翻译方面。

1990年代:机器学习和数据驱动模型的引入在1990年代,自然语言处理领域迎来了最重要的飞跃:采用机器学习技术。随着计算能力的增加和数据的更易获取,研究人员开始在大型文本语料库上训练模型,以揭示模式,而无需明确编程语言规则。决策树、隐藏马尔可夫模型(HMMs)和早期神经网络等算法使系统能够从数据中“学习”,将自然语言处理推向真正的语言理解。

在这段时间里,诸如词性标注、情感分析和命名实体识别等NLP应用开始出现。这种转变标志着一个新时代的开始,因为数据驱动的模型证明比传统方法更具适应性和能力。统计机器学习为NLP中许多基础任务奠定了基础,为后来世纪出现的更复杂的神经网络铺平了道路。

20世纪为我们今天所认识的NLP系统奠定了基础,每十年都增加了复杂性和精致性的层次。到世纪结束时,NLP不再局限于实验室;它开始进入现实世界的应用程序,为21世纪庞大、数据密集和日益智能的NLP模型打下了基础。这种从规则到数据驱动理解的转变改变了NLP,为接下来深度学习和神经网络的飞跃做好了准备,以一种早期先驱者只能梦想的方式塑造了该领域。

打下现代NLP的基础:2000年至2020年

在2000年到2020年期间,自然语言处理(NLP)稳步发展,取得了重大进步,但并没有看到近年来的重大突破。在这个时代,该领域逐渐从统计模型转变为神经网络,为深度学习和变压器架构奠定基础,这些架构在2020年后将彻底改变自然语言处理。

早期2000年代:统计模型和基于语料库的学习

在21世纪初期,自然语言处理系统主要是由统计方法驱动的,依赖于大量的文本数据或“语料库”来识别语言模式。像N-gram、隐马尔可夫模型(HMMs)和概率模型等技术成为机器翻译、情感分析和词性标注等任务的标准。这些方法使机器能够基于概率预测语言结构,大大提高了拼写检查和关键词匹配等任务的准确性。

在这段时间内,像隐含狄利克雷分配(LDA)用于主题建模和支持向量机(SVM)用于文本分类的工具变得流行,标志着朝着基于数据驱动的方法转变,可以根据真实世界的使用情况进行调整。

2000年代中期:向神经网络的转变

到了2000年代中期,自然语言处理研究人员开始尝试神经网络,受到他们在机器学习的其他领域取得成功的启发。2013年引入了词嵌入技术,比如Word2Vec,这是一个重大的飞跃。词嵌入使得模型能够将单词表示为高维空间中的密集向量,根据它们与其他单词的关系捕捉单词的意义和上下文。这标志着从传统的词袋表示转变为对语言更加微妙的理解,因为含义相似的单词现在在向量空间中被映射得更近。

循环神经网络(RNNs)和长短期记忆(LSTM)网络,旨在处理序列数据,也在自然语言处理领域获得了较大成功。这些模型能够学习长序列中单词之间的依赖关系,使它们特别适用于语言任务,如机器翻译和文本生成。

2010年代后期:预训练模型的黎明

随着计算能力和数据供给持续增长,预训练语言模型开始成为自然语言处理的一个强大工具。通过在大型文本语料库上训练,这些模型可以被细调用于特定任务,使得自然语言处理更加可靠且适用于各种应用。OpenAI在2018年推出的生成式预训练变换(GPT)模型是其中最早的例子之一。它展示了预训练模型能够以出色的流畅性和一致性生成文本,胜过许多传统方法。

2018年,谷歌发布了BERT(来自转换器的双向编码器表示),这是一项具有突破性意义的发展。BERT引入了双向训练,使模型在解释单词时能考虑左右上下文,显著提高了其对语言细微差异的理解。BERT的架构还帮助将转换器确立为NLP的主导架构,尽管它们的全部潜力将在未来十年中才能实现。

为新时代铺设舞台

到2020年,自然语言处理已经发展到一种程度,能够以令人印象深刻的准确度处理任务,但仍然在理解和生成类似人类的文本方面存在局限。然而,在这个时期开发的模型为基于变压器的模型的爆炸和今天我们看到的功能强大的对话人工智能奠定了基础。这些在2020年之前的嵌入、RNN、LSTM和变压器的进步将使从胜任的语言模型跃升为真正的对话系统,使我们更接近实现人类化人工智能互动的梦想。

现代自然语言处理:深度学习革命和Transformer的兴起

自2020年以来,NLP经历了一次巨大的变革,得益于深度学习的进展和变压器模型的爆炸式增长。这个时期标志着NLP进入了一个新时代,模型在语言理解和生成方面取得了前所未有的能力,逐渐接近了能像人类一样理解和回应的对话人工智能的梦想。

Transformer模型和迁移学习的兴起

Transformer 架构是由 Vaswani 等人于 2017 年引入的,为这场革命奠定了基础,但直到 2020 年代,transformers 才真正占据了中心舞台。Transformers 超越了递归神经网络(RNNs)和长短期记忆(LSTM)模型的顺序特性,实现了文本序列的并行处理。这使它们能够扩展到庞大的数据集和训练运行,捕捉文本长段落中的上下文和依赖关系。

变形金刚引入了一种称为自注意力的技术,使模型能够根据其他单词之间的关联来权衡每个单词,而不考虑其在句子中的位置。这种机制极大地改进了上下文的处理,使变形金刚能够把握微妙的细微差别、成语,甚至一些形式的推理。因此,像BERT(双向编码器从变形金刚中获得的表示)和GPT(生成式预训练变形金刚)系列模型成为现代自然语言处理的支柱,为从情感分析到聊天机器人等各种应用提供动力。

GPT-3 和 大型语言模型(LLMs)

在2020年,OpenAI的GPT-3以其庞大的1750亿参数标志着自然语言处理的一个重要时刻,超越了以往的模型。GPT-3展示了一种与人类非常相似的能力,根据简单提示生成连贯、上下文相关的文本。其发布展示了NLP中规模的力量:随着模型变得更大并且在更多数据上进行训练,它们在语言任务上的表现显著提高。

大型语言模型(LLMs)如GPT-3以及来自OpenAI、谷歌(PaLM)、Meta(LLaMA)等公司的后续模型的出现开启了一个新时代,在这个时代里,自然语言处理系统可以处理像摘要、问答甚至创意写作这样复杂的任务。LLMs 不仅能够生成令人印象深刻的自然语言,而且还可以通过微调和提示进行调整,使它们能够执行任务而无需明确的重新编程。

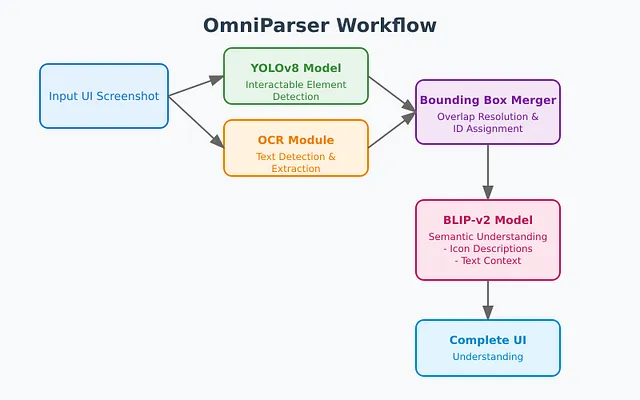

多模态模型和跨任务学习

除了文本之外,现代的自然语言处理(NLP)模型越来越多样化,意味着它们可以处理并理解来自多个来源的数据,例如文本、图像,甚至音频。例如,OpenAI的CLIP模型结合了文本和图像数据,使其能够理解并生成描述性的图像标题。这种集成和解释多种形式的能力已经将NLP的应用领域扩展到新领域,如自动内容生成、视觉问答,甚至创作AI艺术。

跨任务学习,或者叫做少样本学习,也成为现代自然语言处理模型的一个强大特征。像GPT-3和ChatGPT这样的大型语言模型展示了在各种任务上表现出色的能力,只需要很少的示例,就能开发出新的应用程序,几乎不需要特定任务的数据。这使得自然语言处理模型变得更加灵活和易用,促进了在各个行业的快速采用。

未来:道德和实际挑战

随着自然语言处理模型变得更加强大,新的挑战也随之出现。关于虚假信息、偏见和数据隐私的伦理关切已成为突出问题,因为用于训练的庞大数据集有时可能包含有问题的内容。训练大型模型的环境影响也是一个问题,因为训练需要大量的计算资源。

研究人员和开发者正在探索应对这些挑战的方法。像模型蒸馏这样的技术将大型模型压缩为更小、更高效的版本,旨在使自然语言处理更具可持续性。此外,Hugging Face的Transformer库等开源项目已经使自然语言处理民主化,使更多人能够尝试强大的语言模型,并为伦理指南的制定做出贡献。

对话人工智能的新时代

自然语言处理 (NLP) 的现代时代被界定为与实现科幻中对话型人工智能愿景的接近。像ChatGPT、Bard 和Claude这样的模型已经为用户互动设立了一个新的基准,展示了我们离拥有真正对话感的人工智能伙伴和助手有多么接近。这些模型通过大规模数据集训练并使用强化学习等技术(RLHF)进行优化,提供一个个性化、响应迅速且不断改进的体验。

自2020年以来,自然语言处理(NLP)的飞跃是巨大的,创造了一个充满潜力的未来,深化了人机互动。随着持续的研究和发展,NLP正处于改变行业、重新定义沟通,并不断接近实现像《钢铁侠》或《她》等小说中所描绘的人工智能的边缘。