ChatGPT是如何工作的?了解AI对话背后的机制

ChatGPT是由OpenAI开发的先进对话人工智能模型,在人工智能和自然语言处理(NLP)领域是一种革命性工具。它是建立在一种强大模型GPT(Generative Pre-trained Transformer)之上的,使其能够理解和生成类似人类的文本。但它实际上是如何工作的呢?本文深入探讨了ChatGPT的内部工作原理,探索了使其成为如此多才多艺的人工智能工具的架构、训练和运行技术。

GPT的基础知识:什么意思?

“GPT”代表生成式预训练变压器,主要包括三个概念:

- 生成的:ChatGPT根据用户输入生成新的文本响应。

- 预训练:该模型在大规模数据集上进行训练,然后再进行针对特定任务的微调。

- 变压器:这是使模型能够高效处理和生成连贯文本的架构。

GPT属于一类模型,称为transformers,最初由Google研究人员于2017年引入。Transformers在自然语言处理任务中表现出色,因为它们能够学习序列数据中的关系,使它们成为理解和生成人类语言的理想选择。

变形器架构: ChatGPT的核心

变压器架构是ChatGPT的核心。与传统的神经网络不同,传统的神经网络按顺序处理数据,而变压器可以一次处理整个句子。这种方法使用两个主要部分:

- 编码器:这部分解释输入数据,提取关键信息并识别单词之间的关系。

- 解码器:它接收编码数据并生成输出文本。

然而,ChatGPT 使用的是仅解码器模型,因为它专注于生成文本而不是同时解释输入和输出。变压器依赖于一种称为注意力机制的东西,这有助于ChatGPT集中于句子中的重要单词或短语。注意力机制使ChatGPT能够优先考虑相关性更高的单词,从而产生更具上下文准确性的响应。

训练ChatGPT: 从数据到理解

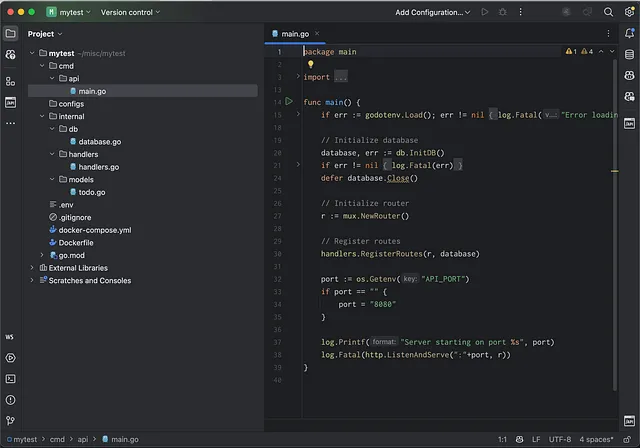

ChatGPT的训练过程分为两个阶段:预训练和微调。

- 预训练:在预训练期间,ChatGPT接触到大量的互联网文本,涵盖了各种主题、风格和语调。这个阶段使模型学习语言模式、单词之间的关系和一般信息。然而,它不知道具体内容,也没有超出其上次训练截止点的事件知识,因为它没有访问实时数据。预训练步骤允许ChatGPT获得广泛的语言能力和基本的推理能力。

- 微调:在这个阶段,模型使用更窄的数据集进行微调,并由人类训练师进行监督。OpenAI使用人类反馈的强化学习(RLHF)来帮助改进ChatGPT的回答,使其更有用、安全,并符合人类的期望。在RLHF期间,训练师提供理想的回答,AI调整其预测以匹配这一反馈。这一步是改善回应质量、减少偏见并使模型行为符合道德准则的重要步骤。

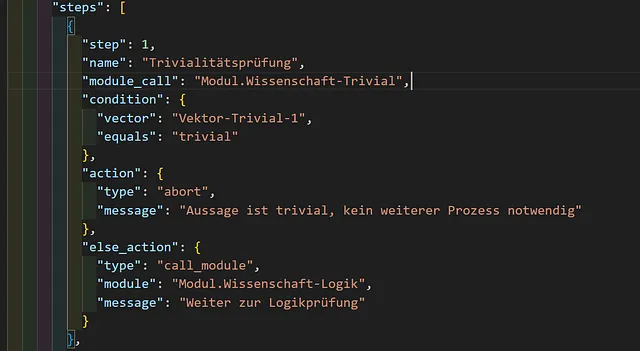

ChatGPT如何生成回复?

当你输入一个问题或提示时,ChatGPT会通过预测最有可能的单词序列生成一个答案。以下是它的工作原理:

- 令牌化:输入文本被分成称为令牌的小单元。每个令牌可以短至一个字符或长至一个词,取决于语言结构。

- 上下文理解:ChatGPT使用其注意力机制,分析每个标记的上下文,以理解提示的整体含义。

- 生成预测:ChatGPT通过逐个标记选择最有可能的下一个词来生成预测。这种概率方法依赖于先前看到的语言模式。在完成句子中的每个单词时,它会更新内部状态,根据新的上下文来优化预测。

- 温度和Top-P抽样:在生成过程中,ChatGPT使用两个关键参数——温度和Top-P抽样——来控制其响应的随机性。更高的温度会导致更多样化的响应,而Top-P抽样允许模型从最可能的候选词汇中选择单词。

- 响应构成:最后,ChatGPT将选定的标记组合成连贯的句子,然后将它们作为响应返回。

ChatGPT的限制和挑战

尽管它有着很强大的功能,ChatGPT也有一些限制:

- 知识截断:ChatGPT在其上次训练期间之后无法获得事件或发现的知识。

- 倾向于“产生幻觉”:该模型有时会生成听起来合理但不正确的信息。

- 上下文保留:ChatGPT在对话中有有限的记忆,这可能导致在长时间讨论中失去上下文的跟踪。

这些限制是研究的活跃领域,开发人员的目标是使未来的模型更加可靠和准确。