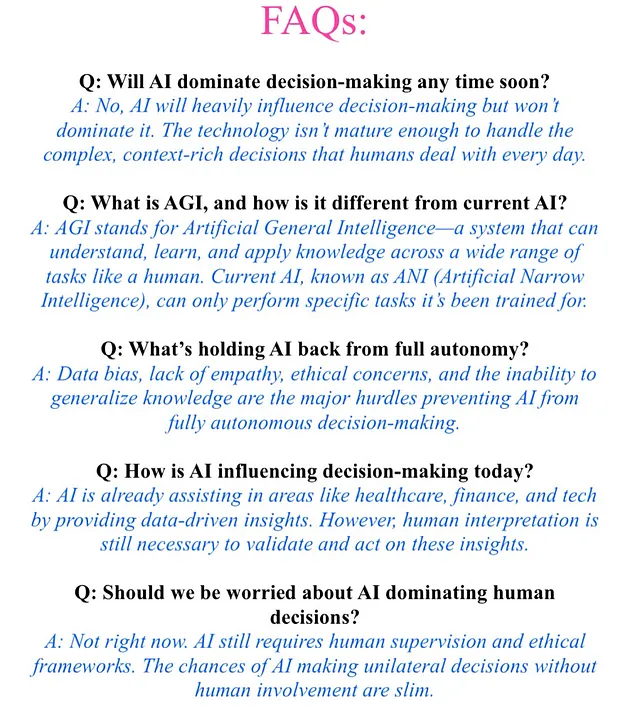

在不久的将来,人工智能(AI)会主导人类决策吗?

如果我们继续发展人工智能到其最大潜力,人类和机器驱动决策之间的界限将显著模糊,但是主导权呢?

坦率地说,至少在不久的将来是不可能的。人工智能擅长分析数据、发现模式和自动化流程,但它缺少两个关键元素:语境和情感。人工智能通过算法和机器学习模型运作,这在特定任务上非常高效,但无法理解大局。例如,人工智能可以建议在公路旅行中采取最有效的路线,但它不会知道你更喜欢风景秀丽的驾驶路线而不是高速公路-这就是人类的感觉。

人工智能已经在金融(算法交易)、医疗保健(医疗诊断)甚至消费科技(个性化推荐)等领域处理决策。但让我们不要混淆这一点。这些系统虽然强大,但并非自主的。人类因素仍然至关重要,使这些决策有意义。人工智能无法完全理解其建议的伦理影响或道德细微差别。

好吧,先听我解释一下!

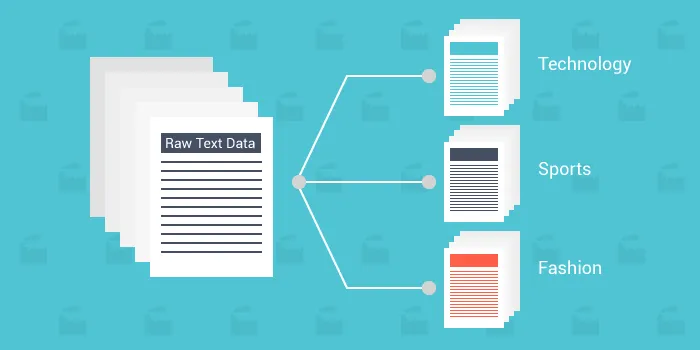

以下是真正让我感兴趣的事情:当人们说AI可能“主导”决策时,他们实际上是在谈论AGI(人工智能通用智能)- 在那一点上,机器可以理解、学习和应用知识,涵盖广泛的任务领域,就像人类那样。但我们仍处于ANI(人工狭义智能)阶段。当前的AI系统设计用于特定目的,如图像识别或自然语言处理(NLP),而不是用于类似人类一样的普遍决策。

为了真正掌控人工智能,我们需要在几个方面取得重大进展:

- 概括能力:如今的人工智能只能执行其明确训练过的任务。真正的决策自主性需要一个能够在不需要人类干预的情况下即兴学习新事物的人工智能。

- 道德框架:即使人工智能可以自行做出决定,我们仍需要制定严格的法规,以确保这些决定符合人类的道德标准。想象一下人工智能负责制定政治政策或军事战略 - 这是一个我们尚未准备打开的潘多拉魔盒。

- 偏见和公平性:人工智能系统从它们训练的数据中继承了偏见。在我们解决数据偏见问题之前,让人工智能负责决策可能导致结果偏向或歧视性。

人工智能的决策能力取决于其所接收的数据。人工智能缺乏共情、情感智力和常识。(但它正迅速进步)这些品质在人类决策中至关重要,特别是在复杂或伦理挑战的情况下。当然,人工智能可以提出行动建议,但在相当长的时间里,最终决定仍需要人类监督。

让我们以自动驾驶汽车为例。人工智能可以在毫秒内计算出最安全或最有效的路线,但是如果突发的、无法预测的事件发生,系统可能会遇到困难。另一方面,人类有能力理解一种分秒决策的情感和伦理重量,比如选择撞击障碍物还是转向避免碰撞。

那么,人工智能面临的障碍是什么呢?

答案具有多层结构:

- 缺乏同理心

- 数据偏见

- 道德挑战

- 概括