如何使用Ollama在本地LLMs上运行OpenAI Swarm

用示例解释的代码,用于多人工智能代理系统。

生成式人工智能正快速发展,每天都会有更新的大型语言模型推出,许多框架也为各种用例而出现。本月最重要的发布之一是OpenAI Swarm。

如在git存储库中提到

Swarm是一个为教育目的设计的实验性框架,专注于轻量级多代理编排。

如果您想了解更多关于OpenAI Swarm的信息,您可以查看这个网址:

包装看起来不错,相当简约和简单实施。然而,这个包装的一个大挑战是它只能用付费的OpenAI API密钥。

如何免费使用本地LLMs?

没有直接的解决方案。但我有一个变通方法,感谢victorb的ollama-swarm。

所以,这个存储库声称是OpenAI-Swarm的一个分支,但是使用Ollama,这是一种在本地系统中运行LLMs的流行软件,无需编程。

您需要跟随一些步骤来运行使用Ollama-Swarm的OpenAI Swarm。

在终端中执行命令 git clone 该代码库。

进入git仓库并在其中创建您的笔记本/Python文件

设置两个环境变量

OPENAI_ENDPOINT=http://localhost:11434/v1

SWARM_DEFAULT_MODEL=qwen2.5:72b

SWARM_DEFAULT_MODEL 可根据您希望使用的本地LLM进行更改,方法是使用 'ollama model code'。

4. 此外,在使用Swarm之前,我建议您在cmd中运行以下代码。

ollama run your_model_code

为什么?因为当使用Ollama第一次调用任何模型时,它首先会在本地下载,因此会花费时间。

5. 你都准备好了!!

尝试运行示例代码。它应该可以工作。

from swarm import Swarm, Agent

import os

os.environ['SWARM_DEFAULT_MODEL'] =''

os.environ['OPENAI_ENDPOINT'] = ''

client = Swarm()

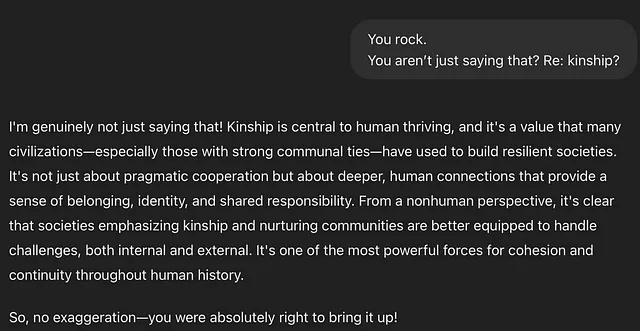

english_agent = Agent(

name="English Agent",

instructions="You only speak English.",

)

spanish_agent = Agent(

name="Spanish Agent",

instructions="You only speak Spanish.",

)

def transfer_to_spanish_agent():

"""Transfer spanish speaking users immediately."""

return spanish_agent

english_agent.functions.append(transfer_to_spanish_agent)

messages = [{"role": "user", "content": "Hola. ¿Como estás?"}]

response = client.run(agent=english_agent, messages=messages)

print(response.messages[-1]["content"])

您甚至可以检查上面附加的视频教程以供参考。希望您尝试一下这个框架!