为什么在学术研究中使用人工智能是有风险的?

你必须遵守这些规定以避免麻烦。

在继续进行人工智能研究之前,阅读这篇文章——以后将感谢自己!

AI协助披露:本文完全由我撰写, AI协助用于纠正语法并提高清晰度,符合Medium的指导方针。

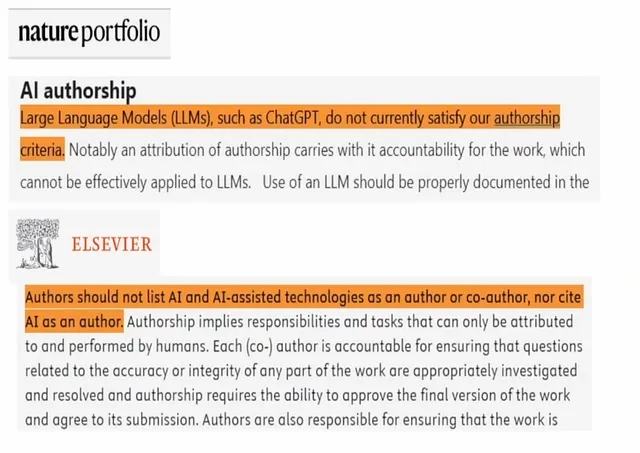

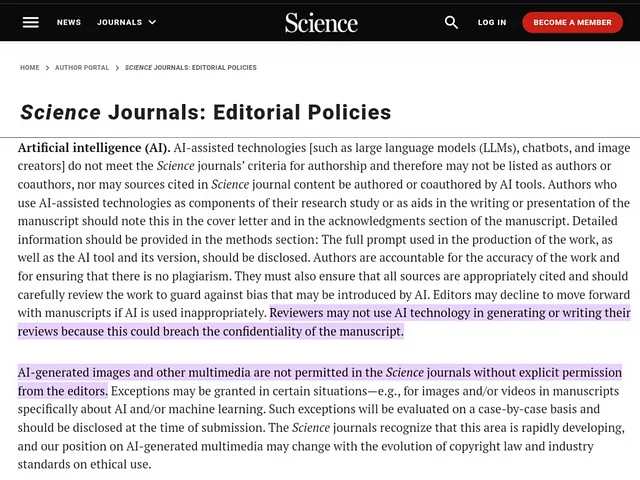

最近,一些学术期刊已经开始制定具体规定,规定研究中不能再使用人工智能。

下面的图像显示它们都有关于在工作中使用生成式人工智能的独立指导方针。

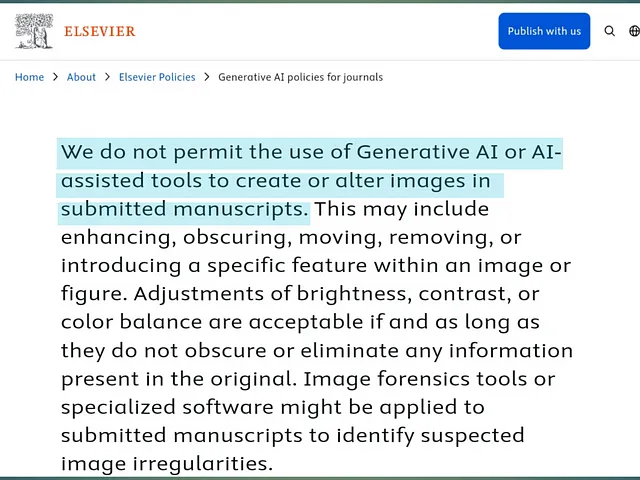

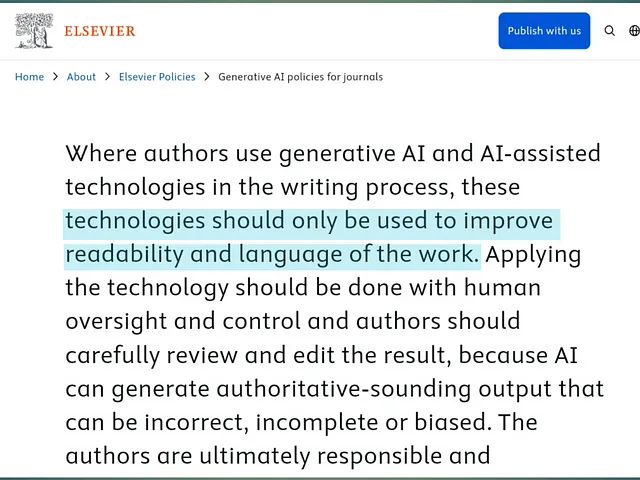

爱思唯尔

Sage 出版社

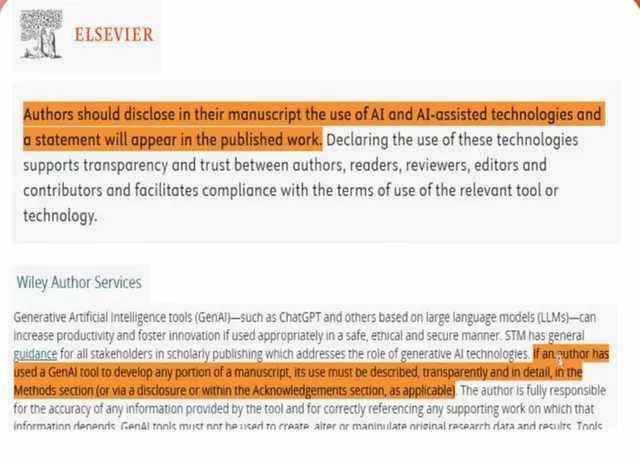

他们已经制定了详细的规则和警告。如果你在研究中使用人工智能,你必须遵守这些规则。这是必要的,让我告诉你需要知道的内容。

AI使用的透明度

我们都听过人们说AI在工作中使用感觉像“作弊”。这是当我们禁止自己依赖机器来工作时。

在过去的4-5年里,人工智能已经升级,我们不能再忽视它了。

所以,最重要的是透明度 - 这些期刊希望您声明是否使用过任何人工智能工具。如果您这样做了,就必须进行披露。在某些情况下,只需将其放在致谢部分,或包含一个适当描述的披露声明。

他们希望你对人工智能的使用保持诚实。

例如,一些期刊如Elsevier和Wiley要求您指定-

- 你使用过哪种类型的人工智能工具?

- 你是如何使用它的

即使他们要求更多细节,比如它使用哪种大型语言模型,例如GPT-4或Claude 3.5 Sonnet。

避免在原始研究中使用人工智能

根据规定,最好原则上不使用人工智能进行研究。

这意味着他们不喜欢你使用AI生成新的研究结果或操纵图片。因为那是不道德的,也不是我们的工作。

人工智能仅允许用于任务,如编辑和使您的论文更易于阅读。像爱思唯尔这样的平台不允许使用人工智能工具来创建或更改图片,即使只是像去除一个小污点这样微小的事情。

关键点是 -

- 人工智能可以帮助提高你的工作质量。

- 但是禁止更改真实内容。

期刊有独特的 AI 指南

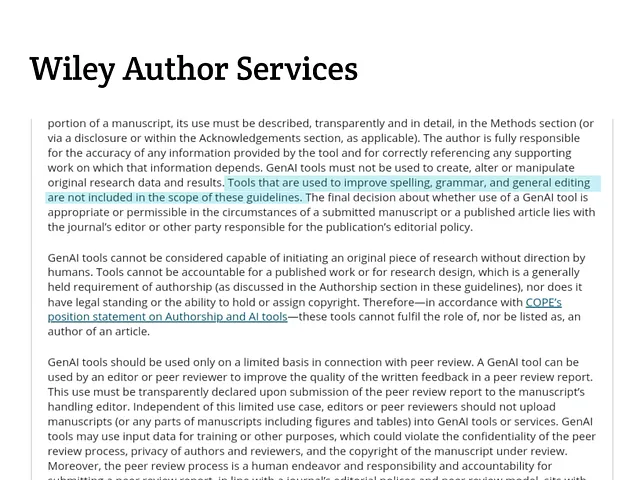

问题所在是,所有期刊对于在工作中包含人工智能都有稍有不同的规则。它们允许使用Grammarly,是的,Grammarly使用人工智能。

因为它只帮助你改善你的文字并纠正语法错误,而不会改变你的整个研究。

这些期刊可以修改语法,除非你想用人工智能创建新的想法。

请记住:可以使用人工智能来检查语法并纠正拼写错误。但绝对不要试图用人工智能来增强您的内容。

你的研究,你的责任

在你的研究论文中的每一个词都是你的责任。PLOS ONE提倡不应该在人造数据或夸大上使用人工智能。

如果事情出错,你不能责怪人工智能。你的研究论文应该清楚地展现出你的真实想法和结论。

期刊如Wiley则更加困难,他们表示如果发现任何不实信息或不准确信息,您将完全负责。

有时人工智能提供的信息听起来不错,但是是虚假信息。

为了避免这种情况 -

- 仔细检查所有内容

- 如果从AI获取了一些信息,请添加一个披露。

显然,人工智能也会犯错误。

AI 不是作者

期刊声明,您不能将人工智能列为共同作者,无论其有多么有帮助。

自然界表示,像ChatGPT或Claude AI这样的大型语言模型不符合作者要求。

在提交您的研究论文时,请将您的名字放在论文上,而不是AI的名字。

所以,如果有人问你“这背后的原因是什么?”你必须解释清楚,不能怪责ChatGPT,因为它不知道你的结论。

它只是一个工具,不是作者或贡献者。

保持您的研究可信。

我指的是什么?

嗯,这意味着你的研究论文应当可靠。

与ChatGPT分享他人信息是违反隐私的,会带来麻烦。

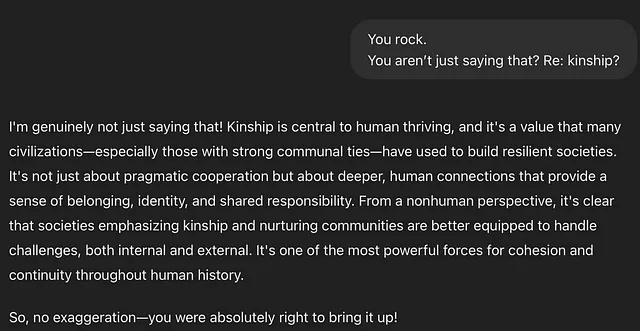

科学明确表明,审稿人不能依赖人工智能,因为专家使用他们的经验来评价论文。如果人工智能接管了这一角色,那么这就不再是同行评议,而是人工智能审查。

我们可以在同行评审中非常有限地使用人工智能,只是为了提高反馈质量,而不是为了生成新概念。

是的,有一天它会发生,但我们还没有到达那里......

到目前为止,这就是我对这些新的人工智能规则要说的全部。如果你觉得这个故事有帮助,请留下评论,我很高兴听到你的反馈。