使用以下5种出色的提示策略来最大化LLM的表现

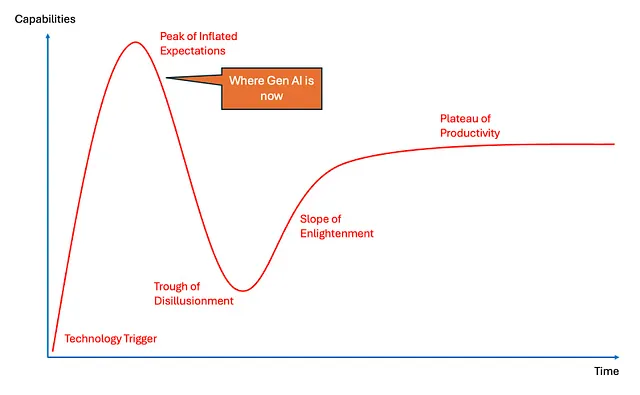

大型语言模型(LLMs)如ChatGPT、克劳德或GPT-4已经彻底改变了我们与人工智能的互动方式。然而,要想从这些模型中获得最佳结果仍然需要一定的技巧。通常情况下,我们使用简单直接的提示,但创新的提示技巧可以打开全新的性能水平。

在这篇文章中,我将探索五种出类拔萃的高水平促进策略,这些策略受最近研究的启发,可以帮助您优化LLM互动。让我们深入了解这些高级技术,以增强您的AI驱动工作流程中的创造力、准确性和效率。

1. 多人角色扮演提示

一个创新的方法是多人设定角色,其中模型被要求在一个任务中扮演几种不同的角色。最近的研究表明,LLM可以有效地平衡多个“人格”或观点,从而提高回答的丰富性。通过参与多个人设定,您模拟了一个协作的头脑风暴会话,通常可以产生更高质量的产出。

这个提示迫使LLM从每个“人物”中产生不同的见解,鼓励更深入的分析和更全面的答案。

2. 思维链 (CoT) 推理

LLM在被鼓励“逐步思考”时往往效果更好。思维链(CoT)提示涉及要求模型将其推理分解为一系列较小步骤。这种结构化思维方法已被证明可以增强准确性和推理能力,特别是涉及逻辑、数学或需要精确思考的任务。

Example Prompt: “逐步解释气候变化如何影响农业,并为发展中国家的小农户提出可能的解决方案。”

当LLM被鼓励详细阐述其推理时,他们通常能提供更准确和可操作的见解。

3. 动态内容扩展

上下文对LLM性能有很大影响。虽然我们通常为模型提供有限数量的输入,但动态扩展上下文可以显著提升结果。这意味着创建类似“记忆”的提示,引用过去的互动或任务,鼓励模型保持连续性并发展更深入的见解。

建立在我们之前关于可持续农业技术的对话基础上,建议AI可以在优化作物产量方面发挥更多作用的方式。

这种策略让模型感觉自己处于持续对话中,并通过回顾过去的互动来鼓励更复杂的回答。

4. 对比提示

对比学习是人工智能中的一个概念,模型通过观察对比例子学习得更好。您可以通过要求LLMs以两种对立观点回答问题来模仿这种技术。这不仅鼓励更丰富的答案,还有助于您确定特定问题的利弊。

在刑事司法中使用人工智能的赞成观点和反对观点。然后提出一个平衡的中间立场。

这种策略可以让模型考虑两个极端,并在这个过程中产生一个更加平衡和细致的解决方案。

5. 情境叙事锚定

LLMs 在叙述中蓬勃发展,通过将复杂提示锚定在一个故事或假设情景中,您可以帮助模型生成更具相关性和可理解性的响应。这种技术称为“上下文叙述锚定”,涉及将一个任务嵌入到虚构但现实的情境中,以促进参与度和创造力。

想象一下您是一名AI顾问,受雇于一家想要利用LLM创建个性化健康建议的创业公司。您会采取什么咨询策略,预计会遇到哪些挑战?

通过将提示嵌入叙述中,您鼓励L语言模型生成更实用和类人的答案,反映现实世界的情景。

最后想法

随着LLMs的不断发展,我们的提示技术也应同步更新。这五种高级策略——多人物角色扮演、思维链推理、动态语境扩展、对比提示和语境叙事锚定——是解锁这些模型潜力的强大工具。

无论您是使用LLMs来创建内容,生成见解,还是协助完成复杂任务,应用这些策略可以帮助您将人工智能交互推向一个新水平。尝试、调整和创新您的提示——您会惊讶于深思熟虑的提示所带来的差异。

愉快提示!

对于付费的人工智能/法律主义咨询服务,请发送电子邮件至:profmazenelnahal@gmail.com