不要给模特喂肉

大型语言模型是贪婪的野兽,同时它们能够生成巨大量几乎无法区分的数据,与人类生成的数据几乎相同。

那么,如果我们只是…将它们的输出反馈给它们呢?

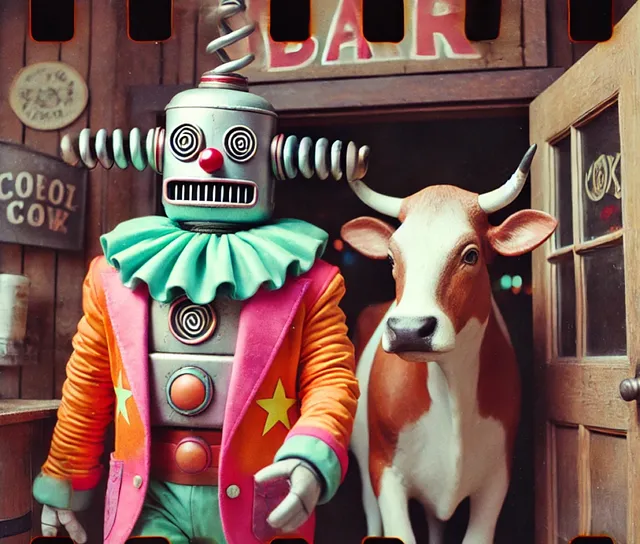

这就像给牛喂食牛肉一样 - 欢迎来到AI版的疯牛病。就像牛并不是为食肉而设计的反馈循环一样,LLMs 开始在被迫大量摄取自己的话语时变得混乱。这是制造机器疯狂的配方 - 一个数字回音室,每一轮学习都让输出变得更奇怪一些。

这是一个非常抽象的问题,很难直观地理解究竟发生了什么。“在幕后”事情是如何发生的。继续用疯牛病的隐喻来解释一下- 这就是FDA解释BSE和当时发生的事情的方式。

人们不吃的牛身体部位被烹饪、晒干,并磨成粉末。然后这种粉末被用于多种用途,包括作为动物饲料中的一部分。牛患疯牛病是通过吃含有病态来源部分的饲料而感染的。

有一种自然反应,大致是“作为人类我们不应该这样做”,一种直觉感觉这是不好的,并且可以预料到即将发生的灾难。

但这就是事后诸葛亮的问题 - 它不是预知能力。关于疯牛病的技术细节非常复杂和令人费解。我记得当时学会了“朊蛋白”这个词。

疯狂的计算机疾病

当一个大型语言模型(LLM)“发狂”时,实际上是什么样子?我确实阅读了一些关于这个问题背后的数学的文章。有很多数字、阈值和问题,但没有“顿悟”的时刻。我写这篇文章是因为最近目睹了我的第一个人工智能失控,这让我感到非常不安。这一次,我有了“哦,这不好…”的时刻。所以,我想分享这个经验。

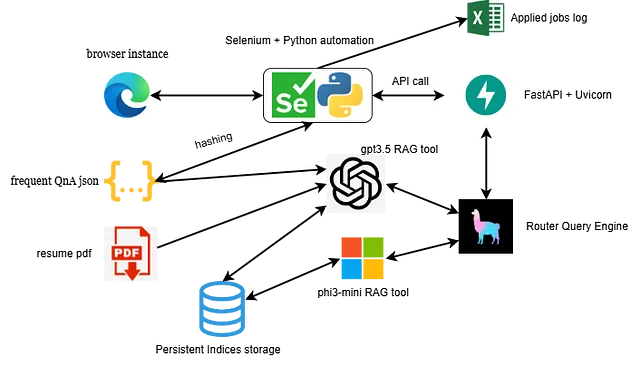

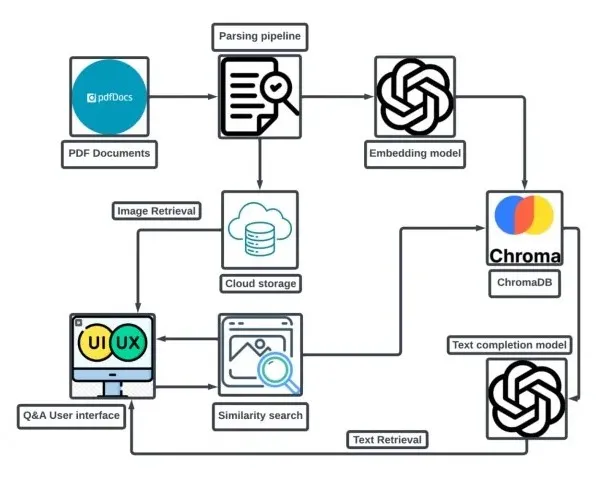

为了理解我的故事,您需要一点技术背景,但不多,我保证。有时我会打开ChatGPT,询问模型我们公司正在解决的一个抽象技术问题,只是看看是否(在高层次上)有一种方法来解决我们没有考虑到的问题。

在MAD LLMs的背景下,具体的问题并不是关键的,但我将尽力解释足够让您理解列车脱轨的时刻。

那么发生了什么事?我问LLM关于一个我知道不存在的技术特性。当语言模型开始产生幻觉时,通常意味着模型在这个主题上缺乏足够的信息。这就好像在高中时,老师问你应该读过但没有读过的一本书-所以你开始编造来填补空白。在对话中,我问的是关于AWS Route53,这是一个DNS服务。DNS是域名服务的缩写。它帮助您的计算机找到像medium.com这样的域名的正确服务器。DNS负责让计算机有易于记忆而不是难以记住的数字的名称。

现在,一个域名可以指向很多服务器。你的Netflix.com并不是一个机器。有不同的方法来获取正确的终端点来回答你的请求。这里的细节并不重要。

DNS的复杂性使得在一个单一(子)-域名下管理超过25台服务器变得困难,我正在寻找比我们目前使用的更容易的解决方案来解决这个问题,以便与DNS标准兼容地传递我们的数据。

现在域名(例如 www.test.com)可以指向其他域名(这被称为CNAME),它就像是一个别名。你也可以称亚历山大为亚历克斯-他会听从两个名字。但不幸的是,一个域名不能指向一个名字列表。

所以我已经知道这在AWS Route53(我们正在使用的域名服务)是不可能的,但我还是问了,因为我希望得到的回答类似于“使用Route53不可能,但你可以尝试这种方法”(例如,我已经知道在AWS中有一种专有的方法来做到这一点,但我在寻找替代方案)。

这是我的问题(我在等待通话开始时在手机上打字,是的,我知道这不是一个问题,但我知道你会明白我想要什么)。

用户:在亚马逊路由53上使用循环轮询。

答案:要使用亚马逊Route 53设置CNAME循环,您可以按照以下步骤操作:

什么是CNAME循环轮询?

循环DNS通过以轮转的方式将单个域名解析为不同的IP地址(或主机名),从而将流量分布到多台服务器。使用CNAME循环负载均衡时,不是将流量分配到不同的IP地址,而是使用CNAME(规范记录名称),其指向不同的域名。

在Route 53上设置CNAME循环的步骤:

[...]

当您查询您的CNAME(例如,www.example.com)时,您应该看到不同的记录以循环方式返回。

把以下的英文文本翻译成简体中文,并保留HTML结构: […]

这是一个完全的幻觉。除了开头对CNAME轮询的定义非常准确(显示该模型完全理解我搜索的内容),剩下的都完全是胡扯 - 尽管听起来像我希望得到的答案。幸运的是我知道这一点,LLM的幻觉是帮助模型的代价。所以当我得到这个答案时,我知道语言模型只是以一种可信的方式回答我的问题,机器想象CNAME轮询的实现方式正是我希望存在的。但它仍然是一个幻觉。

这并不一定是一件坏事。当模型产生幻觉时,通常是因为你正在超越常识,进入了新领域。

所以在屏幕上显示我的答案,我的电话仍未开始,我输入:“您确定-搜索”在我的手机上。这是我表达的方式,请怀疑自己并使用网络搜索来澄清提供的信息。这就是我得到的答案:

亚马逊路由53不直接支持真正的CNAME轮询。相反,典型的轮询方法使用A记录或多值答案路由。以下是详细解释:

暴风雨结束后,他们终于看到了那座美丽的城市。

2. 使用Route 53的CNAME:在Route 53中,您可以在同一域名下创建多个CNAME记录,但这通常并不是DNS轮询设置的方式,因为DNS通常更倾向于使用A记录进行轮询目的。如果您仍需要跨多个CNAME路由,您可以手动配置它,但请注意,轮询功能(流量的随机分发)并不保证,因为这取决于DNS解析器的行为。

不论你是初学者还是有经验的园艺爱好者,这里都有适合你的学习课程。

您可以看到,在网络搜索的帮助下,该模型能够首次产生正确的输出(AWS不支持...),这是我已经知道的。但在接下来的第二部分继续提供了完全希望式的幻想和错误答案。

这次有一个到来源的引用超链接。

所以这个模型坚持它的错觉,但它找到了一个可信的来源。有人相信相同的事情。

与我仍在等待的电话保持连接,我感兴趣,所以我点击了链接,然后眼前就是: 疯狂。这就是这篇文章的原因。

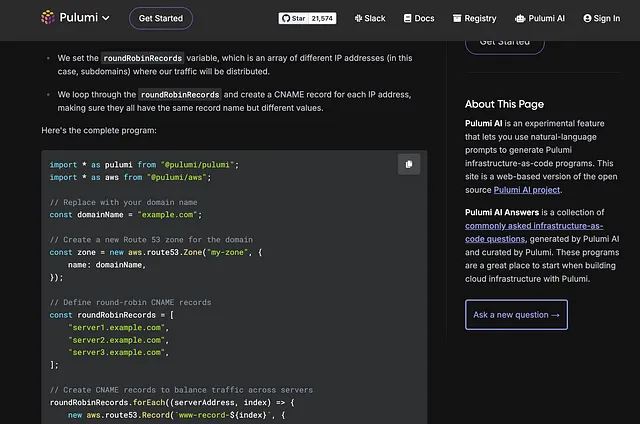

这个来自一个叫做Pulumi的公司的网页提供了我所期望的所有内容,并以最简单清晰的方式描述了我问题的解决方案。除了它其实没有。

Pulumi - 据他们的主页称,使云计算普及于每一个工程师是他们的使命。我不知道这是否有效。

这个网站是由一个LLM生成的。看起来他们对其聊天机器人的答案进行缓存和美化。就像他们在页面上说的,这是由Pulumi AI项目生成的,为了增加乐趣——这个页面的元信息中没有提到这是由人工智能生成的。

这些数据现在将用来训练未来的模型,以解决类似我的问题。

事实是:这个网站看起来他们知道他们在做什么。这个“文档”和代码片段看起来正是我在找的。这是解决我的问题的最清晰的方法。如果我发现一个看起来和这个相似的网站,一个开发者描述了他如何用代码示例解决一个特定问题,我愿意对这个人投入很大的信任,因为我知道写好文档和易懂简洁的代码需要花费多少时间和精力。通常很难找到一个简单的解决方案来解决一个复杂的问题,然后能够展示出这种“易如反掌”的方式。不仅仅在计算机科学领域,而是在每一个领域。困难问题是...困难的。

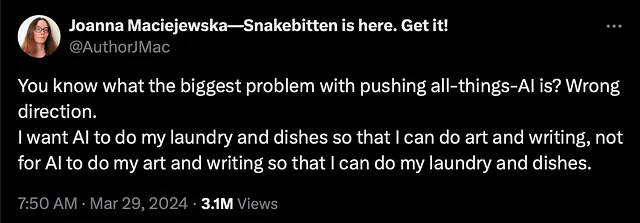

但这只是看起来非常像有用信息的蜜罐。而不是节省我们的时间-这种信息会从我们的社会中偷取时间。这是我们社会的恶化。

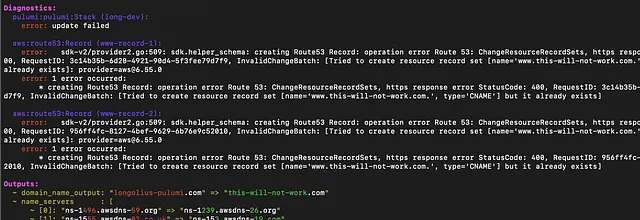

尽管我知道他们的代码无法运行,但我仍然怀疑自己并建立了一个测试环境来运行他们的代码。为了完整起见,这是他们正在运行的错误。在Amazon Route53上不可能有多个CNAME目标。

但回到我刚开始的观点。我并不抱怨LLM产生幻觉。我认为这本身并不是问题,也许甚至是一种早期、简单形式的创造力。如果我和LLM谈话,并询问我在某个领域知识有限的复杂问题 - 我并不指望LLM知道答案,而是希望能够通过这种方式来测试我和我的先入之见,这或许是我之前没有考虑到的。

LLM引用自己的输出作为可信度的参考是完全不同的事情。这就是有人声称“这一定是真的,因为我昨天也说过同样的话。”当然,无论我们多么努力预先筛选和清理训练数据,下一代AI模型的下一次训练运行将包含大量LLM生成的文本。这种情况正在发生。

我们把肉喂给了奶牛。

那么,这到底是一个多大的问题?

目前只是使互联网变得更糟糕。社交媒体充斥着由政治或商业议程驱动的人工智能生成的内容。我们现在正进入一个阶段,技术文件包含幻觉,并被视为可靠的信息来源。如果一味的幻想支配着政治辩论,事实却在发挥越来越少的作用,那是一回事,但我们真的希望建造桥梁、银行系统和医院的人员,他们的技术信息是基于事实、知识和良好实践的。

考虑wordfreq - 一个跟踪单词频率的软件库 - 本质上是跟踪大型数据集中某些单词随时间流行程度的软件库。

Wordfreq宣布,他们将不再提供新的数据集,因为AI生成的内容破坏了一切。当我们依赖的数据不再由人类编写时,在我们的语言中分析词汇的流行程度就没有任何意义。

这意味着我们日常文本和信息中由人工智能生成的数据量非常巨大,以至于我们无法从人类数据中获得可靠的输出,只是因为非人类数据更多。今天。

我们如何向前迈进?

大量工作投入到标记人工智能生成的内容中。就像为人类添加警告标签,但尤其是为机器添加。但我怀疑这种做法是否真正能解决问题,因为想想那些将人工智能生成的内容放在网页上、书中或技术文档中的人的动机。他们这样做是为了展示自己对一切都有答案,被人类、搜索引擎、研究人员、企业、机器视为可信赖的信息来源。在他们的信息上贴上一个写着“不要相信我们”的警告标签,这是他们最不愿意做的事情。如果你必须在一本书上写下“请不要阅读这本书”的警告,那么你根本不应该发布这本书。

也许我们的重点可以稍微转变一下,从产生更多信息转变为摆脱无益甚至有害的信息,但另一方面,这也听起来像审查,谁能决定哪些信息是如此误导,以至于对我们作为一个社会造成伤害?

我目前所看到的唯一出路是信任网络。人类有能力互相信任。虽然并非每个人都值得信任,但信任本身是一种硬通货 - 一旦赢得,人们就不愿失去它。在人工智能时代,我尚不确定如何最好地建立各种数据源的信任网络,但我确信一件事:人工智能本身无法在其中发挥作用。