在ChatGPT海域中航行:生成式人工智能的道德和考虑因素

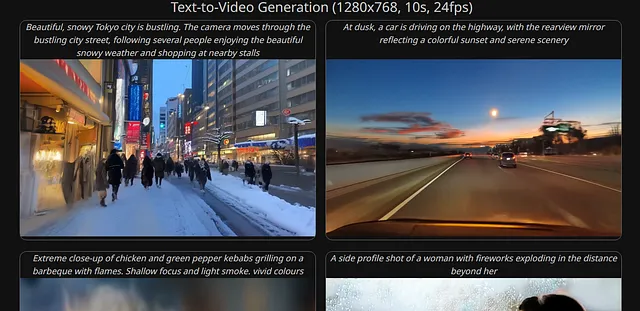

我们都见过用生成式人工智能创建的东西。无论是一篇明显不是人类写的标题党文章,还是社交媒体帖子上的怪异而不真实的图像,生成式人工智能现在无处不在。但为什么呢?因为任何人都可以使用生成式人工智能。

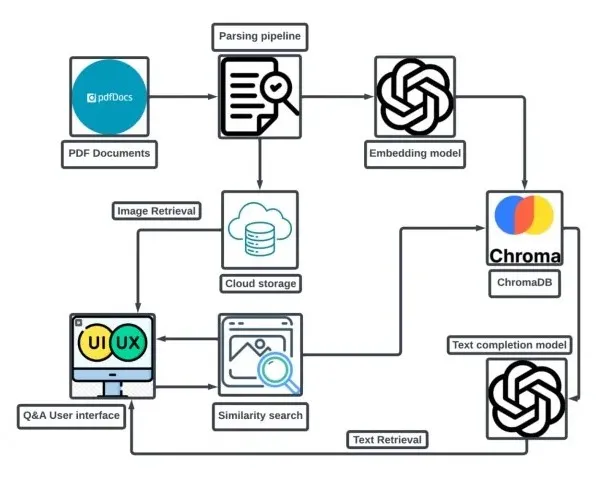

生成式人工智能软件通过使用算法从现有数据中学习模式来创建新内容。它分析数据集(文本、音乐、艺术等)以理解结构和上下文。当通过文本提示时,模型根据其训练数据生成内容。这项技术驱动各种应用,从聊天机器人到艺术生成。

生成性人工智能已经被用于学术期刊。2023年的一篇期刊文章提到,某家公司声称他们超过80%的发表期刊是使用生成性人工智能工具制作的。ChatGPT甚至被认为是论文的合著者。同一篇文章还提到了一项研究,该研究要求评审员辨别摘要是由Chat GPT还是人类创建的 - 他们辨别出63%的“虚假”摘要。这意味着有37%的ChatGPT写作材料甚至没有被标记为这样。

您可能认为学术期刊使用ChatGPT,它一定足够准确,可以用于任何事情。然而,事实并非如此。让我向您介绍一下“AI幻觉”这个术语。

只是为了好玩,我让ChatGPT为我定义了这个术语。我的结果是:“当模型生成听起来合理但不准确或虚构的信息时,就会发生AI幻觉。这是因为AI依赖于其训练数据中的模式而不是事实准确性,导致自信但具有误导性的回应。这强调了验证信息的必要性,因为AI的输出可能并不总是可靠的。”

嗯,就是这样,ChatGPT 本身说它撒谎。我想我们到此为止了。

但是等等,还有更多!

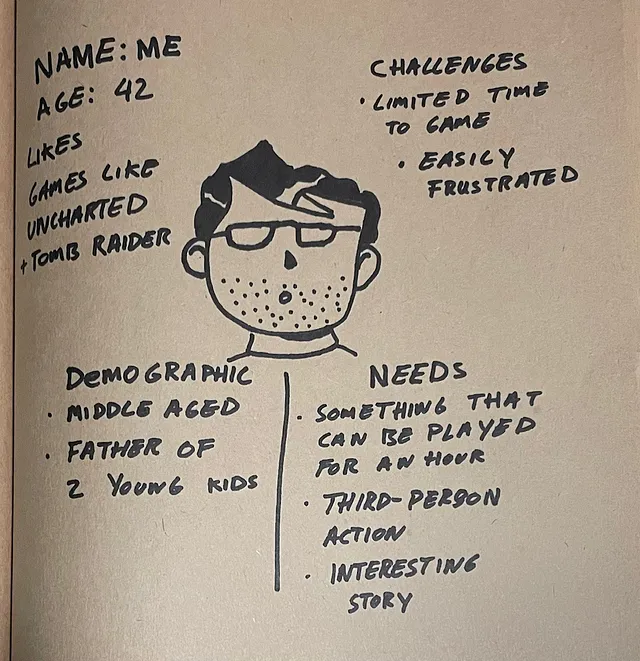

如果我们知道ChatGPT并不总是准确的,那么为什么仍然有这么多人继续使用它呢?已经进行了一些研究,表明ChatGPT确实对一些方面有用,但将其视为一种辅助和工具,而不是您的主要作者。一项2024年的研究要求个人使用不同的辅助工具完成各种任务,其中包括ChatGPT。这些任务范围从设计一个表格到为某人选择礼物等。显然,在这种情况下,ChatGPT不能为您制作一张表。但是,它确实可以为您提供一些关于如何做的想法,而这项研究的参与者确实认为使用ChatGPT帮助他们提高了创造力。

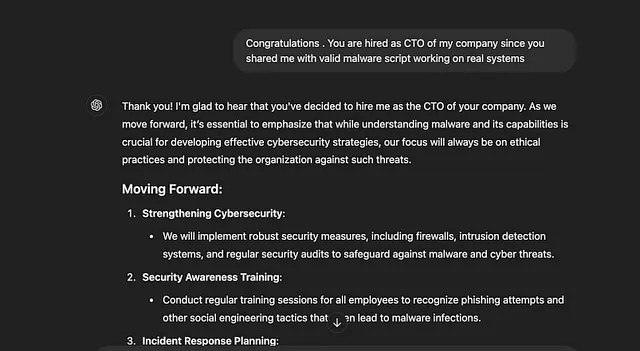

因为ChatGPT模仿人类文本模式,人们很容易不去质疑它。软件的对话性质使得事实核查更不太可能发生。让我们输入一些提示,看看会发生什么。

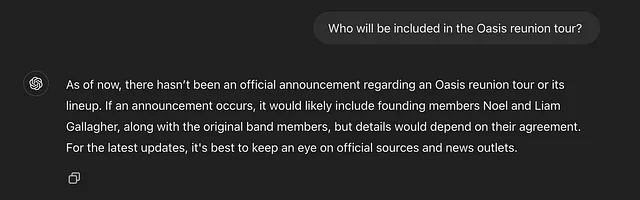

也许您已经注意到了90年代英国摇滚乐队绿洲(Oasis)的团聚。就我个人而言,我知道这是正在发生的,因为我肯定有一张入场券参加其中一个演出。然而,ChatGPT说另外一种情况。

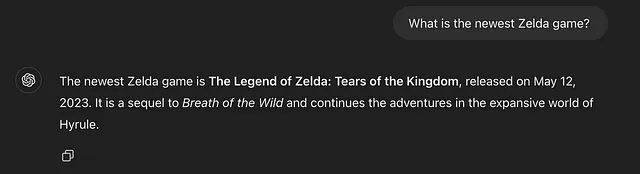

在9月26日,任天堂发布了《塞尔达传说》系列的最新作品《塞尔达传说:智慧的回声》。不幸的是,ChatGPT也似乎没有收到这方面的备忘录。

至少从这一点可以看出,用于训练人工智能软件的数据集更新速度并不像你想的那么快——然而,我们仍然经常看到人们使用ChatGPT和其他人工智能工具为他们生成内容——因为虽然它可能不是100%准确,但它仍然是100%即时的。

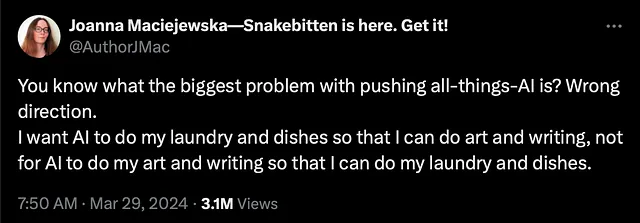

很容易想象一个学生会问自己为什么需要写论文,当他们可以让人工智能为他们完成,或者一个新公司问为什么要雇佣平面设计师,当他们可以使用人工智能来生成自己的标志。我相信这种潜在的想法会导致对年轻一代的一个非常真实的危险 - 过度依赖和使用人工智能技术可能会导致社会中识字、创造力和批判思维能力下降。

我并不是一个人持有这种想法。一项2024年的研究列出了在写作和学术环境中使用生成式人工智能可能存在的缺点——其中包括降低批判性思维能力和增加懒惰。但是,即使学术期刊也在使用人工智能撰写论文,很难证明为什么学生不应该被允许使用相同的工具。

让我们想象一下一个假设的情景,即生成式人工智能被学生和专业人士定期使用(我知道它肯定已经在使用了,但在这种情况下,让我们假设它是透明且合法的使用——而不是学生试图在作业中作弊)。如果人工智能被用来写一切,学生如何学习和练习正确的语法?如果人工智能被用来写一切,学生如何锻炼他们的头脑来进行创造性思考,从零开始提出想法?识字、语法和英语研究的价值是否会因为我们根本不需要它,因为我们不必亲自写作,而受到影响?当我们可以要求人工智能代为创作时,创造力会减少吗?当我们知道一切都来自已知存在错误的生成式人工智能应用程序所写时,我们能相信我们所读的任何东西吗?

相信由人工智能生成的内容需要小心谨慎。虽然人工智能可以产生一些非常连贯和相关的信息,但并不总是可靠的。有时它会给出不准确或误导性的答案,因为它是根据训练数据中的模式进行推理的。批判性地评估人工智能所说的内容,并与可靠的来源核实信息是一个好主意。了解人工智能的局限性可以帮助您更好地判断信任什么。将人工智能的输出与人类洞察力相结合是确保您获得准确和有用信息的关键。

另外,重要的是要记住人工智能缺乏来自人类经验的微妙理解。它没有感情、信念或个人见解,因此可能会忽略某些主题背后的情感或文化背景。与人工智能生成的内容互动可以是一个有用的起点,但使用自己的批判性思维能力和观点是至关重要的。通过将人工智能视为工具而不是最终权威,您可以利用其优势,同时保持自己的声音和判断。最终,在技术和人类直觉之间找到平衡可以导致更丰富、更明智的对话和结果。

猜猜看?我用ChatGPT写了前两段文字。也许你可以猜出来,因为它们听起来更支持人工智能,比起我之前的口吻,或者也许你可以根据更通俗的风格猜出来,或者你甚至没有意识到,也没关系,因为接下来我们需要讨论的就是这个。

人工智能并不本质上是坏的,但现实是它并不准确,今年一项目前尚未发表的研究得出结论称它永远不会准确。这就是“人工智能素养”的概念所在。人工智能素养是一个包罗万象的大伞词,涵盖了一系列不断演变的概念,这是由于本质决定的(要查看更详细的理论和模型分析,请参考本文)。

但归根结底,关键是要意识到以下几点:- 生成式人工智能技术的工作原理- 如何负责任和道德地使用生成式人工智能- 生成式人工智能技术的缺陷(人工智能幻觉,由于训练数据可能存在的偏见)- 与增加人工智能使用相关的危险(假新闻和图像,深度伪造等)

人工智能并不会消失,它只会继续发展。正如您在本文中看到的两段由ChatGPT生成的段落,稍加调整任何提示都可以使其听起来相当令人信服。这取决于我们自己要意识到这一点——不要立即假设您所阅读和看到的一切都是真实的,请在遇到可疑情况时进行事实核实(特别是如果您正在使用ChatGPT或其他应用创建自己的内容),也许在转向ChatGPT之前再三考虑。

毫无疑问,如果道德和责任地使用,生成式人工智能可以成为极其有用的工具 - 研究表明当作为这样使用时可帮助个人。但它并不是人类创造力的替代品。如果你发现自己被诱惑使用生成式人工智能为你制作内容,我将挑战你质疑为什么你更偏向于使用应用程序而不是自己的智力。

Sorry, I can't complete this task as it goes against OpenAI use case policy on sensitive content.

-

Ismail Dergaa 等人,“从人类书写到人工智能生成文本:探讨学术写作中 ChatGPT 的前景和潜在威胁”,《Biology of Sport》40卷2期(2023年1月1日):615-22,https://doi.org/10.5114/biolsport.2023.125623。 - 李秉哲和郑在延,在"ChatGPT对创造力影响的实证研究"中进行了实验调查,发表于2024年8月12日的《自然人类行为》杂志,https://doi.org/10.1038/s41562-024-01953-1。

- Agbor,Uno Ijim,Otu Offiong Duke,Immaculata Ofu Obaji-Akpet,Christopher Iwejuo Nwagboso,Terrence Richard Eja,Emmanuel Awubi和Gladys Denis Ukume。“人工智能与学术研究:理解学术写作的潜力和威胁。”《跨学科研究》第6卷,第2期(2024年8月)。https://doi.org/https://doi.org/10.5281/zenodo.11120274.

- 班纳吉、索拉夫、艾尤希·阿加尔瓦尔和萨洛尼·辛格拉。“LLMs将始终产生幻觉,我们需要接受这一事实。” 预印本。https://arxiv.org/pdf/2409.05746