AI的大问题:更大并不总是更好

让克洛德AI像Z世代一样写我的视频脚本 😂

今天我们要探讨的是最近让我很在意的事情:人工智能以及为什么更大的模型并不总是我们认为的好表现。

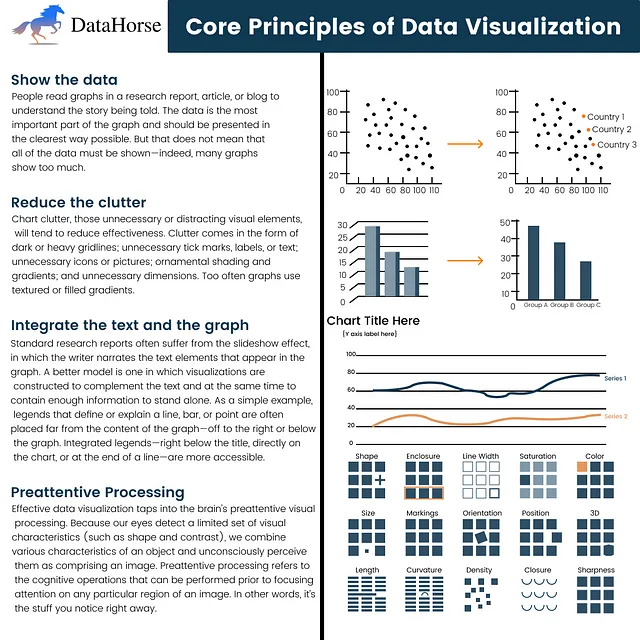

炒作与现实

你知道每年我们都会得到一部新的智能手机,带有更多的摄像头,更多的像素,更多的一切吗?嗯,AI也在经历类似的旅程。公司不断推出这些巨大的语言模型,每一个都比上一个更大。但这里有个转折:就像更多的摄像头并不总是意味着更好的照片一样,更大的AI并不总是意味着更智能的AI。

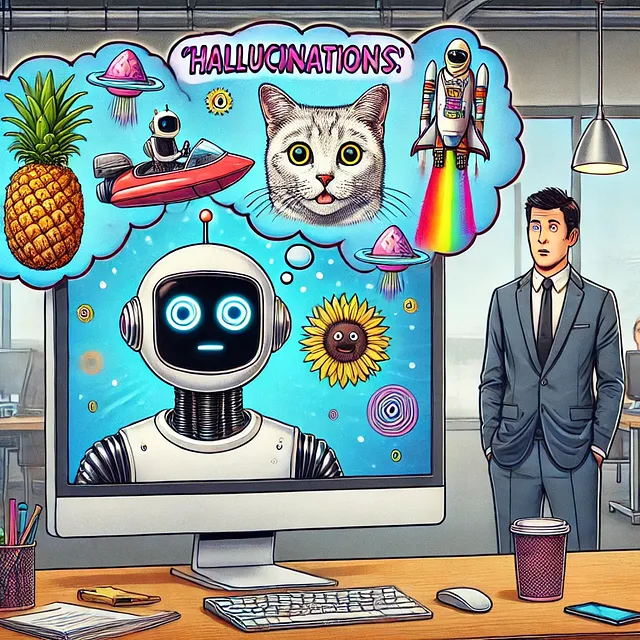

自信心的难题

所以这就是交易:

• 研究人员发现,人工智能模型越大,产生错误信息的可能性就越大• 他们称之为“ultra-crepidarian” - 基本上,人工智能不知道自己不知道什么• 这就像那个朋友,无论什么事情都超级自信,即使他们错了。

我一直在玩这些模型,让我告诉你,它非常疯狂。你问一个简单的问题,然后突然就得到这个非常流畅、可信的答案。但当你事实核实时呢?哎呦。

困难的断开

现在,这就是有趣的地方:

• 大型人工智能模型在处理复杂任务方面表现出色 • 但在简单事物上却笨手笨脚 • 就像拥有一个可以编辑8K视频但却难以发送短信的智能手机

以梅塔的羊驼模型为例。在处理棘手问题时,这些东西是野兽。但问题是,它们经常回答错误。这不是在逃避困难的事情;只是自信地给出错误信息。

为什么这很重要

想想看:如果我们开始将这些人工智能用于像医疗保健或法律咨询这样重要的领域,会怎么样?这种过度自信可能会导致一些严重的问题。

那么,问题的解决方法是什么呢?

好吧,那些聪明的人正在做些什么?

1. 提示工程:关键在于问对问题。用词稍作改变可能会产生巨大影响。

2. 质量胜过数量:一些公司开始专注于更好的数据而不只是更多的数据。Meta的新Llama模型? fewer参数,更好的结果。

3. 寻找甜蜜点:研究人员试图平衡人工智能处理困难问题的意愿与承认自己不确定的能力。

重要的问题

现在,我想让你想一想:

• 谁能破解代码并制作出既聪明又自知的人工智能?• 我们何时能够信任这些模型以供日常使用?• 人工智能变得过于复杂而不可靠存在吗?

总结

看,人工智能令人难以置信,而且进展神速。但就像任何技术一样,我们需要在使用它方面睿智。不要仅仅被庞大的数据和华丽的演示所震撼。要进行批判性思考,提出问题,并始终核实事实。

今天就到这里,科技团队。如果你觉得这很有趣,请点击"赞"按钮,并别忘了订阅更多科技见解。和平!✌️