构建您自己的ChatGPT

这篇博客提供了一个关于在您的系统上安装大型语言模型(LLM)并创建一个类似于ChatGPT的私人聊天机器人的逐步指南。在本指南中,您将学习如何在本地机器(Windows)上安装Meta的LLaMA模型。

注意:您的系统必须具备至少16GB的RAM以获得最佳性能。

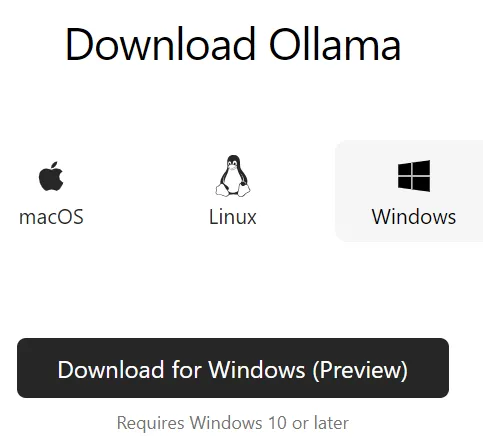

步骤1:访问Ollama网站并点击Windows图标。Ollama可执行文件将下载到您的系统中。

在系统上双击安装可执行文件。

请访问https://ollama.com/download。

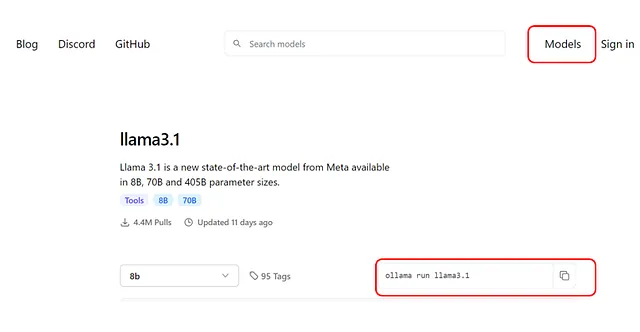

第2步:在Ollama网站上,点击页面右上角的“Models”选项。这将显示各种可用的模型。对于这篇博客,我将安装LLaMA 3.1 (8B)模型。

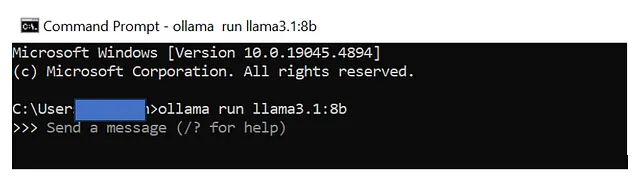

要安装它,请复制命令"ollama run llama3.1",打开您的CMD或PowerShell,并运行该命令。

这将启动下载大小约为4.7GB的LLaMA 3.1模型。

如果您喜欢较小的型号并且希望获得更好的系统性能,您可以考虑使用 LLAMA 3.2,该型号提供从1GB到2GB的型号。

您本地版本的LLaMA 3.1现在已经准备就绪。接下来,我将指导您如何集成类似ChatGPT的用户界面。

第三步:集成Open WebUI界面

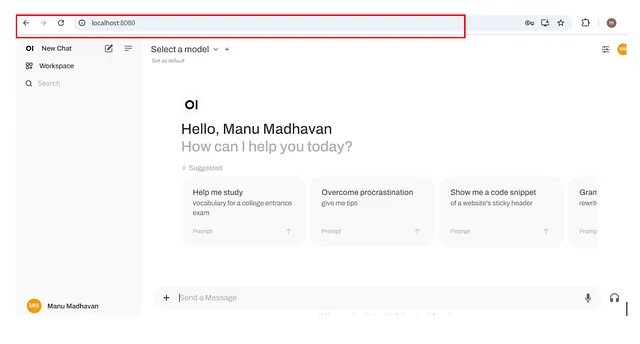

打开WebUI允许您在类似ChatGPT的界面中与下载的模型进行交互。

我将介绍两种方法来启用用户界面

3.1 方法一- 通过Python pip 安装。

确保您的系统中已安装Python 3.11或更高版本。如果没有安装Python,请先安装Python。安装Python后,请按照以下步骤操作:

打开您的终端(如CMD)。

运行以下命令:"pip install open-webui"

安装完成后,您可以通过在终端中执行以下命令来启动WebUI:open-webui serve

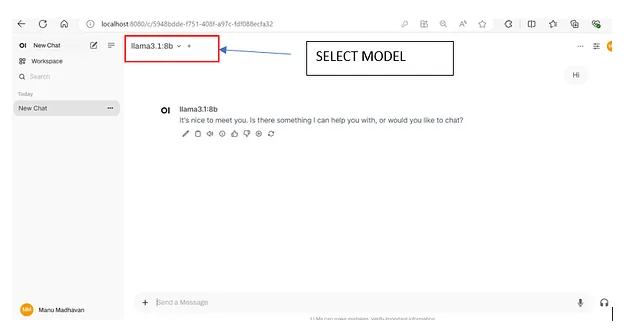

这将启动Open WebUI服务器,可以通过http://localhost:8080访问。

要在UI中使用模型,请确保在终端(CMD)中执行以下命令并将模型映射到界面。

奥拉马奔跑

在UI中选择模型

开始与您的私人GPT互动 :-)

3.2 方法 2:使用Docker快速启动

如果您不想在系统上安装Python,您可以快速开始使用Docker。按照以下步骤:

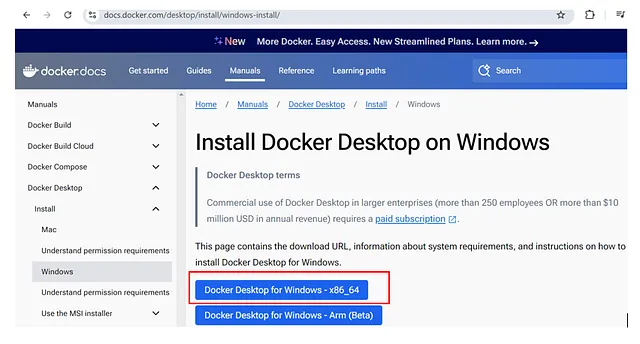

3.2.1 下载Docker安装程序访问官方Docker网站并下载Docker安装程序。运行可执行文件,按“下一步”提示操作,然后在您的系统上安装Docker。

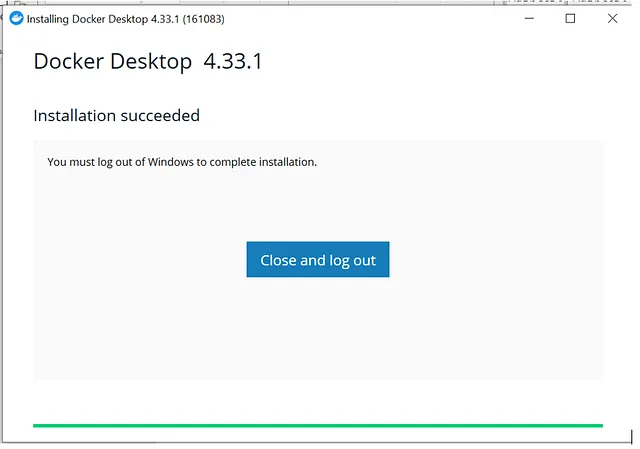

运行可执行文件,然后点击“下一步”。安装完成后,您将会看到以下信息。

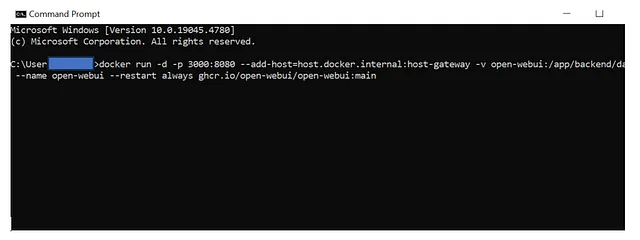

第3.2.2步安装Open WebUI

在CMD提示符下运行以下命令,您可以从Open webUI官方网站上获得。

“docker run -d -p 3000:8080 — add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data — name open-webui — restart always ghcr.io/open-webui/open-webui:main” “docker run -d -p 3000:8080 --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:main”

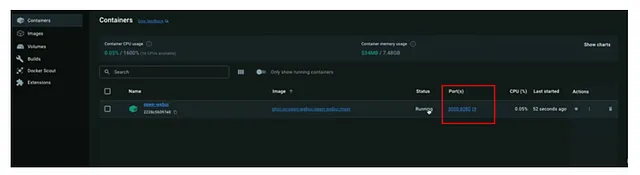

完成Openweb UI安装后,转到您的docker应用程序并单击本地主机链接,它将打开交互式UI。

感谢阅读。

参考:

https://openwebui.com/

https://github.com/open-webui/open-webui 翻译为简体中文: https://github.com/open-webui/open-webui