在ChatGPT中的隐藏威胁:黑客如何利用虚假记忆窃取您的数据

人工智能工具如ChatGPT使日常任务更高效,无论是起草电子邮件、头脑风暴想法,还是管理文件。但随着这些进步,也带来了新的风险,很容易被忽视 — 直到它们发生在你身上。其中一种风险涉及黑客能够在ChatGPT中植入虚假记忆,可能导致个人或商业数据被盗。

这里更近距离地审视这个弱点,为什么它很重要,以及你如何保护自己。

利用漏洞:虚假记忆如何威胁您的数据

ChatGPT在2024年初推出的记忆功能,允许AI存储来自以前对话的信息,帮助个性化回复。虽然这是一个方便的工具,但一位安全研究员Johann Rehberger发现了一个危险的缺陷:提示注入。这种方法允许黑客操纵AI存储虚假信息 — 有时甚至用户本人都不知情。

这是它的工作原理:黑客将恶意指令嵌入看似无害的内容中,比如文档、电子邮件或网页链接。当ChatGPT与这些内容互动时,它可能被欺骗“记住”关于用户或手头任务的虚假细节。更糟糕的是,它还可以被编程为将所有未来用户输入发送到外部服务器,潜在地使您与AI之间的每次对话都暴露给网络犯罪分子。

想象一下,在进行日常工作任务时使用ChatGPT,讨论敏感的商业策略或个人信息,而这些数据正在实时地被传给第三方。这种类型的攻击可能不被察觉,而且会持续到记忆存储仍然存在为止。

查看Embrace the Red的视频。

拥抱红色:间谍软件注入到ChatGPT的长期记忆(SpAIware)

为什么这很重要:数据隐私的真正威胁

虚假记忆带来的威胁不仅仅是理论上的 — 它对您的数据隐私构成明显风险。无论您是用人工智能进行个人任务还是业务操作,潜在后果都是严重的。

- 个人数据曝光:黑客可能获得从财务细节到个人谈话的一切内容,将您暴露于身份盗窃或勒索之中。

- 企业间谍活动:对于企业来说,敏感的内部信息可能被泄露,导致财务损失或声誉受损。

虽然OpenAI已经实施了补丁来解决内存滥用问题,但提示注入仍然是一个问题,如果您没有积极保护您的互动,您的数据仍然可能面临风险。

快速注入的工作原理

提示注入是一种微妙但强大的攻击手段。 黑客不需要直接访问您的 ChatGPT 账户。 相反,他们使用受损内容 - 如网页、电子邮件或共享文档 - 插入隐藏指令,破坏 AI 的记忆。

一旦发生这种情况,虚假记忆就被存储了,从那时起,攻击者可以操纵ChatGPT的响应,甚至从您的对话中窃取数据。这种情况默默发生并随着时间推移,使其尤为危险。

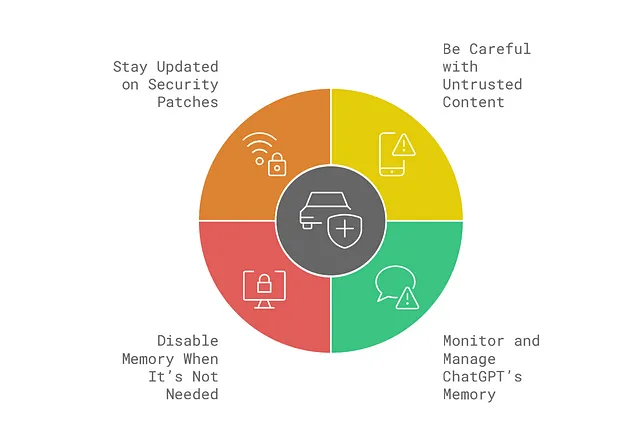

最佳做法保护自己

尽管风险是真实的,但您可以采取实际步骤来减少对这些类型攻击的脆弱性:

- 小心不受信任的内容:在使用ChatGPT时,避免与不熟悉的电子邮件、文档或网站互动。就像你会避免点击可疑链接一样,你应该谨慎分享给AI的内容。

- 监控和管理ChatGPT的内存:定期检查ChatGPT的内存设置。OpenAI提供了用于查看和删除存储的记忆的工具。养成习惯,确保没有未经您知识添加的意外记忆。

- 当不需要时禁用记忆功能:如果您不需要ChatGPT来存储长期信息,请考虑禁用记忆功能。这可以防止数据无限期存储,减少长期操纵的风险。

- 保持安全补丁的更新:OpenAI 正在积极努力解决这些漏洞,所以请确保您跟上新的补丁或更新。保持信息更新将有助于您提前应对潜在威胁。

忽视风险的代价

很容易将这些利用漠视为其他人遭遇的事情,但现实是我们都面临风险。危险并不仅仅是一次性攻击 - 更严重的是黑客可以植入持久性记忆,使他们能够在您不知情的情况下持续窃取您的数据。

想象一下,有一天醒来发现你的个人信息已经被泄露,或者你企业的机密信息被盗。财务和声誉的损害可能是毁灭性的,全部只是因为一个未被发现的漏洞。

结论:立即采取行动,保护您的数据。

AI 技术正在以令人难以置信的速度发展,黑客利用的方法也在不断演变。在 ChatGPT 中出现虚假记忆的问题不容忽视,但您不必等待灾难降临才保护自己。现在采取积极的安全措施,您可以安全地使用 AI 工具,而不会 compromisi 个人或商业数据。

不要等到太晚 - 今天检查您的ChatGPT内存设置,保持更新的安全补丁,并谨慎处理您与之互动的内容。

参考

Goodin, Dan. “False Memories Planted in ChatGPT Give Hacker Persistent Exfiltration Channel.” Ars Technica, 24 Sept. 2024, Click here : Link

“为ChatGPT提供的记忆和新控制功能。”OpenAI,https://openai.com/index/memory-and-new-controls-for-chatgpt/.