为何我们使用ChatGPT会感到内疚(以及如何克服它)

在创意和办公工作中使用人工智能所面临的情感和伦理困境

想象一下:你面临着一个截止日期,但思绪却不能连贯。于是,你转向ChatGPT,这是最著名的人工智能工具之一,也是许多人首选的人工智能聊天机器人,寻求一点帮助。几次点击,然后,咔嚓——就像魔术一样,一份草稿出现了。但在你审阅时,心中总有一种负罪感。你是不是走了捷径?这真的是你的工作吗?

在 Hive,我们一遍又一遍地看到这种情况发生。有时是与我们的员工、我们合作的内容创作者进行对话,或者与云计算行业的合作伙伴进行私下讨论,但结果都是一样的:许多人使用人工智能来加快任务的速度,然后感到难过。我们从这些对话中得到的是,像 ChatGPT 这样的人工智能工具正在变得越来越受欢迎,但它们也带来了情感和道德负担。

所以,为什么我们对使用人工智能感到内疚呢?在这篇文章中,我们将深入探讨这种内疚背后的原因,探讨人工智能在内容创作中的利弊,并提供一些使用这些工具的负责任方法。

为什么使用人工智能会让我们感到内疚?

AI工具周围的愧疚感比你想象的要普遍,这源于几个关键问题。

1. 害怕作弊或走捷径

对许多人来说,利用人工智能来辅助任务感觉就像作弊一样。特别是写作一直被视为一种创造性、智力活动,需要思考、努力和独创性。当人工智能在几秒钟内生成内容时,你可能会感觉自己绕过了这个过程中必不可少的部分。

在Hive,我们的员工已多次表达对此的担忧。很容易怀疑:我是在做工作,还是机器在替我做?

2. 失去创造力和原创性

创造力是个人的。当我们创造时,不论是一封电子邮件还是下一个伟大的美国小说,我们都在表达自己独特的声音和观点。但人工智能,通过设计,模仿它从大量数据中学到的模式。这引发了对原创性的担忧。如果您在工作中过度使用人工智能,是否会削弱您的个人贡献?

人们经常担心过度依赖人工智能会阻碍他们的创意成长。他们担心如果这个工具一直可用来做繁重的工作,他们自己的技能肌肉会变得虚弱。

3. 担心被抓住或被评判

还有被评判甚至被揭露的恐惧。许多用户认为承认他们使用人工智能可能会带来负面后果。比如,学生可能担心学术不端行为。专业人士,如内容创作者或文案撰写人员,可能担心如果别人知道是人工智能参与了工作,他们的工作会被贬值。在工作中,员工可能担心使用人工智能会让他们显得无能或懒惰。这些关于评判和后果的担忧可能会导致不愿意接受人工智能的恐惧。

4. 道德考虑和真实性问题

还有在将人工智能用于创意工作中存在的伦理问题。如果人工智能写了大部分的内容,谁拥有它?您需要披露其参与吗?是否应该始终透明地说明何时使用人工智能工具?

这些担忧是真实的,特别是在新闻,学术和营销等行业,原创性和信任至关重要的行业。在Hive团队中,我们经常听到这些讨论,因为我们在探索AI在帮助日常任务和协助内容创作方面的应用边界。

人工智能负罪感的普遍存在

这种内疚并不只是理论上的。许多跨行业的专业人士对使用人工智能工具感到矛盾。例如,我们内容团队的一名Hive员工最近分享了他们如何在使用人工智能进行初稿时感到困扰。虽然这节省了时间,但他们无法摆脱成品并不是“他们自己”的感觉。

这种类型的人工智能罪恶感并不是我们公司独有的。一项关于人工智能采用的研究显示,超过50%的营销人员现在以某种形式使用人工智能,但许多人担心其对创造力和真实性的长期影响。同样,教授们报告说在学生作业中越来越多地使用人工智能,虽然它提供了便利,但也引发了关于学术诚信的担忧。

这些例子展示了围绕人工智能的冲突在不同领域中是如何深入的,包括我们自己的云计算产业。

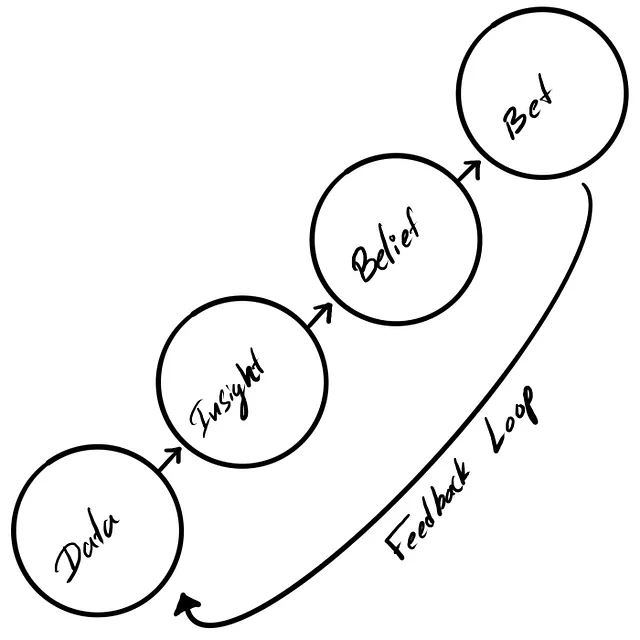

人工智能内疚的心理学

为什么AI愧疚让这么多人发自内心的触动?其中很大一部分原因与我们与技术以及努力的关系有关。在创造性任务(如写作)中,努力工作带来了一种自豪感。当AI如此迅速地产生内容时,我们感觉好像走捷径,即使这并不完全属实。

这种内疚也与认知 dissonance 相关 - 当我们持有两种矛盾信念时产生的心理紧张。一方面,我们珍视创意、原创性和人类努力。另一方面,我们欣赏人工智能提供的便利和效率。这种内部冲突造成了许多人在使用人工智能工具时所感到的不适。

这与其他技术工具首次出现时人们的感受相似——比如拼写检查、计算器或谷歌。每一个工具都引起人们对其会取代人类努力或削弱某些技能的担忧。然而,随着时间的推移,这些技术被整合进我们的工作中,而没有取代人类创造力和思维的基本作用。

支持和反对人工智能工具的理由

反对人工智能工具

- Loss of authenticity: AI's reliance on patterns and data can sometimes produce content that lacks a personal touch, making it feel less authentic. 失去真实性:人工智能对模式和数据的依赖有时会导致产生缺乏个人化的内容,使其感觉缺乏真实性。

- 过度依赖人工智能:一些人担心过于频繁地使用人工智能工具可能会削弱他们的能力或随时间减少他们的创造力。

- 道德灰色地带:谁拥有AI生成的内容?用户在AI参与时是否总是应披露?这些问题仍未得到解决,尤其在专业背景下可能引起担忧。

AI工具的案例

- 提高效率:人工智能工具能够处理重复性任务,例如创建大纲,起草邮件,甚至撰写初稿,帮助用户节省大量时间。

- 增强创造力:AI不是取代创造力,而是增强它。像ChatGPT这样的工具可以提供新的想法,建议新的角度,或帮助作家克服障碍。

- 无障碍对所有人都有好处:人工智能可以使写作民主化。非母语人士、学习障碍者以及时间有限的人可以使用这些工具更有效地交流。

在Hive,我们亲眼见证了人工智能如何提高生产力,而不是取代人类创造力的价值。我们使用人工智能来补充,而不是取代人类的努力。

克服人工智能的罪疚感:负责任使用的策略

如果你正在抗衡人工智能的负罪感,你并不孤单。但是有方法可以道德和自信地使用这些工具:

- 设定清晰界限:使用人工智能作为辅助而非替代。让其处理重复性任务,但确保你的核心想法和创意得以体现。

- 保持透明:无论是在专业环境还是学术环境中工作,都要坦率地说明你是如何以及何时使用了人工智能。透明会建立信任并培养责任感。

- 专注于协作:将人工智能视为增强您创造力的工具,就像拼写检查器或语法助手一样。它可以帮助您工作更快,但创意方向仍应来自您自己。

在 Hive,我们鼓励负责任的人工智能使用,确保我们的员工知道如何利用这些工具,而不会影响他们的创造力或道德标准。

道德考量:平衡人类创造力和人工智能辅助

使用AI工具最大的问题之一是我们在哪里划定界限。随着AI的不断发展,我们必须考虑:

- 透明度:我们应该披露有关 AI 在创造内容中的作用有多少?在 Hive,我们认为透明度是保持信任的关键。

- 所有权:谁拥有由人工智能生成的内容? 这方面的法律和道德影响仍在发展中,但公司和个人都必须认真对待这个问题。

- 人工智能是一种工具,而不是一种替代品:人工智能不能独自创造 - 它是对人类输入的响应。这就是为什么将人工智能视为一种增强人类创造力而不是替代它的重要性。

未来展望:人工智能工具的演变

随着人工智能的不断发展,对其使用的负罪感可能会减少。当前辅助技术变得正常化的方式,人工智能工具可能会走上同样的道路。

展望未来,人工智能可能会更多地融入内容创作领域,像Hive这样的公司正在引领负责任的人工智能发展之路。我们相信人工智能和人类创造力可以共同合作,透明度、伦理考量和责任感将塑造人工智能辅助写作的未来。

拥抱人工智能,但保持忠于你的创造力。

AI工具如ChatGPT正在成为我们工作和创作的重要组成部分。在Hive,我们第一手看到了这些工具的好处和挑战。虽然人工智能效率和人类创造力之间存在自然的紧张关系,但我们相信可以在不牺牲真实性或独创性的情况下使用这些工具。

关键是要负责任地使用人工智能,设定明确的道德标准,并对它在工作中的作用进行透明化。随着我们进入这个新的写作和内容创作时代,真正的问题不是我们应不应该使用人工智能,而是如何能够在道德和有效的前提下使用它来增强 — 而不是取代 — 我们人类的特质。

今天立即下载最新版本的hiveDisk