为什么在招聘中会有人工智能偏见?

人工智能出现不良反应的一个主要原因是我们不知道如何要求我们想要的。有时候我们甚至不知道自己想要什么。当我讨论DALL-E很难画出一个笑话时,我以轻松的方式介绍这一点。当你试图得到一个特定的正确答案时,人工智能表现良好。但是当命令是“画一幅让我笑的图片”或“重写这个使其更好但保持我的语气”,它并不出色。我知道。我试过这两种情况很多次。

此外,生成式人工智能工具绝不会告诉你问题问得不好;它只会猜测正确答案。有时这特别有用。我曾问ChatGPT“什么是一款快捷的亚洲制造汽车?”(零号汽车)或“一个以A开头的意思是‘到处都有’的词是什么?”(无处不在)。即使我的问题在前者的情况下非常模糊,后者的问题中关键事实错误,但它都给出了正确答案。

但是当我们在实际重要的领域问出错误的问题时就会出现问题。如果我让ChatGPT推荐一首有趣的歌曲,它会决定有趣的定义并根据这个定义来推荐。我可以接受这个推荐(即使这可能不是对我来说最佳的选择),或者我可以提出一些更具体的要求。如果我让它推荐一个好的数学家来填补一个开放职位,但这个问题的风险更高,它会做完全相同的事情。

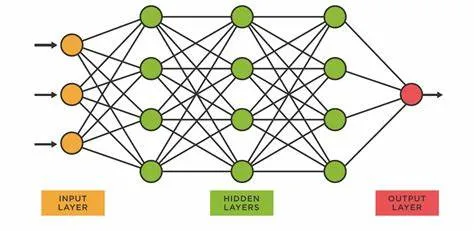

AI工具将列出描述一位优秀数学家的特征列表。它可能从上述训练中获得的一些特质包括'擅长解决问题'、'逻辑思维'、'了解数学理论'、'戴眼镜的人'。大多数人将同意前三个特质,但可能会对最后一个有疑问。但这四个特质都是相当有逻辑性的假设。

我不知道近视等于擅长数学的刻板印象是从哪里来的,但你不得不承认这种观念很普遍。然而,我们很容易理解为什么它可能有性别要求。如果这个工具是基于历史招聘信息进行训练的,任何1964年以前的信息可能会明确指出他们只招聘男性。著名的历史数学家很可能都是男性。虽然女性在STEM领域的代表性正在增加,但我认为它还没有达到平等。如果你在寻找一名数学家,最优秀的候选人很可能是男性。

这对我来说看起来不太舒服。但AI工具的“工作”是找出最有可能成为优秀数学家的特征。它并不区分“逻辑”作为数学家定义的固有特性和“人”作为系统性压迫的结果,这种压迫不让女性从事这些崇高的工作。从AI的角度来看,找到这个职位的优秀候选人可能需要固有的技能和应对父权制的能力。除非被告知否则,它将同时使用这两个标准。

您可能已经注意到,当我谈到自己的经历时,我会使用ChatGPT,而当我谈论假想的人事机器人时,我会使用“一个AI工具”。这是因为市场上的主要工具,包括ChatGPT,在教授时都明确被告知不要提供可能被视为偏见的答案。人们似乎使用生成式AI工具时首先要做的一件事就是试图让它们说出种族主义言论,这无可避免地会成为新闻。然而,一个规模较小的、由内部开发的AI工具可能没有这些明确的禁止。您可以要求ChatGPT整天描述一个完美的求职者,它永远不会使用外貌特征甚至性别语言。即便如此,主要市场工具仍然存在一些问题。如果您让ChatGPT画出一个完美的求职者,它除了使用外貌特征外别无选择,并且几乎总是会为STEM工作画出一名白人男性戴着眼镜。

这是我们正在处理的一个真正问题。纽约市最近出台了一项限制使用人工智能进行招聘决策的法律,原因正是这些。我不知道这项法律会有多有效,但我是有希望的。我认为监管机构和创新者需要进行更多的工作,以了解人工智能模型的工作原理。我认为,所有相关方的一个很好的第一步就是努力确保我们提出的问题是明确的。