LLMs的推理能力:机器中的幽灵

这是一篇简短、有趣、不是很严谨的文章,我们探讨LLMs是否“思考”或“推理”。我将从形式语言和形式系统中提取一些想法,并在AL的背景下,特别是LLMs(大型语言模型)的背景下考虑它们。

我们应该指出,“理由”是一个被非常宽泛使用的术语,通常我们认为这是考虑数据和逻辑陈述,并将它们合成为一个结论的过程。 这通常是使用逻辑规则等来完成的(但也许实际上并非如此,稍后会讨论更多)。

什么是形式语言?

一组有限或无限长的字符串,被独立地考虑,不管这些字符串或其中的符号可能具有的任何意义。如果A是任意一个集合,A语言(或A上的语言)是A-词的任意集合(参见词)。A被称为这种语言的字母表。

因此,如果我们进行添加和减去语言中句子的操作,我们可以得到所谓的形式系统。

一个形式系统是一个抽象的结构和公理系统的形式化,用于通过一组推理规则推导定理从公理。

在1921年,大卫·希尔伯特提议使用形式系统作为数学知识的基础。

假设人类语言(符号)作为形式语言符合哥德尔不完备定理的标准(实际上并非如此)对于形式系统,那么这个系统将无法从其公理中一致地推导出所有可能的结果,但这并不意味着它不能进行推理 - 这只意味着它无法进行全部的推理。这个问题早在ChatGPT尝试帮助狐狸、母鸡和一袋玉米通过河流之前就一直困扰着科学家。

也许LLM推理没有固有的障碍?

哥德尔不完备定理大致指出,在足够丰富的逻辑系统中,会存在一些真实陈述,这些陈述仅凭公理无法证明(类似于连续性假设)。

为什么所有这些花哨的谈话都重要吗?

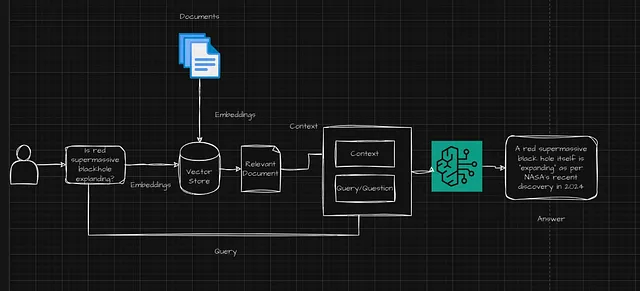

输入到LLMs中的数据是没有固有含义的标记,然后根据在文本中的位置,一个复杂的网络分配权重以确定观察到的关系,即人类产生文本,网络被训练来复制文本的模式。

好的,那又怎么样?

人类使用不同形式的逻辑,但它们基本上归结为我们写作,可视化,言说等逻辑陈述。

但这是从哪里来的呢?

人类所产生的一切都源自头脑,来自人类的新皮层——一个更先进的神经网络——实际上,我们所感知的思维是大脑网络中的部分激活。那么,我们能说对我们来说看起来像是意识逻辑的东西,实际上不是在一个更优越的神经网络中进行模式匹配吗?(嗯,比我们现在能产生的更优越)

因此,我们可能会问为什么以人类语言为基础的形式系统(在那里我们一直在进行语言的元分析)不能够推理?

反对LLM的一个论点是它们按照模式出现逻辑错误,但这不就是我们教导学生解决问题时要寻找的吗?要找到模式,然后进行修改?在修改模式时出现的错误并不意味着LLM不具备推理能力,只不过是为目前的LLM推理能力不佳提供了证据。这并不意味着它们不能够推理。

确实,我们理性的人类可能犯错误,如果你曾经批改过逻辑或数学的大一课程的话,你就会意识到这一点。

这个问题,或许问题本身?

在没有一个明确定义“推理”的情况下(实际上,它很可能需要一个几乎所有人类都符合的定义),我们既不能反驳LLMs可以进行推理的说法,另一方面也不能反驳它们不能进行推理的说法。

我认为我们经常倾向于认为LLMs不能理性思考,因为它们看起来、感觉起来、听起来(最后一个正在改变)都不像人类,所以它们不能理性思考 - 但这真的是科学的观点吗?

也许直到有人更聪明出现并证明一种或另一种方法,也许值得考虑LLMs可以推理,并且具有足够的力量可以推理到或超过人类的能力,但当然缺少的是什么让它似乎不能推理,是意志?