更大的语言模型总是更好吗?小语言模型的兴起

虽然更大的语言模型通常能够获得令人印象深刻的性能,但在每个用例都有其独特要求时,定义“更好”并不那么简单。小型语言模型(SLMs)的崛起表明,规模越大并不总是更好。在本文中,我们将深入探讨小型语言模型的世界。尽管它们规模较小,但它们正在崛起并展现出有希望的结果,甚至在某些应用中胜过更大的模型。

什么是小型语言模型?

术语"小型语言模型"是不言而喻的-它指的是与大型语言模型(LLM)相比尺寸较小的模型。虽然LLMs包含数百亿个参数,但SLMs包含数百万到数十亿个参数。尽管参数较少,SLMs在质量上并不作妥协。事实上,一些额外的功能使SLMs在某些使用情况下具有竞争力甚至更胜一筹。

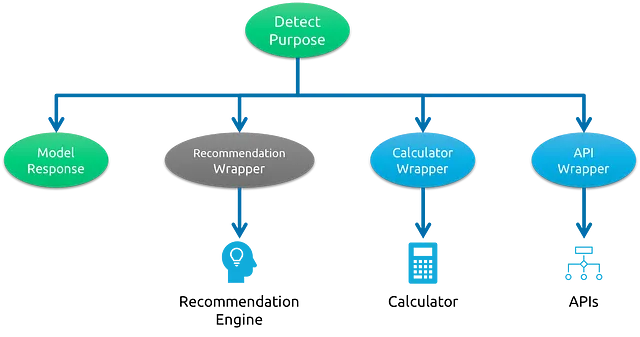

建筑

在大多数情况下,SLM与LLM共享类似的架构。通过使用知识蒸馏、修剪、量化和架构优化等技术,可以减小它们的体积,而不会显著影响性能。

方便

由于其尺寸较小,SLM需要更少的计算能力,使其在推理过程中更快。在普通个人电脑上运行一个LLM具有挑战性,用户可以轻松在自己的设备上运行一个SLM。这种易用性使更多的个人和组织能够利用先进的语言模型,而无需投资昂贵的硬件。

数据安全

使用商用语言模型(LLMs)如ChatGPT在某些任务中可能会带来安全顾虑,特别是涉及敏感数据时。在这种情况下,开源SMLs提供了一个可行的解决方案。一个特定领域的开源SLM可以直接安装在用户设备上,让他们享受语言模型的功能,而不必在网络上共享任何信息。例如,像Mistral 7B或Phi-2这样的模型可以在平均GPU上运行,而且一些模型还有经过量化的版本,甚至可以在CPU上运行。可以利用Python包LaamaCPP来运行CPU上的量化模型。

微调和领域特定知识

LLMs接受了数十亿甚至万亿数据点的训练,使它们对语言和一般知识有广泛的了解。然而,SLMs可以用少量高质量数据进行领域特定任务的微调。当在特定领域的知识深度比广度更重要时,SLMs表现出色。

例如,在医疗保健行业,具有特定领域专业知识的 SLM 更受青睐,而对于对各种主题有广泛但浅薄理解的 LLM 则不是。在这种情况下,质量胜过数量。

快速实验和更好的可解释性

基于其较少的参数和减少的计算需求,SLMs非常适合用于实验。而LLMs需要大量的计算能力,并且可能需要几个月来训练或微调,而SLM可以在一周内进行微调,而不需要大量的硬件支持。另外,由于使用的数据集更小,领域更明确定义,SLMs通常比LLMs更易解释。如果一个新的微调模型表现不如预期,一个新模型可以很快进行开发和测试。

环境考虑

由于SLM不需要太多计算资源,它们可以以较低的成本轻松部署和维护。一些SLM甚至可以部署在移动电话等边缘设备上。它们较低的能源消耗导致减少碳足迹,使其更环保。

结论

小语言模型处于使高级语言技术更加民主化的前沿。它们表明,通过更好的优化和架构设计,较小的资源可以实现重要目标。随着小语言模型前景看好,我们很可能会看到具有更少参数的强大语言模型,可供更广泛的人群使用。

感谢阅读我的帖子。