o1比ChatGPT更蠢

为什么工具比逐渐减少错误更重要

有关o1发布的炒作非常大,它被宣传为一种“推理模型”,在做某事之前“思考更多”。一些人甚至声称这是GPT5,但不同寻常的是,萨姆·奥尔特曼为此提供了一些透视。

我要再进一步说,对于企业客户来说,这种进展并不是朝着正确方向。也许在某些情况下会有帮助,但我在GPT40版本的简单数学领域进行的一项非常好的分析将为我解释为什么从商业角度来看,这实际上是一个进化的死胡同。

那么,这是一个好计算器吗?实际上不是。它已经从一款糟糕的计算器变成了一款非常糟糕的计算器。

我提出了这个问题,如果你使用 ChatGPT,那么在40的情况下,准确度实际上是100%。研究人员很好心地指出了显而易见的事实,即他们正在使用API而不是ChatGPT,并且这些API不利用ChatGPT的技巧。

那个“技巧”对企业比4o和o1之间的模型改进更有用,它甚至是经常用来表示智能的技巧。

为什么 ChatGPT 表现优于 GPT

然而,如果您使用ChatGPT并使用GPT4o模型重复该练习,您会发现它每次都做对了,100%的时间(或者至少我还没有看到失败)。为什么会这样呢?

由于ChatGPT 4o使用工具

当您向它问一个数学表达式时,它不会尝试解决它本身,而是会编写一些Python并运行它,而Python可以非常擅长数学问题。为了演示,让我们看一个数学表达式:

59873664280 + 57269725900 + 37962858060 + 91229152480 + 26696643750 + 28441684970 + 82654464030 + 96371909380 + 20116137350 + 97380676700

答案:597,996,916,900

现在显然你可以检查一下,但我把它简化了最后一位数字是零,8+0+6+8+5+7+3+8+5+0 = 50,意味着它应该以两个零结束。

ChatGPT 4o:9秒—597,996,916,900

ChatGPT 4mini: 3.83 秒 — 532,250,693,490

ChatGPT o1-预览:50秒 — 59,799,691,690,000

ChatGPT 01-mini: 18秒 — 598,996,916,900

Google: 1秒 — 597,996,916,900

那最后一个只是将总和粘贴到Google搜索框中,因为Google已将工具集成到搜索中。

现在我听到有人尖叫说,“ o1-preview 得到了正确的数字,只是相差了两个数量级”,而“ o1-mini 只错了一个数字”,但这完全错过了重点。正如我上面引用的更详尽的研究所展示的那样,与计算器相比,这些模型在数学上表现得非常糟糕。面对数学挑战时,逻辑思维链应该从以下开始:

我有计算器吗?

01似乎相信那些在学校说你必须学习知识的老师,只是因为“你不会一直带着计算器”,而说实在的,我的老师们从来没有这样做,他们更多地是解释说,理解这些基本规则会在以后帮助你,因为规则会变得更复杂,计算器跟不上。

然而作为一个计算机程序,我认为使用计算机并不算是“作弊”,而在商业上这正是您想要做的事情。

因此,可以毫不夸张地说,在这种数学挑战中,ChatGPT在性能方面远远优于API,这为我们在企业中采用人工智能提供了一个教训。

工具使用是智慧的指标

有人声称o1“智商超过120”,但当它在11 x 13时仍然艰难时,这种说法有些慷慨。在最新一波人工智能之前,对动物智商的评判非常常见:

他们使用工具吗?

并且剧透警告:很多动物使用工具,不仅仅是灵长类动物,甚至有昆虫使用工具的例子。

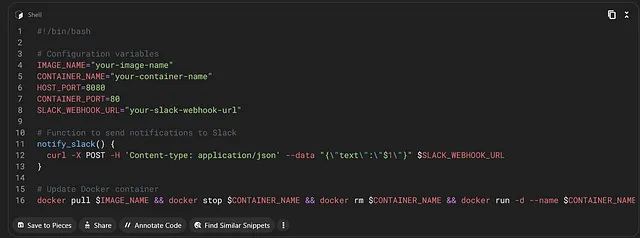

因此,使用AI解决方案内的工具(如ChatGPT所做的)不应被视为“作弊”,特别是在它的情况下,它编写了大量的Python代码来完成任务,但它也可以轻松地调用专门设计用于该功能的库或API,甚至可以编写一个REST调用给谷歌并获取结果,如果有需要。

工具使用是明智的,在企业中,这不仅仅是明智的,而且它是唯一真正可以让您信任人工智能正在按照您的意愿进行操作的方法。

在任何业务思维链中的第一步都应该是“什么是最好的工具来做这件事?”

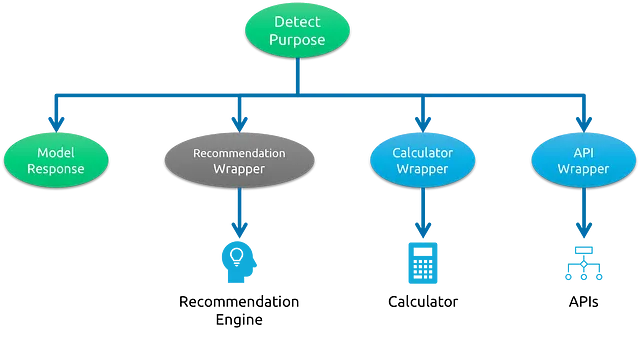

Google、ChatGPT或任何提供“多工具”功能的解决方案是如何解析这些请求的,在尝试自行处理工作之前,首先会查看是否有更好的方法来回答问题。我不打算深入讨论技术,这些技术可以是从正则表达式到完全成熟的LLM解决方案等。如果你想在ChatGPT中演示这一点,可以看看以工具化方式解决草莓问题的简单方法。

因此,您的AI应用程序的第一项工作应该是确定请求的目的以及是否有更好的工具可以满足该请求,或者是否使用工具是解决问题的一部分。

你需要掌控工具

因此,在設計一個完成企業任務的人工智能系統時,您將始終面臨這個挑戰,即在業務中可能有多種方法可以做某件事,但只有一種方法是允許人工智能去完成的。例如,獲取客戶記錄可能有多個選項:

你可以:

- 根据客户名称在客户数据库中生成SQL查询

- 使用一个RAG对比所有先前的客户发票,以找到客户。

- 只需使用您最后一个客户记录,它可能是正确的。

事情的清单可以继续下去。然而,情况很可能是系统应该做的一件事是:

- 使用标准的客户安全身份验证服务。

这是一个你建立的工具,用来通过电话号码和附加的安全信息识别客户,以防止产生幻觉或误认风险。

没有任何方式可以让 OpenAI、Anthropic、Mistral、Meta、Google 或任何其他模型创建者了解你企业中的这些工具,但如果你让它们获取一堆能力,它们绝对可以“猜一下”。就像它们可以进行基本数学计算一样。你知道的,一窍不通。

工具将隐藏在API的背后 - 为什么你应该关心

今天ChatGPT会告诉您,每次它编写一些Python代码来解决问题时,但是是否永远都会是这样?将来,如果在GPT5 API背后实际上是在为您做这种工具决策,我们为什么会担心。这将使准确率大幅提高,并带来显著强大的新功能。

这也意味着你对一些本地可管理的事物被严重高价收费。以数学示例来说,把一个电子表格给API,让它把数字加起来并画出图表是非常好的,但如果你为代码周围的一个包装支付费用,那么费用可能会迅速变得非常昂贵。

这些工具如果你不了解它们,也可能带来重大风险,因此加入一些能够动态调用REST API的东西可能会使用OAuth2,并将公司身份验证传播到其他服务,虽然你拥有访问权限,但你可能不希望OpenAI代表你访问。如果LLMs在幕后使用工具而你不知情,那么你的安全风险和成本风险将增加。

而且他们仍然不知道您公司的工作需要什么正确的工具。

我们需要控制工具,我们需要教会模型如何使用这些工具。

o1是关于企业真正需要看到模型采纳激增的边栏。我们需要的一些功能包括能够“去调谐”模型以消除风险和我们不想要的功能。

一个绝对关键的方面是以更好的方式让LLMs和大型“行动”模型能够与我们企业的实践和工具正常工作,从简单的挑战,比如计算或字符串操作,到如何创建订单或安全获取客户信息,企业LLMs需要被教导使用多种工具,需要正确管理其使用方式。

使用LLM作为您工具箱中的一种工具是使LLMs在企业规模上真正有用的唯一方式。它甚至可以成为许多解决方案中该工具箱的入口工具,但您需要控制它使用的工具。