注意力就是一切:或者说我如何学会停止担心,爱上变形金刚

介绍

女士们先生们,技术爱好者,以及无意中点击进来以为这是有关正念的人们 - 欢迎! 今天,我们将深入探讨机器学习世界,揭开题为“注意力机制是你所需”的论文之谜。 不,这不是一首迷失的披头士乐曲,也不是您高中老师的建议; 这是一个开创性的概念,正在改变我们处理语言模型的方式。 我们要加点幽默元素来做,因为为什么人工智能一定要无聊呢?

RNNs和遗忘的艺术

记得以前循环神经网络(RNNs)是最酷的吗?它们被认为是序列数据的魔术师,可以处理从语音识别到预测句子中下一个单词的一切。但问题是:RNNs的记忆力就像魔术表演中的一只金鱼 — 容易分心,很快忘记刚刚发生的事情。

想象一下阅读一本小说,你在第二章就忘了主人公的名字。这就是循环神经网络。他们在处理长期依赖性时很困难,让它们几乎跟使用巧克力壶一样不可靠。

注意力机制:神经网络中的便利贴 equivalent界

为了帮助循环神经网络记忆,科学家们给它们添加了注意力机制——一种能够集中注意力于输入数据特定部分的方式。可以把它想象成在教科书上贴满便利贴来记住重要内容。这种方法有效,但却像是在漏水的大坝上贴上创可贴。

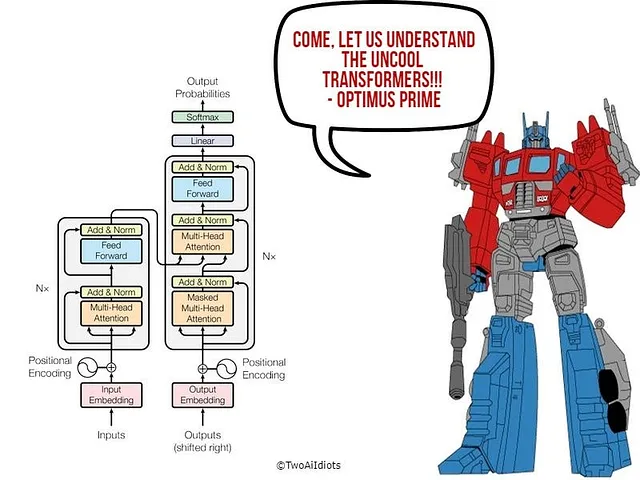

变形金刚:不是你在寻找的机器人

输入Transformer模型,省去Optimus Prime。《关注就是你需要的一切》的作者们决定RNN已经out了。他们抛弃了RNN并构建了一个完全依赖注意机制的模型。大胆的举动?绝对是。有效的?当然。

这就像解雇整个管弦乐团,然后用一个DJ来取而代之,他确切知道你想听什么,你想听的时候。

注意力机制: 神经网络的八卦女孩

自我关注使模型能够在编码特定单词时查看输入句子中的其他单词。想象一下你在聚会上,窥探每一次对话,以完全理解社交动态。现在,你不仅专注于关于天气的尴尬对话;你吸收所有有趣的细节,以理解更大的整体图景。

在神经网络术语中,每个单词(或标记)都可以查看其他每个单词,以决定什么是重要的。这就像模型是一个永远爱打听别人的人 - 而且它起到了作用。

位置编码:因为词序很重要,即使你是尤达

由於Transformers不是按順序處理數據,因此它們需要一種方法來理解單詞的順序。輸入位置編碼——將有關每個單詞位置的信息注入模型的方法。

把它视为给每个单词一个独特的刺青,上面写着,“我是这个句子中的第三个单词”。如果没有它,模型可能会认为“我吃了蛋糕”和“蛋糕吃了我”是一样的,这在除非你在一部奇怪的恐怖电影中,否则没有多大意义。

多头注意力: 九头蛇策略

为什么只有一个关注机制,当你可以有多个头部关注不同的事物呢?多头注意力允许模型同时关注各个位置。这就像在大脑浏览器中打开多个标签,并实际上跟踪所有这些标签。如果我们人类能够在不崩溃的情况下做到这一点就好了。

前馈神经网络: 派对结束后

经过所有的关注之后,模型通过前馈神经网络传递数据。就像在剧烈锻炼后的冷却阶段,或者在事情在更轻松的节奏中处理时的后续派对一样。在这里没有什么革命性的东西,但保持事情的流动是必不可少的。

编码器和解码器:AI 的蝙蝠侠和罗宾

Transformer 模型由一个编码器和一个解码器组成,编码器用于读取输入句子,解码器用于生成输出句子。它们是这个操作的动态二人组。编码器就像蝙蝠侠—沉稳,收集所有信息。解码器就像罗宾—接收信息并将其转化为有用的东西,比如拯救哥谭市或者在这种情况下翻译句子。

为什么你要在意?除了给你的朋友留下深刻印象外。

变压器已经在自然语言处理任务中发挥了重大作用,如翻译、总结,甚至撰写诗歌,让人不会觉得像是一个烤面包机所创作。由于可以并行训练,它们的训练速度更快,意味着它们在早晨高峰期比咖啡师更擅长多任务处理。

此外,了解变形金刚使您在技术聚会上可以吹嘘一番,谁不想呢?

结论

“注意力就是你所需的一切”不仅仅是一个引人注目的标题;它是一个革命性的想法,正在改变我们如何利用人工智能处理语言。通过摒弃过时的模型,专注于注意力(具有讽刺意味),我们迈出了一大步向前。

所以,下一次有人提到变形金刚,你开始想到迈克尔·贝的电影时,你可以自己暗自发笑,知道你对一种不同类型的大片有所了解。

免责声明:在撰写本文过程中,没有伤害任何RNN。它们只是被转移了注意力。