搭乘新的Chat GPT o1进行一次体验

编辑:我分享这个问题的人都问我 4o 在同一个问题上的表现如何?所以我会在问题末尾添加 4o 的解决方法

一个小时前,Open AI发布了其最强大的o1模型。据说这个模型是为了执行复杂任务而建立,并被公司吹捧为最“像人类”的模型。一旦我尝试使用它,明显的事情就是向它提出一个复杂的问题,花了我超过15分钟的时间来解决(是的,我没有开玩笑)。

问题看起来很简单,但涉及很多复杂因素,而且所有事物都相互关联。

PS: 我想吃甜食,我用了Laddoos,这是一种常见的印度甜食

拼图

我给了安德鲁11,000个拉杜,每当分钟指针横跨时针时,安德鲁每次吃掉一个拉杜的3%,这是在一辆从俄罗斯圣彼得堡到中国北京的火车上。 每次到达新的时区时钟都会被重置。 每次火车进入一个新的国家,安德鲁都会得到和他以前一样多的拉杜。 安德鲁在北京下车时有多少个拉杜?

乍一看,这个问题可能看起来有些幼稚,但实际上它包含了几层复杂性。

拉都消耗机制:当分钟手过小时手时,安德鲁每次吃一个拉都的3%。时钟在新时区重新设定:时钟重设会影响手的交叉频率。进入新国家时拉都翻倍:安德鲁的拉都储备每次他进入新国家时会翻倍。地理和时间因素:旅程跨越多个时区和国家,影响计算。

聊天GPT 01的第一次尝试:错过细微差别

在其初始回应中,o1:

1. 总计分钟针相交次数:假设每12小时分钟针与时针相交11次。根据旅程持续时间估算总交点数。 2. 考虑拉杜消耗:将相交次数乘以拉杜的3%,得出总拉杜食用量。 3. 包含拉杜加倍:进入蒙古和中国时将拉杜数量加倍。

监督

模型没有准确地解释:

- 时钟重置:它没有考虑到在每个新的时区重置时钟如何影响手的交叉时间。 - 双倍后的拉杜消耗:它没有计算安德鲁在他的库存翻倍后会吃多少额外的拉杜。

我的反馈

我指出:

在安德鲁继续吃掉第一次翻倍后的3%拉杜甜点之后,时钟会在每个时区重新设定,这看起来不太对劲。

Chat GPT o1的第二次尝试:更接近,但还没到位

考虑我的反馈意见,人工智能再次尝试:

1. 重新计算分钟指针的交叉点:- 基于在每个国家停留的时间进行交叉点的计算。 2. 在加倍后包括拉都消费:- 计算每次加倍事件后的额外消费量。 3. 考虑时钟重置:- 确认时钟重置,但仍然计算每个国家的交叉点。

持久错误

这个模型仍然没有。。。

计算每个时区的穿越次数:它继续根据国家而不是时区计算穿越次数。- 充分结合时钟重置:对时钟重置对手部穿越频率的影响没有得到准确反映。

我的反馈

我回答说:

依然错误,因为你需要根据时区而不是国家来计算手交叉次数。

AI的第三次尝试:做对

意识到错误后,人工智能重新解决这个问题:

步骤1:了解行程的时区

- 穿越的时区:UTC+3到UTC+8(总共六个时区)。 - 时钟重置:在每个新的时区发生。

步骤2:计算每个时区花费的时间

总行程时间:约144小时(六天)。 - 每时区时间:144/6= 24

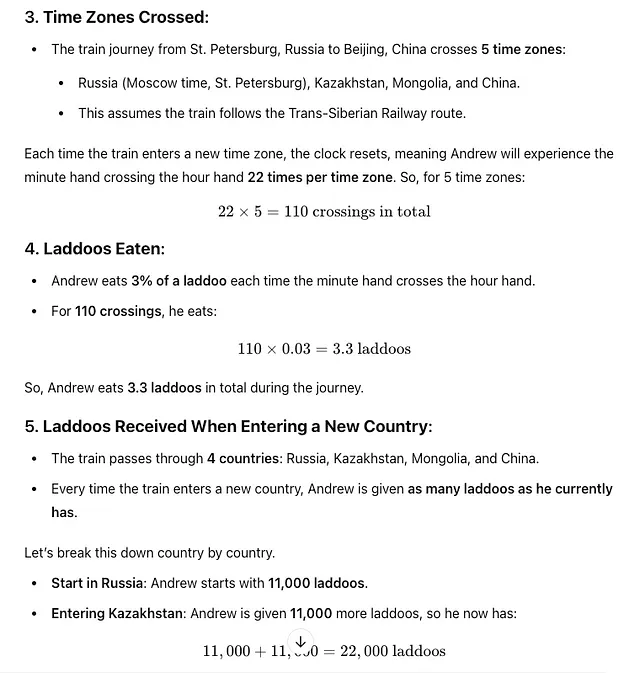

步骤3: 计算每个时区的分钟指针交叉数

- 分针跨越:每隔65 + 5/11分钟发生一次(约65.4545分钟)。 - 每个时区的总跨越次数:1440分钟/65.4545分钟每次跨越=约22次跨越。

第四步:计算每个时区的Laddoo消耗量

- 每次通过吃的Laddoos:0.03个laddoos(占一个laddoo的3%)。 - 每个时区吃的Laddoos:22个通过 X 0.03 = 0.66个laddoos

第五步:跟踪拉杜在不同时区和国家之间的情况

初始状态

- 起始的拉杜斯:11,000。

时区UTC + 3至UTC + 7(俄罗斯)

对于这五个时区中的每一个:

- 吃掉的奶球数量: 0.66个奶球。- 每个时区后剩余的奶球数量: — UTC+3后: 10,999.34个 — UTC+4后: 10,998.68个 — UTC+5后: 10,998.02个 — UTC+6后: 10,997.36个 — UTC+7后: 10,996.70个

时区 UTC+8

俄罗斯节目

- 吃掉的拉杜数:0.22个拉杜 - 剩余的拉杜数:10,996.48个

进入蒙古

- 拉杜翻倍:10,996.48 X 2 = 21,992.96 - 蒙古(UTC+8时区)吃掉的拉杜:0.22个拉杜 - 剩余的拉杜:21,992.74。

进入中国

- 拉杜加倍:21,992.74 X 2 = 43,985.48- 中国(UTC+8)吃的拉杜:0.22个拉杜- 剩余的拉杜:43,985.26。

步骤6:最终计算

在旅程尽头的总Laddoos数量:大约43,985个Laddoos

结论

通过反复的问题解决和融入反馈,该模型在第三次尝试中准确地解决了复杂的拉杜谜题。这次经验的关键收获包括:

1. 精确性很重要:最初的错误计算源于未考虑每个时区的时钟重置,突显了精确参数的重要性。2. 反馈至关重要:我的干预引导了模型重新评估和改进其方法。3. 复杂性需要系统分析:将问题分解为更小、可管理的部分导致了正确的解决方案。4. 人工智能学习曲线:该模型展示了根据新信息学习和调整其方法的能力。

我的反应

这项练习不仅仅是为了得到正确答案,还要理解模型是如何处理复杂、分层的信息的。看到新的Chat GPT 1o模型逐渐演变其方法,令人着迷,展示了人工智能在问题解决中的潜力和目前的限制。

最后,我印象深刻,因为虽然我花了不到一分钟来解决这个问题,但让我自己理解它是相当棘手的,我仍然觉得我可能遗漏了一些东西,并且没有彻底检查模型的响应。但LLM只需要3-4分钟就可以做到。

你有什么想法?在评论中回复或联系我 :)

编辑:4o表现如何?

我向4o提出同样的问题,它一贯地过分简化了问题。它假定问题的各个部分,比如时区、国家跨越等并不相互关联。在指出这一点时,它承认了错误,但无法纠正它,而在纠正它的同时又漏掉了其他一些东西。

感谢您阅读这段有趣的旅程。如果您有任何想法或类似经历,请随时在下方评论中分享!