Sure, here's the simplified Chinese translation of "Paper review: Give Us the Facts": 论文评论:给我们事实

Sure, the translation of "Introduction" to simplified Chinese while keeping the HTML structure intact would be: ```html

介绍

``` This HTML snippet contains the translated text "介绍" (Introduction) wrapped in a paragraph (``) tag.

在像ChatGPT这样的大型语言模型(LLMs)不断发展的世界中,一个关键挑战是它们在生成输出时无法可靠地回忆和应用事实知识。虽然非常流畅,LLMs通常会出现幻觉或产生与事实现实不一致的响应。杨等人的研究提出了对现有工作进行全面调查,探讨如何通过外部知识图谱增强预训练语言模型,并提出了知识图谱增强的大型语言模型(KGLLMs)的新概念,以解决这一事实感知推理的差距。

To translate "Existing Approaches" to simplified Chinese while keeping the HTML structure, you would write: ```html 现有方法 ``` This HTML snippet ensures that the text "现有方法" (which means "Existing Approaches" in simplified Chinese) is correctly displayed and identified as Chinese text by specifying the language attribute (`lang="zh"`).

Sure, here's the translated text in simplified Chinese while keeping the HTML structure: ```html

该论文提供了将知识图谱中的外部知识集成到预训练语言模型(PLMs)中的技术的全面分类。这些方法可以根据在PLM管道中整合知识的阶段大致分为三类。

```以下是HTML结构的英文文本翻译为简体中文: 第一类是训练前增强方法。这些技术通过将文本输入与相关的知识图三元组或子图结合,对训练数据进行预处理。一些方法扩展输入结构,以联合表示文本和知识为统一的图形结构,而其他方法则简单地通过从知识图中提取的辅助实体信息来丰富输入。一些方法进一步通过生成完全新的基于知识图的合成训练数据来扩展。另外,一些训练前方法通过根据连接到知识图的命名实体来选择掩码来优化掩码语言建模的掩码策略。

Sure, here's the translation of the provided text into simplified Chinese while maintaining the HTML structure: ```html

During-training enhancement is another major category, where knowledge incorporation happens simultaneously with the language model pre-training process itself. A common technique is incorporating additional knowledge encoders or modules alongside the PLM’s encoders to enable joint learning of knowledge-aware representations. Other approaches insert specific knowledge integration layers or utilize flexible adapter components to fuse knowledge graph information. A number of methods also modify the pre-training objectives by introducing auxiliary knowledge-oriented tasks like knowledge triple or entity prediction alongside standard masked language model training.

``` Translated into simplified Chinese: ```html训练期间增强是另一个主要类别,其中知识整合与语言模型预训练过程同时进行。常见技术包括在PLM编码器旁边引入额外的知识编码器或模块,以实现知识感知表示的联合学习。其他方法则插入特定的知识整合层或利用灵活的适配器组件来融合知识图信息。一些方法还通过引入辅助的知识导向任务,如知识三元组或实体预测,来修改预训练目标,与标准的遮罩语言模型训练并行。

``` This translation maintains the original structure and accurately conveys the content in simplified Chinese.Sure, here's the translated text in simplified Chinese, while keeping the HTML structure intact: ```html

第三类是后训练增强,即在预训练的语言模型基础上进行微调,使用知识丰富的资源,如知识驱动的数据集或通过动态生成的知识提示进行增强。微调可以注入额外的领域特定事实知识,以适应下游应用。知识提示技术利用信息提取系统或知识图谱生成上下文事实提示,更好地为语言模型准备知识密集型任务。

``` This HTML snippet contains the translated text formatted for web use, ensuring it retains its structure for display on a webpage.Sure, here's the translation of the text into simplified Chinese while keeping the HTML structure: ```html 每一类方法都有其独特的优势和局限性。在训练前的方法虽然高效,但在数据预处理过程中可能引入噪音。在训练期间的方法能够实现紧密集成,但会增加模型复杂性。训练后的方法灵活性强,但依赖于高质量外部知识资源的可用性。作者强调,这些策略的组合,经过精心调整以适应大型语言模型,可能是发展强大的知识驱动系统的关键。 ``` This HTML structure ensures the text is formatted correctly for display or further processing as needed.

Sure, the translation of "Proposed Approach" into simplified Chinese while keeping the HTML structure would look like this: ```html 建议方法 ``` This HTML structure ensures that the text "建议方法" is displayed correctly on a webpage, maintaining both the content and the formatting.

在保持HTML结构的情况下,将以下英文文本翻译为简体中文: 尽管现有的增强预训练语言模型与知识的技术显示出了潜力,但作者们指出,在应用于像ChatGPT这样拥有数百亿参数的大型语言模型时可能存在潜在的限制。为了真正释放基于事实知识的推理在此空前规模上的能力,本文提出了发展知识增强的大型语言模型(KGLLMs)的构想。

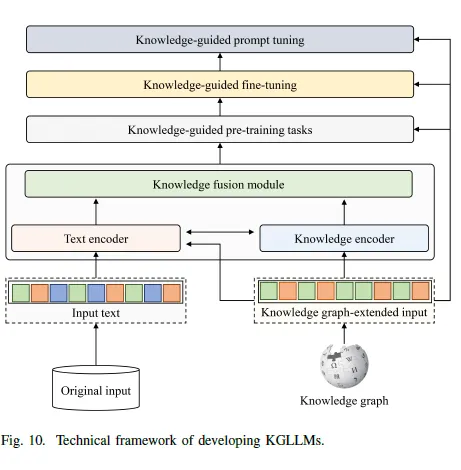

在保持HTML结构的情况下,将以下英文文本翻译为简体中文: KGLLMs的核心理念是将为较小的PLM(预训练语言模型)开发的成功知识整合方法扩展和调整,以适应当今巨型语言模型独特的架构、训练范式和计算规模。通过精心结合预训练、训练过程中和后期增强策略的优势,KGLLMs能够学会将神经语言模型的生成流畅性与知识图谱中呈现的显式结构化事实知识无缝融合。

Here is the translated text in simplified Chinese, keeping the HTML structure: ```html

提议的技术框架涉及在多个阶段利用知识图谱。在训练之前,可以采用知识驱动的数据增强和输入重构技术,创建信息丰富的预训练语料库。在大规模并行训练大型语言模型期间,可以将类似图神经网络的辅助知识编码器与语言编码器一起引入,以学习联合表示。还可以设计超越标准语言建模的新型知识感知预训练目标。

``` This HTML snippet contains the translated text in simplified Chinese, maintaining the original HTML structure provided.在训练后,该论文建议探索知识提示 — 从知识图谱自动生成事实提示,以更好地为大型语言模型准备知识密集型任务。像检索增强这样的技术允许在推理过程中查询外部知识源,也可以与知识图谱语言模型结合使用。

```html

作者们设想KGLLMs作为一个强大的解决方案,可以最终弥合大语言模型中的事实推理差距。通过将它们的输出基于现实世界的知识图谱,KGLLMs可以消除幻觉,同时保持真实性和稳健性 —— 这是一个关键要求,因为这些模型在越来越高风险的领域中得到部署。

``` This HTML structure ensures that the translated text ("作者们设想...得到部署。") is displayed correctly, preserving the format and content while translating the English text into simplified Chinese.以下是保持HTML结构的简体中文翻译: 然而,开发知识图谱增强语言模型(KGLLMs)是一项艰巨的挑战,涉及许多尚未解决的研究问题。诸如计算效率、处理多样且冲突的知识源、增强可解释性以及构建特定领域的KGLLMs等问题都需要进一步探讨。尽管如此,由于在可信任的、具备知识感知能力的人工智能能力中潜在的回报,这成为研究社区优先考虑的关键领域。

Sure, here is the translation: ```html

KGLLMs代表了一种有前途的方法,可以增强具有事实知识推理能力的大型语言模型。通过结合语言模型和知识图谱的优势,KGLLMs有可能产生比当前LLMs更真实、更强大、更可靠的输出。然而,要实现这一愿景面临着重大的技术挑战,需要研究界提供创新的解决方案。随着语言AI系统日益普及,开发能够进行真实沟通、避免幻觉和偏见的知识基础模型对于构建值得信赖的AI助手至关重要。KGLLM框架概述了未来的一个潜在路径,而优先考虑这一研究议程可能会为未来安全和负责任的AI带来实质性的好处。

Certainly! Here's the translation of "Reference" into simplified Chinese, while keeping the HTML structure intact: ```html 参考资料 ``` This HTML code will display "参考资料" in simplified Chinese.

To translate the provided English text into simplified Chinese while maintaining the HTML structure, you can use the following: ```html Yang, L., Chen, H., Li, Z., Ding, X., & Wu, X. (2023). Give Us the Facts: Enhancing Large Language Models with Knowledge Graphs for Fact-aware Language Modeling. arXiv preprint arXiv:2306.11489. https://doi.org/10.48550/arXiv.2306.11489. ``` Here's the translation of the text: ```html 杨,L.,陈,H.,李,Z.,丁,X.,& 吴,X.(2023年)。给我们事实:利用知识图谱增强大型语言模型的事实感语言建模。arXiv 预印本 arXiv:2306.11489。 https://doi.org/10.48550/arXiv.2306.11489。 ``` Make sure your HTML document is properly structured around this translation snippet to maintain formatting and links correctly.