掌握生成型人工智能:理解微调和提示的领域

介绍

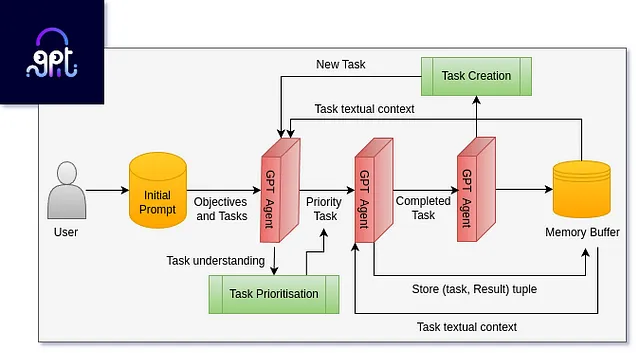

生成式人工智能的领域已经重塑了机器学习的格局,为开发者提供了创造专门模型的变革性工具。从精确微调的艺术到巧妙引导的高效能艺术,这一旅程探索了推动大型语言模型进入无与伦比能力领域的细微技巧。

传统与新时代

传统的机器学习模型开发是一个精细的过程,涉及大规模数据集、复杂的注释、超参数微调和迭代训练周期。以抽取为例,传统方法需要为每个特定任务创建一个单独的模型。相反,生成式人工智能引入了基于变换型 Transformer 架构的语言模型,只需要几行指令就可以显著简化开发过程。

预训练:知识的基石

旅程始于预训练阶段,模型在此阶段不仅学习语言的复杂性,还吸收了大量的真实世界知识。这种基础性理解使得LLM能够生成连贯和上下文相关的回答。例如,像GPT-3这样的模型会在各种互联网文本中进行预训练,使它们能够灵活地理解各个领域的内容。

微调:塑造模型的专业技能

微调是一个关键的步骤,用于进一步提升LLM以按照预先定义的结构给出回答的能力。这个阶段传递领域特定的知识,确保模型与行业要求相符。举个例子,对于医疗领域,微调基础模型可能需要在充满医学术语和背景的数据集上进行训练。

特定指令微调:成为一位多才多艺的对话者

超越结构细化,针对指令进行的精细调校将LLM转变为一个多用途的对话者。这种级别的精细调校使得模型能够无缝地遵循指令,将其转化为一个能够在各种情况下智能交互的聊天机器人。例如,OpenAI的ChatGPT经过精细调校,能够在各种广泛的话题上提供信息性回答。

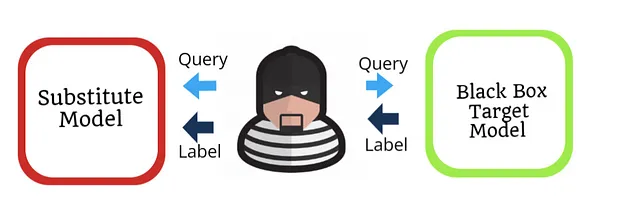

提示:通过明确的说明提高效率

经济实惠的优雅

提示是一种高效的艺术,通过明确的指示引导通用模型执行各种任务。开发者可以用具体指示来提示模型,从而节省模型开发中的大量时间。例如,用“写一篇关于太空探索的创意文章”的指示有效地利用了模型的生成能力。

低前期成本

一种提示的主要优点在于其较低的初始费用。与资源密集型的微调流程不同,提示依赖于有指导性的输入,使其成为预算有限且时间紧迫的项目的一个吸引人的选择。

上下文和特殊性的挑战

尽管推动具有高效性,但也存在挑战。它可能导致模型幻觉——制造出听起来合理但缺乏准确性的回答。此外,在涉及大量上下文数据的情况下,比如复杂的科学研究,推动可能无法生成细致且符合背景的准确回答。

细致调整:精雕细琢的精确度和专业技术

工艺中的精确度

精细调整有如雕塑,将通用模型的原始潜力精炼成为特定用途的精准工具。它需要使用经过精心策划的数据集重新训练模型权重,确保模型能够学习与当前任务相关的复杂细节。例如,考虑将语言模型进行精细调整,用于法律文件摘要生成——每个充斥着法律术语的法律文件都将有助于模型以法律的精确度提炼出关键信息。

隐私保护

微调的一个显著优势在于其解决隐私问题的能力。通过使用专有数据集对模型进行训练,敏感信息将仅限于私有虚拟私有云(VPC)或本地服务器中。这使得经过微调的模型非常适合那些数据安全至关重要的行业,比如医疗保健或金融。

精密需要付出代价

虽然微调可以增强精确度,但这是有代价的。在收集、注释和整理数据集方面的前期投资需要大量资源。然而,一旦模型被精调,推断的成本——即将模型用于预测——变得很小,使其成为长期应用的经济可行选择。

选择正确的道路:权衡利弊

细调的丰富性

微调是精确度财富的路径,提供定制、专业和上下文感知的模型。它的优点包括无与伦比的准确性和隐私安全保障。然而,一开始的成本和资源投资是显著的缺点。

快速推动

促进体现了迅速性,为特定任务的模型提供了经济高效的捷径。其低前期成本使其对快速发展具有吸引力。然而,它面临着错觉、特定性和潜在隐私问题的挑战。

结论

在生成式人工智能的动态领域中,开发者站在细调精度和促进效率的十字路口上。在Vivas.AI这里,我们理解每种方法的优缺点对于打造既拥有个性化专业知识又具备资源效率的解决方案至关重要,确保生成式人工智能成功融入各种应用。