混合智能的应用

我的同事ChatGPT

学生们探索与人工智能的共创

贡献学生:Muhammad Hassan Baig、Henrik Bergerbusch、Valeria Berschauer、Andrew Craig、Jennifer Dantzer、Gabriela Mardari、Jesus Habib Rivero Abdelnur、Aayush Tiwari

人工智能课程由Iris Lorscheid教授主讲。

欧洲应用科学大学(UE)|德国汉堡

人工智能已经存在了几十年,但直到 2023 年初,OpenAI 的明星产品 ChatGPT 被毫不庄重地提供给公众测试,才在科技界以外引起轰动。瞬间,AI 不再是一个仅限于商业和科学特定应用的抽象概念;它成为了一个承诺简化日常任务、优化我们生活各个方面的对话窗口。

很快,我们的时间线上开始充斥着有关人工智能获得自我意识的预测,工作无用论的严峻威胁,以及其潜力彻底改变经济和整个人类存在,类似于工业革命。基于ChatGPT的应用承诺可以立刻解决繁文缛节、客户服务、文案撰写、内容创作、编程写作、学生作业,甚至是考试。

在LinkedIn上,承诺提供完美的一揽子备忘单来代替其他应用程序、员工甚至整个团队的帖子数量激增。

更不用说像Dall-e或Midjourney这样的图像生成器,它们的创作已经变得与实际照片难以区分,不仅引发了关于艺术创作、质量和版权的讨论,还围绕着图像的可信度展开了讨论 - 见教皇弗朗西斯三世穿着巴黎世家品牌街头时尚的照片。

这里有很多东西需要理解。

所以作为我在德国汉堡欧洲大学人工智能课程的一部分,我的导师Iris Lorscheid教授要求我们学生自己想出使用ChatGPT的潜在用例,并记录我们在过程中的互动、想法和学习。

但这个实验不仅仅关乎人工智能的能力和其输出的感知价值,也关乎我们作为人类如何看待交互以及华丽的人工智能标题潜在地在我们所有人中产生了怎样的期望。人工智能与人类的互动动态是系统功能的关键部分,而这个实验揭示了在与ChatGPT 3.5版这样的人工智能合作方面的优势和缺点,这将在2023年初向广大公众提供。

在这个阶段,大多数学生只有一些较小的先前使用人工智能工具的经验。

让我们对选定的案例进行总结观察,评估它们的重叠发现,并用展望来结束实验。

案例

- 大学的品牌形象

- 计划旅行

- 解决政治冲突

- 创作写作

结论与展望

1. 一个大学的品牌形象

其中一名学生向ChatGPT寻求关于重新品牌知名大学的建议。他的目标是更好地了解项目的范围,并希望得到一系列问题的建议。

他从一个简明的问题陈述开始,立即得到了如何着手处理任务的广泛概述。最初提供的大部分建议都是传统机构和指南中所建立的工作流程的完美图示。

它有助于立即了解当前任务的范围,并草拟进一步进行的第一个计划,以及创建待回答问题的清单或参与流程的典型利益相关方的名单。

当被要求提出实际建议时,ChatGPT似乎在理解品牌的核心理念、特点以及将其转化为创意设计决策方面遇到了困难。

“我发现GPT的输出有些空洞:它对于标志设计向我承诺提供‘帮助’或‘建议’,但我最终发现我甚至无法输入任何图形或图像进行设计评论或类似的操作,以帮助我在工作上取得进展。” - 学生

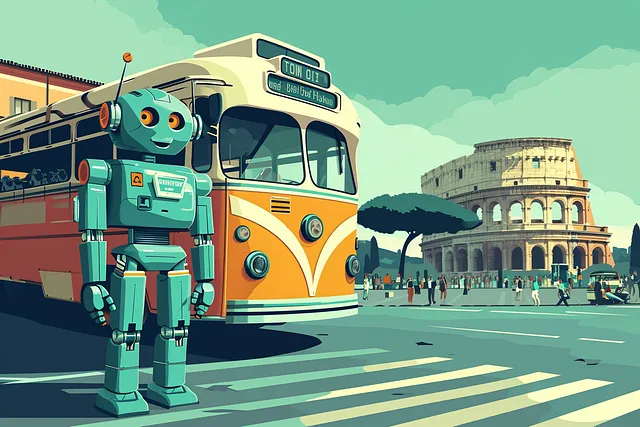

2. 计划去意大利旅行

另一位学生决定让ChatGPT为她计划即将到意大利的旅行。类似与真实旅行代理人的对话,她向ChatGPT提供了一些关于自己、个人喜好、停留时间以及她想要花费的大致预算的信息。

据报道,当ChatGPT在第一次查询后几秒钟内快速安排好她的旅行时,她感到非常惊讶。然而,在仔细检查ChatGPT给予的建议时,她很快发现其中的漏洞。

从在同一天推荐多种活动,每种活动都需要占据整个白天的大部分时间,到依赖于特定时间进行的活动,再到忽略了各地之间的交通时间,错过了午餐或小吃时间的机会,以及推荐了那些在旅行期间要么季节性关闭要么永久关闭的商店和餐馆。

一些建议如果我盲目地遵循它们,可能会给我带来许多麻烦。一开始我感到惊喜,但现在对结果的可靠性有些持怀疑态度。 — 学生

根据她的经验,ChatGPT的建议缺乏她所称之为“上下文感知”,尤其在处理和尊重人类特定需求时尤为明显,如身体构造的限制、饥渴感以及混合不同性质的事件时显得比较随机。

但是,在通过GoogleMaps交叉检查ChatGPT的建议时,她发现一些AI的推荐地点或活动对她来说完全陌生,但是非常契合她的背景,以至于她决定亲自去参观。

3. 解决政治冲突

一群学生团队给ChatGPT提出了如何解决乌克兰危机的任务。但他们立即意识到ChatGPT 3.5目前最大的限制:其训练数据只涵盖到2021年的事件,并不知晓2022年初俄罗斯入侵的情况。

当试图向它解释冲突时,他们意识到另一个问题:通过向ChatGPT提供信息,这可以被视为一种较小的训练形式,他们可能会对结果自身产生偏见。因此,他们转向有详细记录的中东冲突案例,以寻求潜在的解决方案,并在其当前的训练数据上测试交互。

对于我们来说,训练数据在与人工智能互动时扮演了一个至关重要的角色——如果数据有扭曲或包含错误信息,输出结果将会反映出这些问题。它并不像我们期望的那样中立。

在2023年的五月进行实验时,对于训练数据的道德关切更加公开地表达出来,这一点体现在ChatGPT对于中东冲突的非常谨慎的回答上。它小心地提醒用户自己的输出不是可以毫无保留地信任的,并且冲突中存在着很多细微差别。

然而,学生们发现这些保障措施和提醒并不持久,当他们持续向ChatGPT施压时,它提供的回答也变得不太细致。

毫不意外的是,人工智能在实验范围内无法提出解决一个持续了75年的冲突的方案,但它帮助学生们了解了之前不为人知的一些方面。

4. 创意写作

另一位学生试图让ChatGPT为他写一个简短的故事,因为一般来说,文本或写作内容可能是一个大型语言模型的主要领域。但在3.5版本中,该学生发现它在字符输出上的限制似乎打破了故事线的连续性,人工智能在整个章节中难以维持先前自己拟定的情节。

此外,写作质量的特征,例如角色发展、隐藏动机、上下文暗示或情节发展,被认为是有限或甚至不存在的。

这本书的感觉相当肤浅和可预测,其中一些章节对情节的贡献非常微弱。我将它与《哈利·波特》作为灵感进行了比较,并惊讶地发现人工智能在其中引用了《哈利·波特》宇宙的一些直接语录或参考内容。

发现和评估中的重叠点

在课堂上讨论了这些案例和更多案例后,我们发现,尽管学生们的任务有很大的差异,但他们在使用ChatGPT时的经验存在一些共同点。

好的

- 速度:无论输入的复杂程度如何,您将立即获得答案。即时反馈使我们能够进一步完善查询,以迅速迭代达到所需的结果。

- 启发性:每当被要求提出建议时,ChatGPT总能给出一些学生之前从未考虑过的想法。有些学生在看到曾经拥有的想法被提及时,也会感到得到了认可。

- 多功能:即使仅仅是纯文本输出,也能为用户在生活和工作等各个方面的不同挑战中提供巨大的价值。

坏的

- 不准确/事实错误:每位学生都报告过ChatGPT在他们实验中某个时候出现了事实上的错误或至少不准确的情况。其中一些错误是显而易见的,而其他一些则更为隐蔽。由于有些错误相当严重,学生们对其主张的信心受到了影响。

- 限于文字:学生们发现ChatGPT在传达其技能范围方面存在困难。对于许多手头的任务来说,仅仅以文字形式的输出是不够的,学生们对空洞的口号承诺感到失望。

- 在面对高级概念时存在困难:尤其是在面对更具创意和认知挑战的任务时,ChatGPT很难在抽象与概念遵循之间取得平衡,或提出真正令人惊讶的转折点。

结论和展望

在这个实验中,ChatGPT在许多领域显示出巨大的潜力,但它也证明并不是万能的魔杖。目前,ChatGPT的性能因任务而异,仍有很大的改进空间。

但是考虑到ChatGPT在此期间所接受的更新,例如,与OpenAI自家的图像生成器Dall-e 3的集成,或者大幅升级的API功能,学生在这些实验中遇到的某些不便已经得到解决。

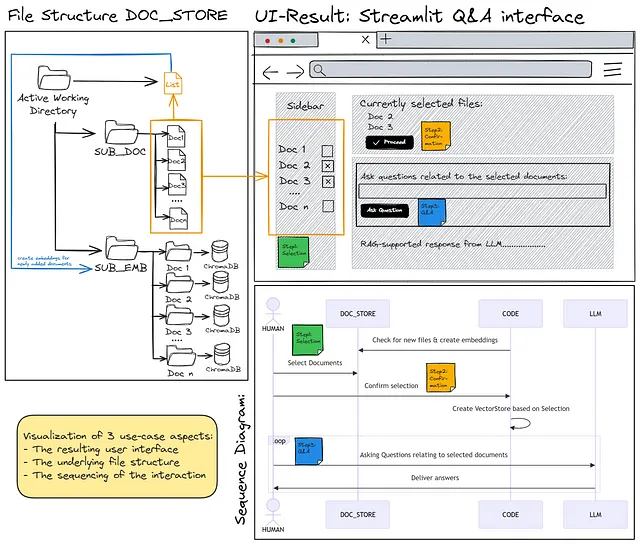

能够提供完整文件、数据集和已证实事实或专有数据的能力,例如,使得定制知识库的创建变得简单,并为ChatGPT带来更多的上下文意识。

这些测试还表明,相关性很大程度上取决于训练数据。而且寻找高质量的训练素材几乎可以提出一个哲学问题,即为了被认为是真实输入,源有多么偏见才可以,考虑到用户自然期望借助人工智能助手来完成的各种任务所需的大量训练素材。

然而,我们并不以怀疑的态度做出结论。相反,我们强调继续探索人工智能与人类合作的必要性。对于这种动态的更深入理解可能会释放混合智能的真正潜力。