在2024年,超越炒作,在使用人工智能方面负责任地前进...

这些天在使用社交媒体时,遇到“人工智能”这个术语并不罕见。即使非科技专业人士也会接触到数百篇介绍和使用自动化技术的文章和产品。如果你正在阅读这篇文章,你知道我说的并不是不真实的。

但是,就像其他商业上推出的新产品一样,人工智能和自动化也有它们的副作用。

什么是负责任人工智能?

对于我们人类来说,构建新产品和进步的动机是为了使全世界每个人的生活更加舒适。

无论何时我们构建一个新的工具,首先我们需要了解人们将如何使用它,以何种方式它将影响人们,并且这款新产品的前端和活动顺序会如何被普通大众解读(普通大众会受到前端和活动顺序的诱惑和动力)。了解人们如何在其中看到自己的影子是非常重要的。

负责任的人工智能是采用以人为中心的设计方法构建的人工智能,旨在实现公平、隐私和安全。

国家已经在推动人工智能的透明化使用:印度、中国、美国等。

负责任的人工智能是如何建立的?

我们首先必须了解潜在危害的现状,以便在产品生命周期中更好地识别和最小化它们。

使产品开源或公开可以使其受到成千上万的开发者和客户的评判,有助于提取和消除存在的错误。

因此,我们通过研究和社区参与来识别算法技术可能造成的潜在危害。

发现的风险现已映射到称为危害分类体系的东西中。

这个概念有助于我们负责任地建设,这对于那些通常不关注技术发展的人们来说至关重要。

例如,我们必须考虑正在构建的工具如何可能产生有害的刻板印象或对不同群体的人产生性能差异。

使用以下方法筛选内容:

- 安全分类器

- 数据集

- 政策

- 设计原则

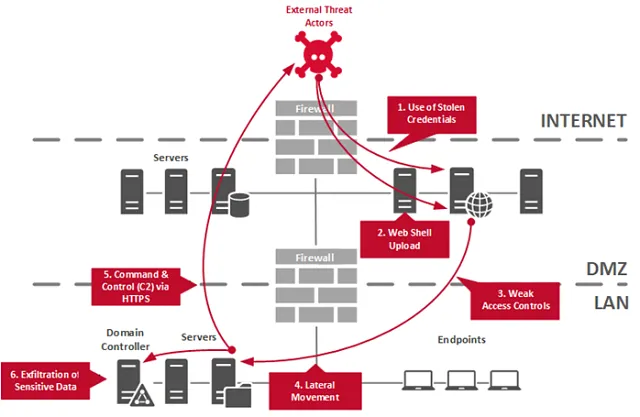

测试人工智能

这一步与任何其他构建负责任产品的步骤一样重要。我们使用红队演练的过程来测试我们产品的能力。

红队评估AI

它迫使我们重新思考如何开始测试。

最初,我们正在设计首个的测试方法,以了解我们的模型实际能够做到什么。

其次,我们承认积极的案例以及所涉及的风险。

第三,我们将案例分为高重要性和低重要性的类别。

了解OPENAI红队网络。

以负责任的方式发布人工智能产品

对于我们的AI产品,充分考虑使用案例和意图至关重要,以便用户能够对如何与其进行交互做出有意义的决策。

因此,用户可以通过了解数据的使用方式和目的来更好地掌控自己的数据。

我们可以通过以下步骤来接触更多人:

- 进行工作坊,让人们意识到。

- 采纳他们关于修改或添加新功能的反馈意见

- 他们的反馈不仅会应用到我们的产品中,还会应用到用户指南和教育材料中。

这些工具有巨大的潜力,因此人们应该可以使用它们,但同时也要确保我们下一步的安全。

让我们联系起来,一起建立一个项目:🐈⬛