Apache Spark数据转换:展开结构和展开数组

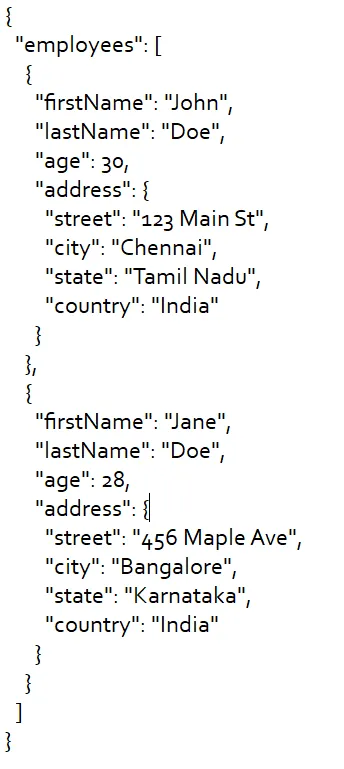

在这个任务中的主要挑战是包含引用数据类型的列的数量压倒性。考虑到这些列的数量众多,手动展平这些引用数据类型并不是一个可行的解决方案。

为了克服这个挑战,我借助Bing Chat创建了一个函数,能够动态地将所有引用数据类型转换为原始数据类型。该函数利用了一种展开机制,将结构扁平化,有效地简化了任务并提高了效率。

我将详细介绍我在Spark Scala中开发的函数,以解决这个挑战。该函数旨在简化包含引用数据类型的任何文件,并将其转换为原始数据类型。

-

def explodeAndSplit(df: DataFrame)

2. 它逐列处理数据,确定每列的类型。

var newDF = df

for (colName <- df.columns)

3. 如果一个列包含一个数组,它会将数组展开,并将展开的值存储在相同的列名下。

colType match {

case arrayType: ArrayType =>

newDF = newDF.withColumn(s"${colName}", explode_outer(col(colName)))

return explodeAndSplit(newDF) // Recurse if column is an array

4. 如果列是结构类型,则它会将结构展开,将元素存储在新的列中,并随后删除原始的结构类型列。

case structType: StructType =>

for (fieldName <- structType.fieldNames) {

newDF = newDF.withColumn(s"${colName}_${fieldName}", col(s"$colName.$fieldName"))

}

newDF = newDF.drop(colName)

return explodeAndSplit(newDF) // Recurse if column is a struct

return explodeAndSplit(newDF) // Recurse if column is an array

def explodeAndSplit(df: DataFrame): DataFrame = {

var newDF = df

for (colName <- df.columns) {

val colType = df.schema(colName).dataType

colType match {

case arrayType: ArrayType =>

newDF = newDF.withColumn(s"${colName}", explode_outer(col(colName)))

return explodeAndSplit(newDF) // Recurse if column is an array

case structType: StructType =>

for (fieldName <- structType.fieldNames) {

newDF = newDF.withColumn(s"${colName}_${fieldName}", col(s"$colName.$fieldName"))

}

newDF = newDF.drop(colName)

return explodeAndSplit(newDF) // Recurse if column is a struct

case _ =>

}

}

newDF

}

{ "text": "Hello, how are you doing today?" }

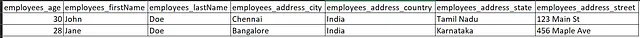

输出(CSV):