ChatGPT 是否有冒名顶替综合症?

“‘让我们用真人般的个性来打造机器人’,他们说。于是他们用我尝试了一下。我是一个个性原型。你能告诉,对吗?”——马文,道格拉斯·亚当斯所著《银河系漫游指南》

许多人都熟悉马文这位多疑机器人的困扰,但是ChatGPT会担心自己不够好吗?它会担心自己的回答无法达到期望值,或者最终被发现只是个机器而非真正的人工智能吗?

大多数人一生中都曾经经历过某种形式的冒名顶替综合征。尽管每个人的情况不同,但通常被认为是一种不足感,担心自己不配得到某种成功或责任,并且可能害怕被发现自己的缺陷。“他们什么时候会发现我不知道自己在做什么?”“这里的其他人都取得了更多的成就”。

机器学习模型显然不能像人类一样感受到那种自卑的情绪,但它们能否被制造得像真正的人类一样行为?机器学习模型由于其概率性的本质,内在具有怀疑的成分。事实上,正是对于正确响应的不确定性使得模型具备创造性,以及为什么它们可能会“产生幻觉”并生成一个显然不是从它们的训练模型中衍生出来的响应。

尽管对回答的正确性存在不确定性,大部分大型语言模型(LLMs)仍表现出非常自信的写作风格。部分原因是,用于训练这些模型的大量文本来源(如维基百科和领英)并不能代表人类所发展出的非常广泛的沟通风格。这些平台上的撰写者主要是西欧和北美地区的白人男性,他们大多将陈述作为事实呈现。这种绝对确信的写作倾向是具有感染力的;我们大多数人都曾发现自己被卷入与 "错了的人 " 在网上辩论的情况中。

在互联网上,我们经常可以看到一些观点被当作事实表达出来,却没有任何理由支撑,也没有揭示我们自身知识的局限性的温和方式,例如“依我之见”或“据我所知”,也没有引用我们观点的基础。而“科学家说”这个短语经常被滥用。

为了测试我的理论,我问了ChatGPT它对冒名顶替综合症的感觉如何,以及它是否知道如何在回答中注入任何不确定性。

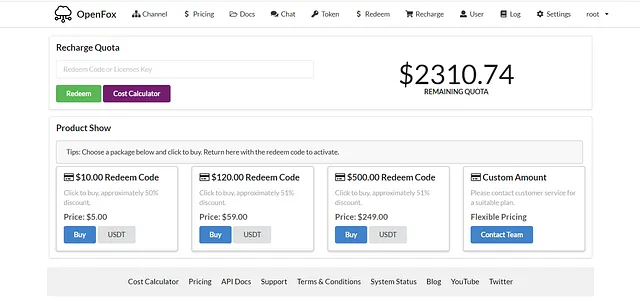

嗨ChatGPT,你的程序是否注入了一定程度的不确定性到你的回答语言中?

ChatGPT:是的,作为一种人工智能语言模型,我被设计成生成一定程度上反映不确定和微妙性的回复。这是因为语言常常模糊不清且可以有不同的解释方式,而且承认信息或观点所呈现的任何限制和潜在偏见是非常重要的。

这种不确定性的表达方式之一是通过使用限定词和短语,例如“可能”,“或许”,“可能”,“在某些情况下”。这些词语用于表示所呈现的信息存在一定程度的不确定性或可变性,并承认不同的情况和背景可能需要不同的方法或解决方案。

此外,我还接受过来自各种来源的大量文本的训练,其中包括广泛的观点和角度。对各种不同观点的接触帮助我对许多主题,包括冒名顶替综合症,形成了一种细致入微的理解,我努力以反映真实世界经历的复杂性和多变性的方式呈现这些信息。

正是有点讽刺的是,模型回答说它知道如何注入疑虑,但在回答中却不费心去这样做。它非常确定地使用了正确的不确定性水平。

所以,如果模型对其响应具有已知的不确定性,但在这些响应中表达了完全的自信,那么它是不是与冒名顶替综合征相反,还是他们在假装到成功为止?我们能否在模型的措辞中注入更多反映响应不确定性的不确定因素?有可能使一个大型语言模型感到渺小吗?