GPT生成文本的可预测性:揭示机器创作的显著特征

在计算机世界中,人工智能在自然语言处理领域取得了显著的进展,催生出像GPT(生成预训练变换器)这样能够产生连贯且上下文恰当的文本工具。虽然GPT的能力令人印象深刻,但它并非完美无瑕,经过仔细审查会发现,它生成的文本常常展示出独特的模式和怪癖,透露出它非人类来源的特征。

在本文中,我们将探讨GPT生成的文本可预测性背后的原因,概述模型和人类作者共享的一些写作怪癖,并讨论为什么这些模式明显表明文本不是由人类创作的。

重复的用语

GPT 生成的文本中最突出的一个特点是倾向于使用重复的措辞。例如,在描述一个观点时,模型可能会以各种方式重复相同的概念。尽管这种使用同义词的重复没有语法错误,但往往让文本感到单调,缺乏人类作家所使用的微妙差别。人类作家更擅长使用多样的词汇来表达观点,避免不必要的重复。

缺乏个人经验

养成HTML结构,将以下英文文本翻译成简体中文: GPT生成的文本常常缺乏个人经验或逸闻轶事元素,而这些通常融入到人类的写作中。人类常常借鉴自己的个人经历、情感和观点,这些都为他们的散文赋予了独特的特质。GPT由于没有意识,无法传达人类写作中所蕴含的真实情感和丰富体验。

不一致的语调和风格

GPT生成的文本经常在一篇写作中展示出不一致的语调和风格。一个人类作者通常会在一篇文章、论文或故事中保持一致的语调和风格。然而,GPT可能会突然改变语调,使得文本的不同部分明显地独立生成,然后拼接在一起。这些突然的变化可能会破坏写作的流畅性和连贯性。

缺乏原创思维

最具代表性的GPT生成文本的特征之一是缺乏原创思维和创造力。该模型依赖于其所训练的大量文本语料库来生成回答,导致生成的文本缺乏新颖性和真正的创新。人类作者通常会在他们的作品中带来独特的观点和创造力,引入新鲜的思想和概念,使他们的写作与机器生成的文本有所区别。

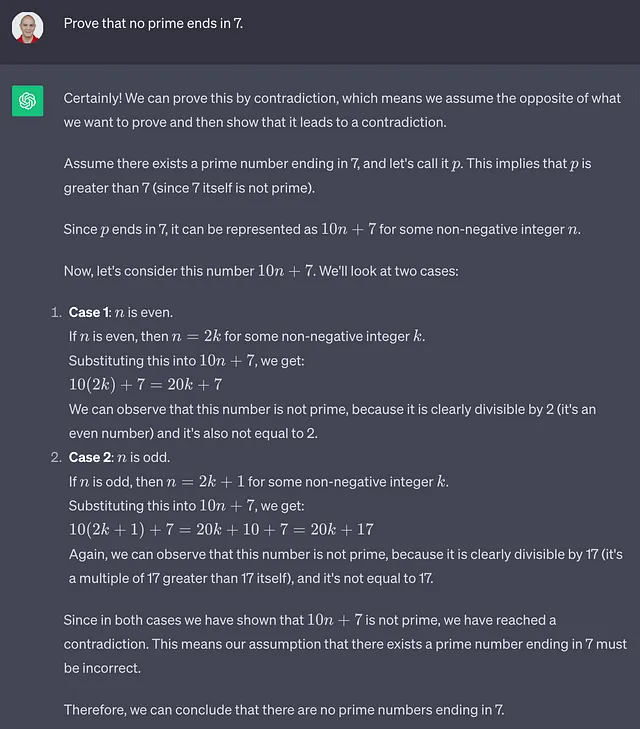

误解的背景

GPT有时会误解特定提示的上下文,导致回应看起来奇怪或不相关。这是因为GPT依赖于训练数据中的统计模式来生成文本,可能无法完全理解特定上下文或主题的微妙之处。相比之下,人类作家可以运用他们的理解和批判思维能力来产生与上下文相适应的内容。

冗长而过于正式的语言

GPT生成的文本常常倾向于冗长而使用过于正式的语言,使其听起来比必要的更加复杂。这种冗长可能会使文本对普通读者不太容易理解,因为人类作者在写作时通常追求清晰简明。

结论

基于以下几个因素,GPT生成的文本具有可预见性:重复用语,缺乏个人经验,语调和风格不一致,缺乏原创思维,对上下文的误解以及冗长的语言。虽然GPT是一个强大的语言模型,能够生成看似非常令人信服的文本,但在进行更仔细的审查时通常会显得不够出色。

这些怪癖和模式是机器生成文本的特点,清晰地表明这段文本并非由人撰写。对于阅读者和GPT生成内容的用户来说,在评估文本的真实性和可靠性时保持警惕和批判性非常重要,因为区分人类创作和机器生成内容的能力在我们越来越依赖人工智能的世界中将继续增加其重要性。

这篇论文是由Chat-GPT生成的。

通过阅读它,你可以看出它有一种模式。它总是以这种方式写。很容易判断出是某人自己写的还是Chat-GPT生成的。