解读LLM的好奇心:解开我们从顾客那里听到的五个最常见问题

由Christy Maver撰写,Numenta副总裁营销

ChatGPT的崛起凸显了转换器和大型语言模型(LLMs)在人工智能中的重要性。然而,尽管它们提供了不可否认的好处,但在生产环境中部署LLMs并非易事。它们可能部署成本高,难以管理,并且扩展性具有挑战性,更不用说它们引入的数据隐私和安全问题了。几乎每位我们今天与之交谈的客户都对LLMs有疑问。在本博文中,我们将分享我们收到的5个最常见的问题,并逐一介绍我们如何解决每个问题。

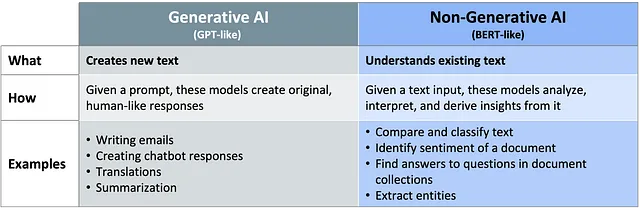

如何在内部引入生成式人工智能能力?

由于极度重视生成式人工智能和ChatGPT,许多公司将GPT模型视为实际上的起点。然而,在实际情况下,大多数用例并不需要生成模型。使用非生成式的类似BERT的模型可以更高效地解决这些问题。为了正确权衡,您应该首先看一下您尝试解决的业务问题。你是否需要创建新的文本?你是否需要生成逼真且类似人类的响应,以适应各种提示?如果是这样,那么您可能需要一个生成模型。但是,如果您在给定的文本中寻找答案,并希望避免出现错觉或提供不安全和不可预测的答案,则非生成式模型可能最适合。

如果您确实需要生成式人工智能模型,请不要假设您需要一个庞大的100B+参数的GPT模型来解决您的问题。我们发现较小且专用的模型提供了几个优势。在许多情况下,对一个大约100M至600M参数的小模型进行微调比使用数十亿参数的GPT模型进行上下文学习要表现得更好。

Q:如何为我的使用案例选择最佳模型?

随着如今可用的模型数量的增加,很难确定使用哪一个。有许多不同的变量需要考虑,这将有助于决策形成。一个主要的考虑因素可能是模型在提供正确结果方面的准确性。不同的模型提供不同级别的准确性,在某种水平上,递增的好处可能会递减。

然而,选择一个模型很少像选择准确率最高的那个那样简单。其他因素也会起作用,比如模型能够多快地产生结果。例如,如果你正在运行一个时间敏感的应用程序,速度可能比准确率更重要。

除此之外,您还需要将速度和准确性与成本进行权衡。往往情况下,您的预算会决定您选择的模型。诸如计算资源需求、维护、法规或合规问题以及数据隐私等因素可能也会影响您的决策。

最终,选择合适的模型是一个需要对整体情况进行权衡的行为。

Q:Numenta已经看到了一些更常见的用例是什么?

保持HTML结构的情况下,将以下英文文本翻译成简体中文: 当我们与客户交谈时,我们最常见到的使用情况是文档理解,也就是解释大量文本文档中的内容、结构和背景的能力。文档理解需要使用在大量数据上经过训练的语言模型,以将非结构化数据转化为可以进行有意义的分析、组织和分类的结构化数据。不同行业的示例各不相同。合同分析是一个常见的示例,它涉及使用语言模型来分析法律合同,提取相关信息,加快审查过程,并使合同更易被搜索。

我们经常看到的另一个用例是情感分析,即能够理解文本中客户的态度、观点和情感表达的能力。这是通过使用LLMs来基于情感对文本进行分类来实现的。这些文本可能来自社交媒体帖子、评论、电子邮件或客户聊天。在这些示例中,LLMs需要能够理解微妙的情感,识别讽刺甚至检测到讽刺。情感分析对于希望提供更复杂的客户支持系统的任何人来说都至关重要-这些系统可以识别复杂的查询,了解客户的情绪,并提供个性化的回应。

最后,我们看到了对生成型人工智能的兴趣激增,包括实时翻译、文档摘要、生成智能代码或在对话式人工智能聊天机器人中提供类似人类的回应等用例。

Q:Numenta采用的是基于神经科学的方法,为什么我们认为它是最优的呢?

我们的技术基于数十年的神经科学研究,其中我们的联合创始人杰夫·霍金斯在他的书《一千个大脑》中进行了描述。理解使大脑成为最高效的智能机器的关键原理,为我们处理当今面临的人工智能挑战提供了独特的视角。

我们开发了一种基于我们的神经科学发现的人工智能平台,为CPU上的LLMs带来了前所未见的性能提升。随着我们不断将更多神经科学原理融入我们的技术,最终将能够实现今天无法想象的智能能力,如持续学习和泛化。我们所取得的重大进步,以及我们丰富的神经科学研究历史的支持,为智能计算铺就了长期发展的道路。

Q: 如何入门?

要开始使用我们的AI平台,只需联系我们进行演示请求。

使用我们的人工智能平台,客户在CPU上的推理速度提高了10-100倍,从而实现了显著的成本降低、能量效率提升和生产力改善。您可以访问我们的案例研究页面以获取更多信息。

我们平台的另一个关键特性是其完全在您现有的基础设施内运行的能力。这意味着您所有的模型和数据始终保持私密,并完全在您的控制之下。此外,我们的平台与云环境无关,可以在任何云服务提供商或本地部署上运行。它可以作为轻量级容器化解决方案轻松集成到您现有的MLOps工具中。这使您能够在当前设置中运行我们的平台,而无需对现有基础设施和运营进行重大改变或干扰。

如果您对我们的AI平台如何帮助您简化大规模语言模型的部署感兴趣,请联系我们以请求演示。

如果您喜欢阅读这篇文章,请点击下方的“鼓掌”图标向您的关注者推荐。欲了解更多,请访问我们的网站或在领英上关注我们。

最初发布于2023年7月28日,位于numenta.com。