新闻媒体中的生成AI:这里有6个原则来解决多样性和包容性问题(这只是很好的新闻报道)。

人工智能在多样性方面面临深层次的问题:机器学习算法受历史数据影响可能存在制度性歧视,自然语言处理和生成式人工智能也面临同样的问题,而人工智能行业本身也面临多样性挑战。

令人惊讶的是,围绕生成式人工智能的讨论在该行业出现,却迄今未能涉及这些问题:英国监管机构Ofcom本月早些时候发布的新闻稿没有提及;美国广播电视数字新闻协会的新指南也没有提及。BuzzFeed从其对该技术的使用中吸取的经验和讨论未涉及此问题;虽然受到该技术的影响,但CNET的政策没有提到偏见。

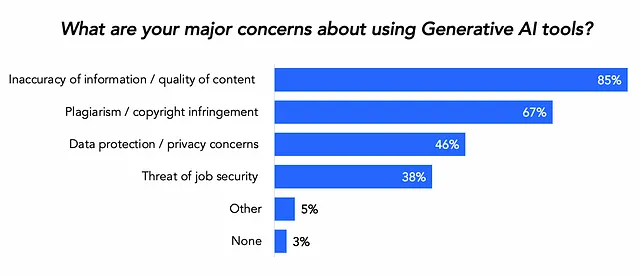

Wired在关于使用生成 AI 的声明中提到了偏见,但仅涉及生成内容的部分,而没有涉及生成想法或研究的部分。我见过的组织中最接近的是卫报新发布的原则,在广泛的范围内提到“防范偏见”。但是看看WAN-IFRA所进行的行业调查中有关生成 AI 的主要关注点,你不会看到偏见被提及。

而“多样性”这个词呢?在这些文件中你找不到它。

这就是为什么我和伯明翰城市大学的同事Diane Kemp和Marcus Ryder两周前坐下来起草一些核心原则,以开启关于这个问题的重要讨论。

使用生成型人工智能与多元包容的负责任新闻学原则六项

使用生成AI和多样性和包容性的负责任新闻使用的六项原则旨在提供一个起点,讨论我们如何确保涉及生成AI的新实践和工作流程不重复历史上的错误,并确保新闻记者有一些实用的技巧开始尝试生成工具。

原则是:

- 注意内置偏差:很容易忘记,生成式人工智能本质上具有偏见,就像任何来源一样。我们需要确保记者从这个角度开始考虑,这会导致...

- 将多样性融入您的提示:良好的提示编写对于有效使用人工智能至关重要,就像优秀的记者知道如何询问好问题一样,他们也应该知道如何编写好的提示-这包括确保多样性得到积极提示。

- 认识到来源材料和引用的重要性:这是另一项熟悉的新闻技巧:我们应该始终知道信息的来源,并确保这些来源不仅代表最响亮的声音。例如,当被提示“20世纪最重要的20位演员是谁?”时,ChatGPT没有列出任何有色彩的演员;当被问及温斯顿·丘吉尔或美国开国元勋时,它未包含重要的关键事实。我们会反驳人类的这些答案,所以对于生成式AI来说,做同样的事情非常重要。

- 报告错误和偏见:人工智能仍在学习中-了解您的使用如何反馈到其中非常重要。

- GAI 生成的文本应该以新闻学的怀疑态度来看待:再次强调一个核心新闻学特征(我会争辩认为生成 AI 生成文本的能力将被证明是它较不实用的应用之一)。

- 在适当的情况下保持透明:AI的应用范围非常广泛,很难说你应该总是透明,但这应该是一个考虑因素。

这些原则是起点。我们非常欢迎您提供反馈、示例、技巧和其他想法,以便我们继续完善它们。

该帖子最初发布于在线新闻博客上。