解码器-only Transformer 模型

用 GPT-1 理解大型语言模型

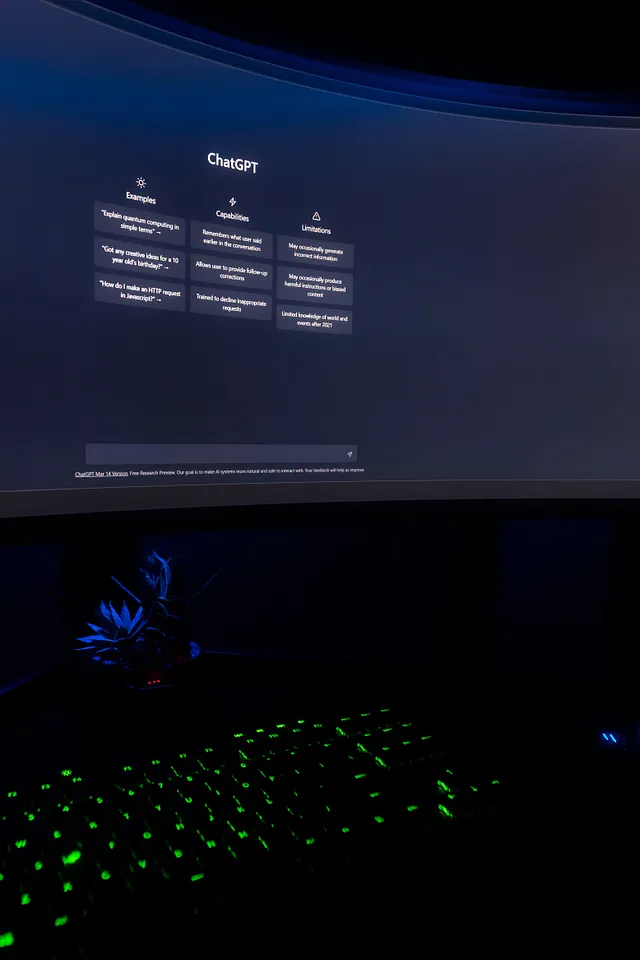

在过去的6个月中,无论在互联网的哪个角落,"ChatGPT"都是一个热门术语。实际上,下一个十年将是生成模型的十年,这已得到认可。

有许多生成模型,例如自回归模型,变分自编码器,归一化流模型,生成对抗网络等。

ChatGPT可以被认为是深度生成模型的语言处理应用之一。GAN(生成对抗网络)的DeepFake是深度生成模型的计算机视觉应用之一。生成模型是统计机器学习和人工智能中令人兴奋且快速发展的领域。

研究基于语言的生成模型。

ChatGPT的主要构建基于OpenAI的GPT-3模型的改进版本,该版本被称为GPT-3.5。

GPT是什么意思?

OpenAI的第一篇介绍GPT模型的论文名为《通过生成式预训练改善语言理解》。因此,GPT一词来自于输生成式预训练。

GPT-1 模型的核心是 Transformer 模型的解码器部分。因此,要理解 GPT-1 模型(或任何 GPT 模型),就必须理解 Transformer 模型。

在这篇研究论文中,Generative pre-training 被描述为一种能够用未标记的数据训练语言模型并实现准确预测的能力。

在本文末尾,让我们重新审视生成式预训练并澄清它。

在Transformer博客中,我清晰地解释了Decoder部分。GPT-1模型的Decoder块与Transformer的Decoder块没有区别,除了Decoder块中多头注意力层中的微小差别。因此,我将尝试提供GPT-1模型的高级架构概述。