LLM中的紧急能力:大型语言模型中的不可预测能力

新兴能力指从简单组件的复杂互动中自发出现的能力,是无法仅根据单独组件预测的属性,只有当这些组件作为一个整体开始相互作用时才会显现。这个迷人的概念源于各个领域,如生物学、物理学、社会学以及最近的人工智能(AI)。

定义新兴能力

术语“ Emergent” 源于拉丁词语“emergere”,意为“浮现”或“出现”。因此,Emergent 能力指的是从系统中“浮现”或“出现”的能力。这些能力并没有明确的编程或设计,而是从系统组件的相互作用中自然产生。

为了更好地理解这个问题,可以想象一群鸟群。每只鸟都遵循简单的规则:靠近邻居,避免碰撞,沿着相同的方向移动。然而,当这些个体行为结合在一起时,它们创造了一种令人着迷的动态模式,称为鸟群。这种集体行为是系统的一种新兴特性,因为单个鸟的行动无法预测或解释。

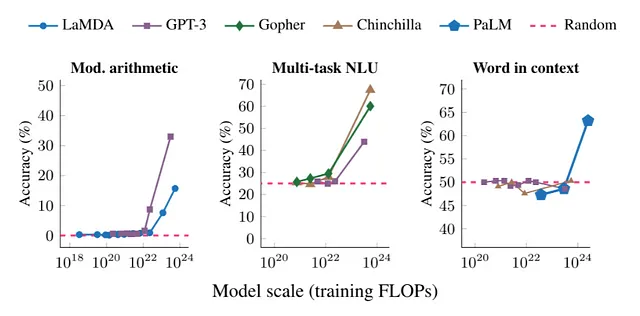

在LLM(大型语言模型)的背景下,新兴的能力是指人工模型与环境互动或受大量数据训练时表现出的意外行为。例如,OpenAI开发的语言模型GPT-3已经展示出了惊人的能力,而这种能力并不是明确地编程到其中的。这种能力是从模型在各种互联网文本上的训练中“出现”的。推理能力、低资源语言翻译、数学问题解决被认为是LLM的新兴属性。Jason Wei维护了一个包含137种LLM新兴能力的博客。已知在13B参数以下的模型中,数学能力是不存在的,同样,在具有100B+参数的模型中存在推理能力。如果您是一个习惯于阅读科学论文的人,强烈推荐阅读这篇论文(来自同一作者Google的Jason Wei)。

紧急能力,如推理,是如何产生的?

这是一个重要的问题,可以在生产级别系统中规模化部署LLMs,从而实现跨越式的进展。今天,在大多数离线场景中,推理能力被看作是100B+模型参数大小,这对于那些不敏感于延迟的情况下工作的场景来说是有效的。关键问题是:“我们能否在更小的模型7B,13B模型中获得类似推理的新兴能力,这些模型更适用于在线延迟敏感的使用场景?”

紧急能力的原因被认为在于规模,即更大的数据集和更大的参数。然而,最近的一系列研究发现编码任务与LLMs的推理能力有关的经验性证据。傅耀认为编码任务涉及将复杂问题(面向对象编程)分解成可以粗略映射到高级问题解决和编码的对象+编码需要跟踪状态,例如:打开和关闭括号提供关注更长的上下文窗口,这些都共同给予了推理世界的能力。截至本文撰写,大多数研究者和开发者社区认为编码LLMs与通用LLMs是分开的。如果这一见解真实有效,我们可以生成具有类似于GPT3和4等的推理能力的较小的LLMs。

然而,研究新兴能力的起源是NLP或LLM领域的一个活跃研究领域。揭示这种洞察力将对我们如何适应生产级系统中的LLM产生重大影响(类比物理学——很像解决室温下超导的重要性)。

我想以这样的话结束这篇文章,尽管推理不是唯一的涌现能力。但它被认为是解锁LLMs中人工通用智能的关键能力之一。欢迎分享您对这个话题的想法和评论。